综合介绍

CleverBee 是一个开源的 AI 研究助手,托管在 GitHub 上,由 SureScaleAI 开发。它通过大语言模型(如 Gemini 和 Claude)结合网页浏览技术,帮助用户快速收集、分析和总结信息,生成带引证的研究报告。用户可以轻松获取网页、PDF、YouTube 视频或学术资源的精准内容。CleverBee 支持云端和本地模型,适合学术研究、商业分析等场景。它的界面基于 Chainlit,操作简单直观,配置灵活,适合个人和研究团队使用。

功能列表

- 支持多种大语言模型,包括 Gemini、Claude 和本地 GGUF 模型。

- 自动化网页浏览,提取 HTML 内容并清洗为结构化数据。

- 生成带引证的研究报告,包含来源引用和限制说明。

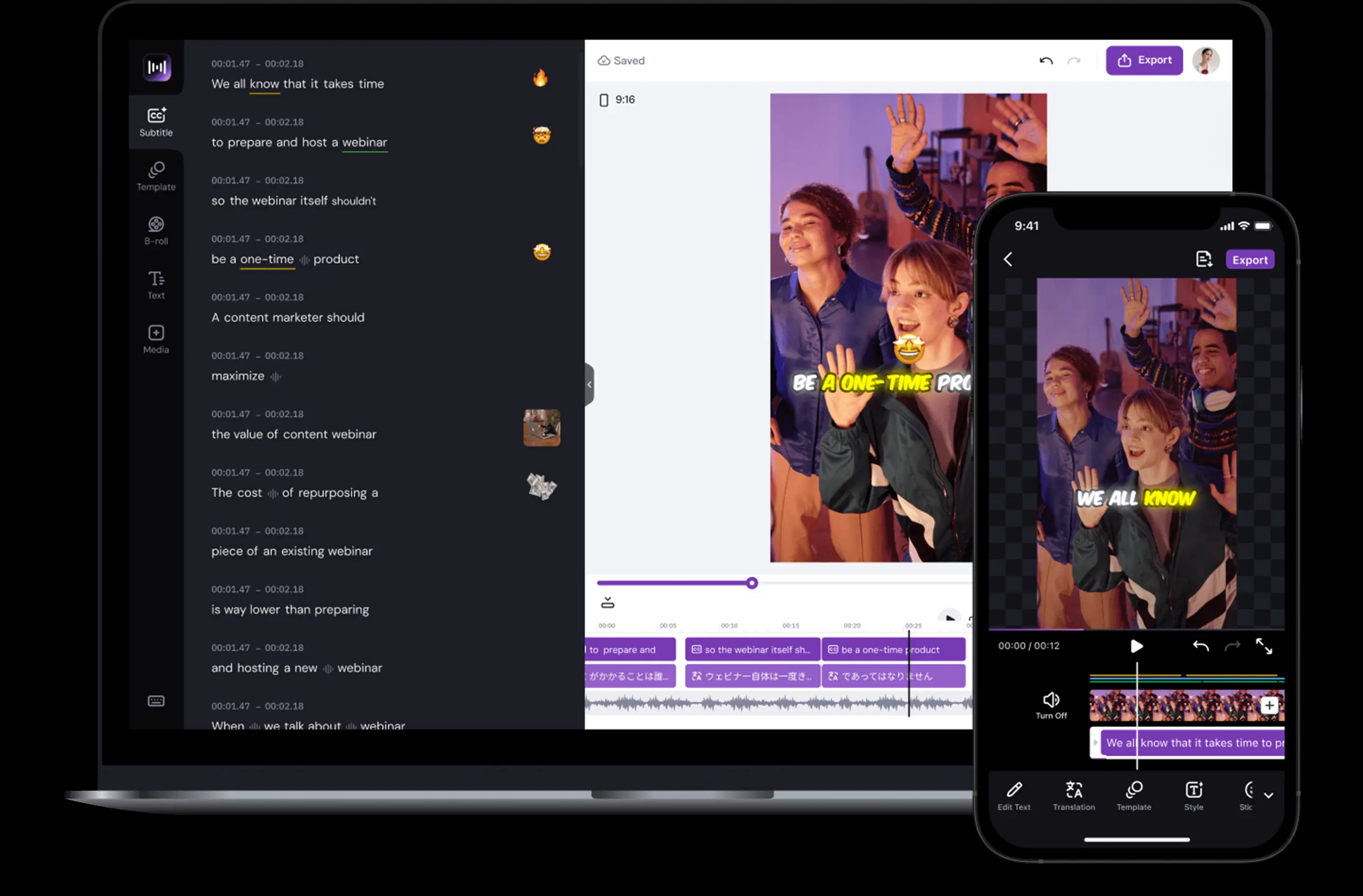

- 支持 YouTube 视频字幕提取、PDF 解析和 PubMed 学术搜索。

- 提供实时令牌使用量和成本追踪,优化资源管理。

- 通过

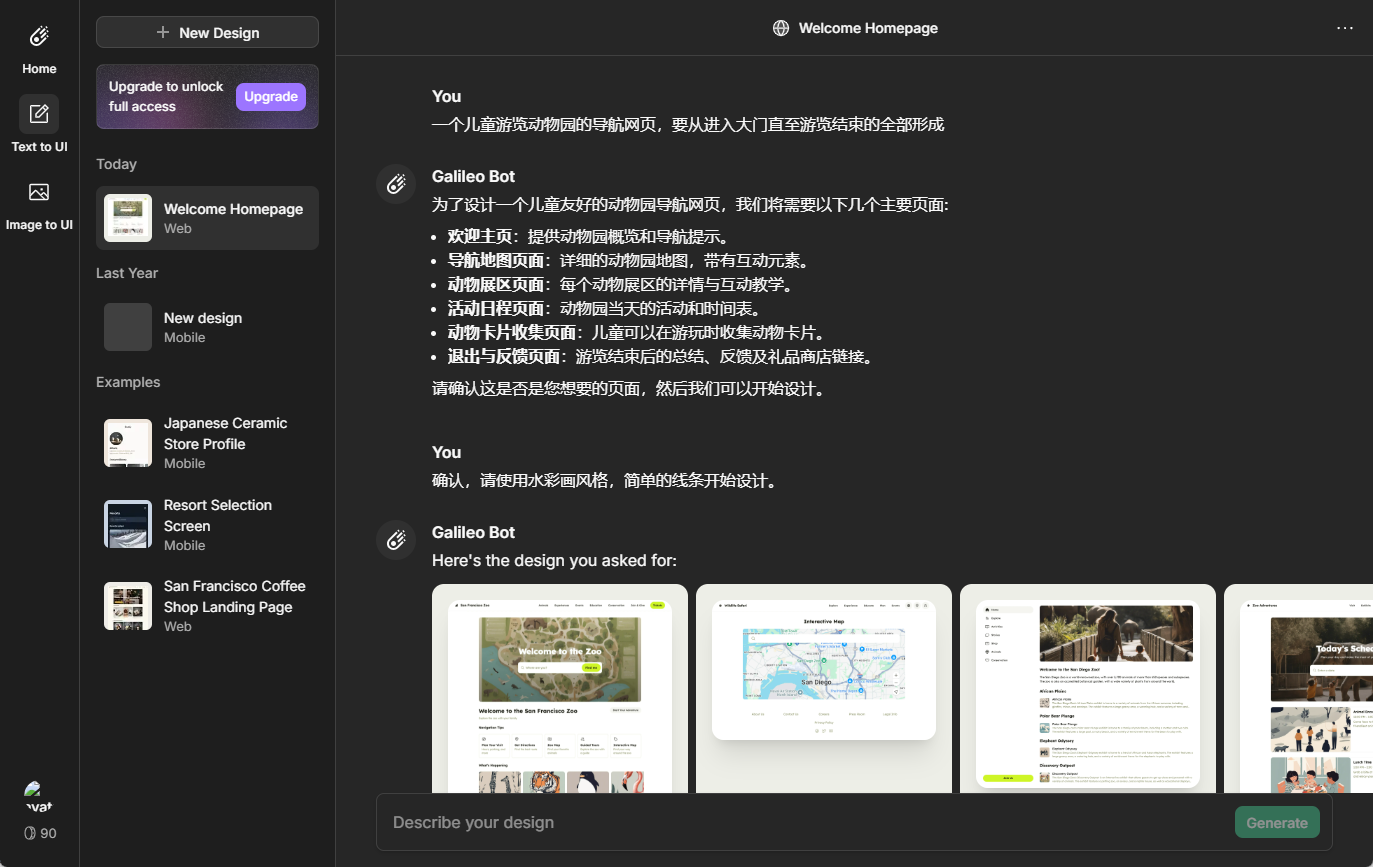

config.yaml文件自定义模型、浏览器行为和研究工具。 - 集成 Chainlit 交互式界面,方便用户输入查询和查看结果。

- 使用 SQLite 数据库的 NormalizingCache 缓存,提升性能并降低成本。

使用帮助

安装流程

CleverBee 的安装过程简单,通过 GitHub 仓库提供详细指导。以下是具体步骤:

- 克隆仓库

打开终端,运行以下命令克隆 CleverBee 仓库:git clone https://github.com/SureScaleAI/cleverbee.git cd cleverbee

- 运行安装脚本

执行安装脚本以配置环境:bash setup.sh该脚本会自动完成以下任务:

- 检查必要依赖(如

python3、jq、yq和cmake)。 - 创建 Python 虚拟环境 (

venv/)。 - 安装

requirements.txt中的 Python 依赖。 - 检测硬件,询问是否启用本地模型(推荐 NVIDIA GPU,显存 ≥ 24GB)。

- 如果选择本地模型,安装

llama-cpp-python并启用 CUDA 加速(适用于 NVIDIA GPU)。 - 提示用户登录 Hugging Face(若使用本地模型)。

- 帮助配置主要推理模型和总结模型,更新

config.yaml。 - 下载选定的本地 GGUF 模型(若适用)。

- 检查必要依赖(如

- 配置 API 密钥

如果使用云模型(如 Gemini 或 Claude),需提供 API 密钥。安装脚本会检查模型选择并指导用户将密钥添加到.env文件:- Anthropic API 密钥:从 Anthropic 控制台获取,适用于 Claude 模型。

- Google Gemini API 密钥:从 Google AI Studio 获取,适用于 Gemini 模型。

密钥添加后,需重启应用以生效。用户可随时编辑.env文件更新密钥。

- 启动应用

安装完成后,运行以下命令启动 CleverBee:bash run.sh这将启动 Chainlit 交互式界面,用户可通过浏览器访问。

系统要求

- 操作系统:支持 macOS(Intel 和 Apple Silicon,需 Rosetta 2)和 Linux。

- 硬件:云模型无需高性能硬件;本地模型推荐 NVIDIA GPU(显存 ≥ 24GB)。

- 依赖:确保安装

python3、git、jq、cmake和node。macOS 用户可通过 Homebrew 安装:brew install python cmake git jq node

使用方法

CleverBee 的核心功能是生成带引证的研究报告。以下是详细操作流程:

- 启动界面

运行run.sh后,浏览器会打开 Chainlit 界面。用户可在此输入研究问题或主题,例如“量子计算的最新进展”或“可持续能源的经济影响”。 - 输入查询

在界面输入框中输入问题。CleverBee 会自动规划研究路径,调用网页浏览工具、YouTube 字幕提取或学术搜索模块收集信息。用户可实时查看研究进度。 - 查看报告

研究完成后,CleverBee 生成包含以下内容的报告:- 综合总结:基于收集的信息生成简洁结论。

- 来源引证:列出所有参考资料的链接或出处。

- 限制说明:说明 AI 可能存在的局限性,提醒用户核查来源。

- 令牌使用量:显示模型调用过程中的资源消耗。

- 自定义配置

用户可编辑config.yaml文件调整设置,例如:- 更改主要推理模型(推荐 Gemini 2.5 Pro)。

- 设置代理行为(如网页浏览深度)。

- 调整令牌限制或缓存策略。

配置文档位于https://cleverb.ee/docs。

- 特色功能操作

- YouTube 字幕提取:输入 YouTube 视频链接,CleverBee 自动提取字幕并整合到报告中,适合分析讲座或访谈。

- PDF 解析:上传 PDF 文件,CleverBee 提取文本并总结关键内容,适用于学术论文或报告。

- PubMed 搜索:输入医学相关主题,CleverBee 从 PubMed 数据库检索权威文献。

- 实时成本追踪:界面显示每次查询的令牌消耗,帮助用户优化预算。

注意事项

- 本地模型对硬件要求较高,推荐云模型以获得最佳性能。

- 始终核查报告中的来源,AI 可能出现幻觉。

- 项目为非商业用途,遵循 GNU Affero 许可证。

应用场景

- 学术研究

学生或研究人员可使用 CleverBee 快速收集学术论文、网页文章和视频资料,生成引证齐全的文献综述。例如,研究“人工智能伦理”时,CleverBee 可从 PubMed 和学术网站提取相关文献。 - 商业分析

企业用户可分析市场趋势或竞争对手信息。例如,输入“2025年电动车市场预测”,CleverBee 会浏览行业报告和新闻,生成数据驱动的总结。 - 个人学习

普通用户可探索复杂话题,如“区块链技术的应用”。CleverBee 提供多角度资料,包括 YouTube 教程和权威文章,帮助用户全面理解。

QA

- CleverBee 支持哪些模型?

支持 Gemini、Claude 和本地 GGUF 模型(如 Deepseek R1、Llama)。云模型性能更稳定,本地模型适合隐私需求。 - 如何降低运行成本?

使用 NormalizingCache 缓存减少重复查询。选择 Gemini 2.5 Flash 等低成本模型,并通过界面监控令牌使用量。 - 报告是否可靠?

报告基于真实来源并提供引证,但 AI 可能有幻觉。建议用户核查关键信息。 - 是否需要编程经验?

无需编程经验。安装脚本自动化配置,Chainlit 界面操作简单。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...