Kürzlich wurde das KI-unterstützte Programmiertool Cursor hat eine Liste der von Entwicklern bevorzugten KI-Modelle veröffentlicht, und die Daten zeigen, dass Claude 3.7 Das Modell Sonnet belegt den ersten Platz.

Diese offiziellen Daten spiegeln sicherlich die Entscheidung eines großen Teils der Entwickler wider. Bedeutet dies aber, dass Entwickler Claude 3.7 Sonnet einfach zur Standardoption machen sollten? Der tatsächliche Anwendungsfall könnte komplexer sein.

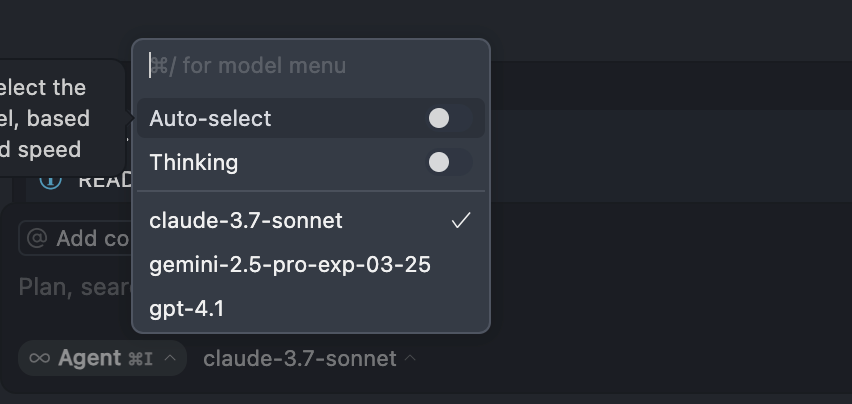

Ein Blick auf die Nutzungsgewohnheiten einiger erfahrener Entwickler zeigt, dass ihre Modellauswahl erheblich von der offiziellen Liste abweicht. Bei Cursor wird Gemini 2.5 Pro beispielsweise 801 TP3T verwendet, auf Claude 3.7 Sonnet entfallen 101 TP3T, und GPT-3.5 und GPT-4.1 5%. In anderen Befehlszeilen- oder Codebearbeitungsumgebungen (wie Roo oder Cline und andere Werkzeuge) kann die Nutzung von Grok 3 sogar 901 TP3T erreichen, wobei die restlichen 101 TP3T dem Zwillinge 2.5 Flash, andere Modelle werden selten aufgerufen.

Hinter diesem Unterschied steht eine Kombination von Überlegungen, die auf den tatsächlichen Aufgabenanforderungen, der Kosteneffizienz und den Modelleigenschaften beruhen. Im Folgenden werden einige Grundsätze und Präferenzen aufgeführt, die bei der Auswahl und Verwendung dieser KI-Codierassistenten zu berücksichtigen sind.

Vermeiden Sie die Verwendung des Modus "Auto".

Der "Auto"-Modus der Modellauswahl in Werkzeugen wie Cursor wird nicht empfohlen, vor allem weil der Entwickler die direkte Kontrolle über die Modellauswahl verliert. Obwohl diese Funktion ein Gleichgewicht zwischen Modellverbrauch, Leistung und Reaktionsfähigkeit herstellen soll, besteht in der Realität oft ein schwieriger Kompromiss zwischen den drei Faktoren - mehr Leistung bedeutet in der Regel einen höheren Verbrauch oder eine langsamere Geschwindigkeit.

Anstatt das System automatisch einem Modell zuordnen zu lassen, das für die jeweilige Aufgabe möglicherweise nicht geeignet ist, und damit Ressourcen (z. B. Punkte oder Anzahl der Anrufe) zu verschwenden, ist es besser, manuell auf das für die spezifischen Anforderungen am besten geeignete Modell umzuschalten. Es wird daher empfohlen, diese automatische Option langfristig zu deaktivieren.

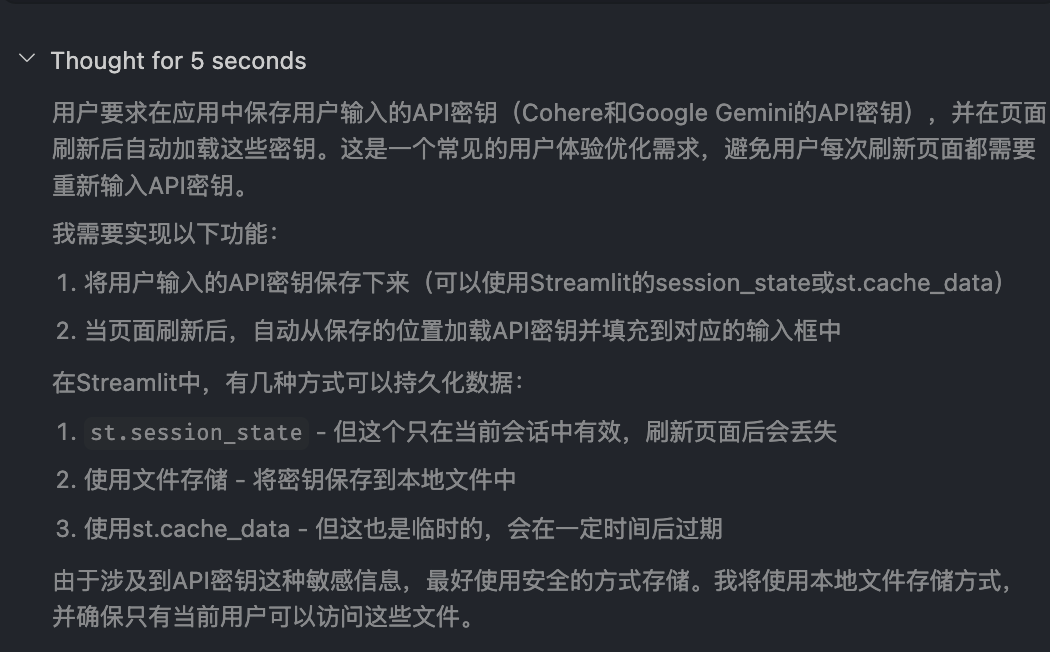

Aktivieren des Modus "Denken" (Gedankenkette)

Die Chain-of-Thought-Technologie ist heute Standard in den besten KI-Modellen. Die Option, den "Denkprozess" des Modells (oft als "Thinking" oder ähnlich bezeichnet) anzuzeigen, ist entscheidend.

Das Einschalten dieses Modus trägt nicht nur dazu bei, die Fähigkeit des Modells zur Bewältigung komplexer Probleme zu verbessern, sondern die angezeigten detaillierten Denkschritte geben den Entwicklern auch einen Einblick in die Arbeitsweise des Modells. Dies hat einen doppelten Nutzen: Erstens kann die Problemlösungsstrategie des Modells durch Beobachtung erlernt und Erfahrung bei der Bewältigung ähnlicher Aufgaben gesammelt werden; zweitens kann die Denkrichtung und Lösung des Modells schnell beurteilt werden, ob sie richtig ist oder nicht, um frühzeitig einzugreifen und Anpassungen vorzunehmen.

Umschalten der Modelle je nach Aufgabentyp

Kein Modell ist perfekt für alle Aufgaben, und ein dynamischer Wechsel der Modelle ist der Schlüssel zur Effizienz.

Planung von Großprojekten und Code-Grooming

Für Makroaufgaben wie die Projektplanung, das Aussortieren komplexer oder veralteter Codebasen und die Erstellung von Regeln sind Gemini 2.5 Pro oder Claude 3.7 Sonnet die erste Wahl. Gemini 2.5 Pro ist aufgrund seines großen Kontextfensters deutlich im Vorteil und eignet sich besonders für die Bearbeitung älterer Projekte mit mehreren Iterationen und großen Codemengen.

Gemini 2.5 Pro unterstützt derzeit Kontextfenster von bis zu 1 Million Token (Token sind eine Maßeinheit für die Menge an Textdaten), wobei eine Erweiterung auf 2 Millionen Token geplant ist. Das bedeutet, dass es das Äquivalent von Tausenden von Seiten an Dokumenten, ganzen Codebasen oder großen multimodalen Dateneingaben, die Text, Bilder, Audio und Video enthalten, auf einmal verarbeiten kann. Das bedeutet, dass es das Äquivalent von Tausenden von Seiten an Dokumenten, ganzen Codebasen oder großen multimodalen Dateneingaben, die Text, Bilder, Audio und Video enthalten, auf einmal verarbeiten kann. Im Gegensatz dazu können andere Mainstream-Modelle wie der gpt-4o-mini von OpenAI und Anthropisch Claude 3.7 Sonnet bietet derzeit ein Kontextfenster von etwa 200.000 Token.

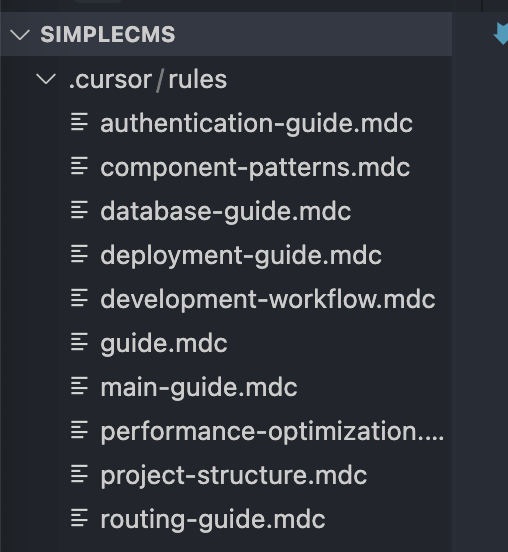

Die Erfahrung hat gezeigt, dass Gemini 2.5 Pro bei der automatischen Generierung von Dokumentendateien (z. B. wird davon ausgegangen, dass es sich bei der im Originalartikel erwähnten mdc-Datei um ein Markdown-Dokument oder ein anderes Format handelt) hervorragend abschneidet, wobei weniger Fälle von offensichtlichen "Halluzinationen" (d. h. der Generierung von ungenauen oder bedeutungslosen Inhalten) auftreten.

Änderung einzelner Dateien und modulare Entwicklung

Für kleinere Aufgaben, wie z. B. die Änderung einer einzelnen Datei oder die modulare Entwicklung, ist der Wechsel zu den Modellen der Claude 3.x Sonnet-Familie oft die bessere Wahl.Claude-Modelle sind bekannt für ihre Reaktionsschnelligkeit, Genauigkeit und Code-Generierung.

Hier kann der Entwickler vor die Wahl gestellt werden: Soll er das neueste Claude 3.7 Sonnet oder das etwas ältere Claude 3.5 Sonnet verwenden?

Einige Entwickler haben die Erfahrung gemacht, dass sich Claude 3.5 Sonnet in manchen Szenarien stabiler und zuverlässiger anfühlt als 3.7 Sonnet. Insbesondere der "Denk"-Modus von 3.7 Sonnet kann manchmal zu einem Zyklus von iterativen Änderungen führen, die bei sehr komplexen Problemen oder langen Gesprächen nicht zum gewünschten Ergebnis führen. Auch wenn 3.5 Sonnet schon eine Weile auf dem Markt ist, ist es immer noch eine sehr robuste und zuverlässige Wahl für viele alltägliche Entwicklungsszenarien.

Stellen Sie sich Gemini 2.5 Pro als einen strategischen Planer vor, der in der Lage ist, umfangreiche Informationen zu verarbeiten, während die Claude 3.x Sonnet-Reihe eher einem Kommando entspricht, das spezifische Codierungsaufgaben ausführt und Probleme schnell löst.

Aufgabenspezifische Optimierung

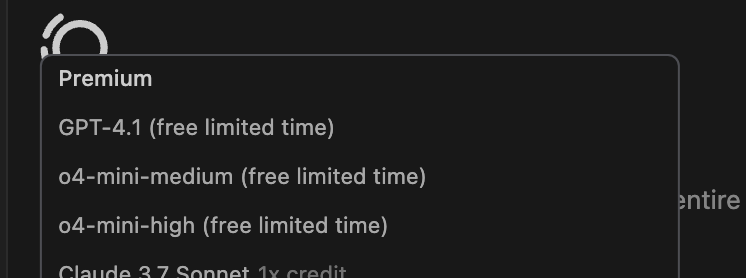

- Einfaches Debugging oder kleine Änderungen: Für einfache Aufgaben wie das Beheben von Tippfehlern und kleinere Codeanpassungen sollten Sie ein kostengünstigeres oder schnelleres Modell wie GPT-4.1 verwenden, das sich derzeit in einer kostenlosen oder kostengünstigen Testphase befindet. Es ist sehr kostengünstig für diese Art von "Bastelarbeiten" und vermeidet die Verschwendung von Ressourcen in Form von "ein Huhn mit einem Volltreffer erlegen".

- Multimodale Aufgaben: Die Modelle der Claude 3.x Sonnet-Familie erbringen in der Regel die besten Leistungen, wenn es um die Arbeit mit Bildern geht, z. B. bei der Generierung von Code für eine Webseite auf der Grundlage einer Entwurfszeichnung, und die Claude-Modelle haben eine anerkannte Stärke beim Verstehen visueller Elemente und bei der Generierung von Code für ästhetisch ansprechende Schnittstellen.

Auswahl des werkzeugspezifischen Modells (Roo, Cline, etc.)

Bei einigen KI-Befehlszeilen-Tools oder IDE-Plug-ins, die nicht zu Cursor gehören (z. B. Roo und Cline, wie im ursprünglichen Artikel erwähnt), kann die Modellauswahl stark von Kosten und Benutzerfreundlichkeit beeinflusst werden.

In diesen Umgebungen ist der Einsatz von Grok 3-Modell könnte eine pragmatische Option werden, vor allem wegen der relativ großzügigen Nutzungspauschale. x AI bietet eine beträchtliche kostenlose monatliche Pauschale für die Grok 3-API (angeblich fast 150 US-Dollar), was für Entwickler, die viele Anrufe tätigen müssen, äußerst attraktiv ist. Für weitere Informationen siehe Grok 3 Schockierende Veröffentlichung: Reasoning Intelligence Body fliegt in die Luft! API debütiert "$5 Charge for $150" im Gesang antworten OpenAI Codex CLI: Ein Terminal-Kommandozeilen-Assistent für KI-Programmierung von OpenAI veröffentlicht und andere Diskussionen in der Gemeinschaft. Im Gegensatz dazu kann die Nutzung anderer Spitzenmodelle schnell hohe Kosten verursachen. Die Gemini-Modellfamilie bietet zwar eine kostenlose Stufe, ist aber häufig mit einer Ratenbegrenzung verbunden und neigt dazu, Fehler auszulösen, wenn zu viele aufeinanderfolgende oder gleichzeitige Anfragen vorliegen.

Darüber hinaus ist für bestimmte sich wiederholende oder Batch-Codierungsaufgaben (das Akronym MCP kann sich auf Szenarien wie "Mass Code Processing" oder ähnliches beziehen) eine Version von Gemini Flash, die, wie der Name schon sagt, die Reaktionsfähigkeit optimiert und gleichzeitig ein ausreichendes kontextuelles Verständnis beibehält, eine erwägenswerte Option. Gemini Flash bietet ein gutes Gleichgewicht zwischen Geschwindigkeit und Genauigkeit, wenn es um diese Art von Batch-Aufgaben geht, die eine schnelle und genaue Reaktion erfordern.

Letztlich geht es bei einer effektiven Strategie zur Nutzung von KI-Modellen nicht um die Wahl eines einzigen Modells, sondern um einen dynamischen, flexiblen manuellen Wechsel zwischen verschiedenen Szenarien und Tools auf der Grundlage von Aufgabenanforderungen, Kostenbudgets und Modelleigenschaften. So wäre es beispielsweise ratsam, Hochleistungsmodelle wie Claude 3.7 Sonnet oder Gemini 2.5 Pro für komplexe Aufgaben innerhalb des verfügbaren Kontingents zu bevorzugen und auf kostengünstigere Optionen wie GPT-4.1 oder Grok 3 umzuschalten, wenn das Kontingent fast erschöpft ist oder für einfache Aufgaben.