Allgemeine Einführung

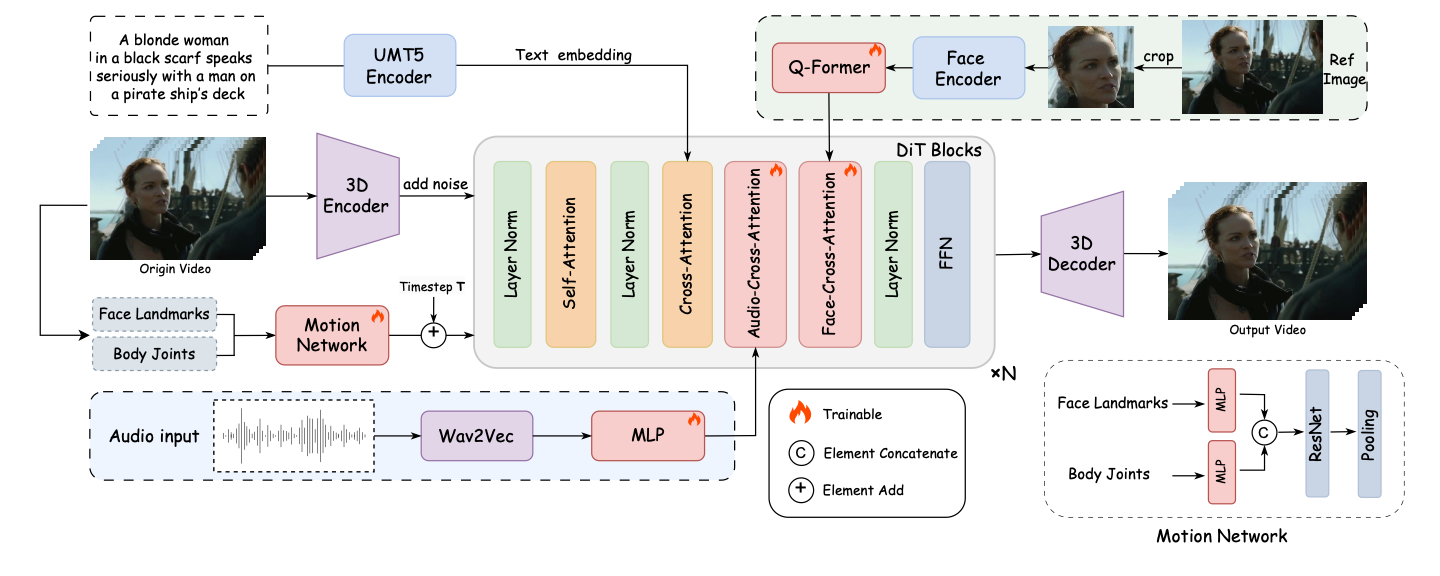

FantasyTalking ist ein Open-Source-Projekt, das vom Fantasy-AMAP-Team entwickelt wurde und sich auf die audiogesteuerte Erzeugung von realistisch wirkenden sprechenden Porträtvideos konzentriert. Das Projekt basiert auf dem fortschrittlichen Videodiffusionsmodell Wan2.1 , kombiniert mit dem Audio-Encoder Wav2Vec und proprietären Modellgewichten, wobei Techniken der künstlichen Intelligenz eingesetzt werden, um eine äußerst realistische Lippensynchronisation und Mimik zu erreichen. Die Software unterstützt mehrere Arten der Porträtgenerierung, einschließlich realer Personen und Cartoon-Bilder, für eine breite Palette von Blickwinkeln wie Panorama, Büste oder Nahaufnahme. Benutzer können schnell qualitativ hochwertige sprechende Videos erzeugen, indem sie Bilder und Audio über einfache Befehlszeilenoperationen eingeben.

Funktionsliste

- Erzeugen Sie realistisch sprechende Porträtvideos mit hochsynchronen Lippenbewegungen zum Ton.

- Für die Erstellung werden mehrere Blickwinkel unterstützt, darunter Nahaufnahmen, Halbkörper- und Ganzkörperporträts.

- Kompatibel mit realen und Cartoon-Stil Porträts, um verschiedene Bedürfnisse zu erfüllen.

- Bieten Sie eine Funktion zur Steuerung von Stichwortwörtern, um den Ausdruck und die Körperbewegung der Figur anzupassen.

- Unterstützt eine hohe Auflösung von bis zu 720P.

- Integriertes gesichtsfokussiertes Cross-Attention-Modul zur Gewährleistung der Konsistenz von Gesichtsmerkmalen.

- Enthält ein Modul zur Modulation der Trainingsintensität, um Ausdruck und Bewegungsumfang zu steuern.

- Open-Source-Modelle und -Code zur Unterstützung der Entwicklung und Optimierung durch die Sekundärgemeinschaft.

Hilfe verwenden

Einbauverfahren

Um FantasyTalking zu verwenden, müssen Sie zunächst die notwendigen Abhängigkeiten und Modelle installieren. Im Folgenden finden Sie die detaillierten Installationsschritte:

- Projektcode klonen

Führen Sie den folgenden Befehl im Terminal aus, um das Projekt lokal zu klonen:git clone https://github.com/Fantasy-AMAP/fantasy-talking.git cd fantasy-talking

- Installation von Abhängigkeiten

Das Projekt ist abhängig von der Python-Umgebung und PyTorch (Version >= 2.0.0). Führen Sie den folgenden Befehl aus, um die erforderlichen Bibliotheken zu installieren:pip install -r requirements.txtOptionale Montage

flash_attnum die Aufmerksamkeitsberechnung zu beschleunigen:pip install flash_attn - Modelle herunterladen

FantasyTalking benötigt drei Modelle: Wan2.1-I2V-14B-720P (Basismodell), Wav2Vec (Audio-Encoder) und FantasyTalking-Modellgewichte. Sie können über Hugging Face oder ModelScope heruntergeladen werden:- Verwenden Sie die Umarmung Gesicht CLI:

pip install "huggingface_hub[cli]" huggingface-cli download Wan-AI/Wan2.1-I2V-14B-720P --local-dir ./models/Wan2.1-I2V-14B-720P huggingface-cli download facebook/wav2vec2-base-960h --local-dir ./models/wav2vec2-base-960h huggingface-cli download acvlab/FantasyTalking fantasytalking_model.ckpt --local-dir ./models - Oder verwenden Sie die ModelScope CLI:

pip install modelscope modelscope download Wan-AI/Wan2.1-I2V-14B-720P --local_dir ./models/Wan2.1-I2V-14B-720P modelscope download AI-ModelScope/wav2vec2-base-960h --local_dir ./models/wav2vec2-base-960h modelscope download amap_cvlab/FantasyTalking fantasytalking_model.ckpt --local_dir ./models

- Verwenden Sie die Umarmung Gesicht CLI:

- Überprüfung der Umgebung

Stellen Sie sicher, dass die GPU verfügbar ist (RTX 3090 oder höher empfohlen, VRAM mindestens 24 GB). Wenn Sie Speicherprobleme haben, versuchen Sie, die Auflösung zu verringern oder die VRAM-Optimierung zu aktivieren.

Verwendung

Sobald die Installation abgeschlossen ist, können die Benutzer das Argumentationsskript ausführen, um Videos von der Befehlszeile aus zu erzeugen. Die grundlegenden Befehle lauten wie folgt:

python infer.py --image_path ./assets/images/woman.png --audio_path ./assets/audios/woman.wav

--image_path: Geben Sie den Pfad zum Porträtbild ein (PNG/JPG-Format unterstützt).--audio_path: Pfad der Eingangsaudiodatei (WAV-Format wird unterstützt).--prompt: Optionale Aufforderungswörter zur Steuerung des Rollenverhaltens, zum Beispiel:--prompt "The person is speaking enthusiastically, with their hands continuously waving."--audio_cfg_scaleim Gesang antworten--prompt_cfg_scaleAudio CFG: Steuert den Grad der Beeinflussung von Audio- und Stichwortwörtern, mit einem empfohlenen Bereich von 3-7. Eine Erhöhung des Audio CFG verbessert die Lippensynchronisation.

Featured Function Bedienung

- Lippensynchronisation

Die Kernfunktion von FantasyTalking besteht darin, präzise Lippenbewegungen auf der Grundlage von Audiodaten zu erzeugen. Der Benutzer muss eine klare Audiodatei vorbereiten (z. B. im WAV-Format, optimal ist eine Abtastrate von 16kHz). Sobald das Inferenzskript ausgeführt wird, analysiert das Modell automatisch den Ton und erzeugt passende Lippenbewegungen. Achten Sie darauf, dass die Audiodatei frei von starkem Rauschen ist, um optimale Ergebnisse zu erzielen. - Stichwort Wortkontrolle

passieren (eine Rechnung oder Inspektion etc.)--promptkann der Benutzer die Ausdrücke und Aktionen der Figur festlegen. Zum Beispiel, geben Sie ein--prompt "The person is speaking calmly with slight head movements."Es können Videos von ruhigen Gesprächen erstellt werden. Die Stichworte müssen prägnant und klar sein, vage Beschreibungen sind zu vermeiden. - Multi-Style-Unterstützung

Das Projekt unterstützt die Erstellung von Porträts im Real- und Cartoon-Stil. Die Benutzer können Eingabebilder in verschiedenen Stilen bereitstellen, und das Modell passt den Ausgabestil entsprechend den Bildmerkmalen an. Der Cartoon-Stil eignet sich für Animationsszenen, der reale Stil für Anwendungen wie virtuelle Anker. - Modulation der Belastungsintensität

Das Modul Motion Intensity Modulation von FantasyTalking ermöglicht es dem Benutzer, die Amplitude von Ausdrücken und Bewegungen zu steuern. Wenn Sie zum Beispiel eine höhere--audio_weightDer Parameter verstärkt die Bewegungen der Gliedmaßen und eignet sich für dynamische Szenen. Die Standardeinstellungen sind optimiert und es wird empfohlen, bei der ersten Verwendung die Standardwerte beizubehalten.

caveat

- Hardware-VoraussetzungBei der RTX 5090 mit 32 GB VRAM kann es immer noch zu Problemen mit geringem Arbeitsspeicher kommen, und es wird empfohlen, die für die Erzeugung hochauflösender Videos erforderliche Speichermenge zu reduzieren.

--image_sizevielleicht--max_num_frames. - Modell DownloadDie Modelldateien sind sehr umfangreich (einige zehn Gigabyte). Stellen Sie daher sicher, dass Sie über ein stabiles Netzwerk und genügend Speicherplatz verfügen.

- Stichwort WortoptimierungDas Stichwort hat einen großen Einfluss auf den Output und es werden mehrere Experimente empfohlen, um die beste Beschreibung zu finden.

Anwendungsszenario

- Erstellung virtueller Ankerinhalte

Mit FantasyTalking können Benutzer realistische Sprechvideos für virtuelle Moderatoren erstellen. Geben Sie das Porträtbild des Moderators und den Ton des Sprechers ein, um lippensynchrone Videos für Live-Streaming, Kurzvideos oder die Produktion von Bildungsinhalten zu erstellen. - Animation Zeichensynchronisation

Animatoren können Voiceover-Videos für Zeichentrickfiguren erstellen. Wenn das Modell das Zeichentrickbild und den Ton bereitstellt, kann es passende Lippenbewegungen und Ausdrücke erzeugen, was den Produktionsprozess der Animation vereinfacht. - Produktion von Lehrvideos

Lehrkräfte oder Schulungseinrichtungen können virtuelle Lehrervideos erstellen. Geben Sie ein Porträt des Kursleiters und das Kurstonmaterial ein, um schnell Lehrvideos zu erstellen, die die Attraktivität des Inhalts erhöhen. - Unterhaltung und Faszination schaffen

Benutzer können lustige sprechende Porträts für Fanfiction oder Unterhaltungsvideos erstellen. Durch Anpassen der Stichwörter können Videos mit übertriebenen Ausdrücken oder Aktionen erstellt werden, die sich für das Teilen in sozialen Medien eignen.

QA

- Welche Eingabeformate werden von FantasyTalking unterstützt?

Bilder werden in den Formaten PNG und JPG unterstützt und Audio wird im WAV-Format mit einer empfohlenen Abtastrate von 16 kHz für eine optimale Lippensynchronisation unterstützt. - Wie kann man das Problem des unzureichenden Videospeichers lösen?

Wenn die GPU nicht über genügend Speicher verfügt (z. B. 32 GB VRAM bei der RTX 5090), senken Sie den--image_size(z.B. 512x512) oder reduziert--max_num_frames(z. B. 30 fps). Es ist auch möglich, die VRAM-Optimierungsoption zu aktivieren oder einen besser konfigurierbaren Grafikprozessor zu verwenden. - Wie kann die Qualität des erzeugten Videos verbessert werden?

Verwenden Sie ein hochauflösendes Eingangsbild (mindestens 512x512), um sicherzustellen, dass der Ton klar und rauschfrei ist. Einstellung--audio_cfg_scale(z. B. 5-7) verbessert die Lippensynchronisation, und die Optimierung der Stichwortwörter verbessert die Natürlichkeit der Ausdrücke. - Unterstützt es die Generierung in Echtzeit?

Die aktuelle Version unterstützt nur Offline-Inferenz, die Echtzeitgenerierung erfordert weitere Modelloptimierung und Hardwareunterstützung.