JetBrains, ein Anbieter von Software-Entwicklungstools, hat vor kurzem bekannt gegeben, dass es die Basisversion von Mellum, seinem speziell für die Code-Vervollständigung entwickelten Sprachmodell, als Open Source zur Verfügung stellt und auf der Hugging Face-Plattform zugänglich macht. Dieser Schritt soll die Transparenz und Zusammenarbeit im Bereich der KI in der Softwareentwicklung fördern.

Anstatt nach Allgegenwart zu streben, konzentriert sich Mellums Designphilosophie auf eine Kernaufgabe: die Vervollständigung von Code. JetBrains nennt diese Art von Modell Dedizierte Modelle (spezialisiertes Modell) und betont, dass sein Designziel darin besteht, tiefe Fähigkeiten in spezifischen Bereichen zu haben, anstatt blindlings eine breite Allgemeinheit zu verfolgen. Das Modell unterstützt die Codevervollständigung in einer Vielzahl von Programmiersprachen, darunter Java, Kotlin, Python, Go, PHP, C, C++, C#, JavaScript, TypeScript, CSS, HTML, Rust und Ruby.

offene Quelle Mellum-4b-base ist das erste Modell der Mellum-Familie. JetBrains plant, diese Familie in Zukunft um weitere spezielle Modelle für verschiedene Codierungsaufgaben, wie z. B. die Disparitätsvorhersage, zu erweitern.

Die Überlegungen hinter Open Source

Die Entscheidung, Mellum als Open Source zu veröffentlichen, wurde nicht leichtfertig getroffen. Mellum ist keine fein abgestimmte Version eines bestehenden Open-Source-Modells, sondern wurde von Grund auf von JetBrains entwickelt, um Cloud-basierte Code-Completion-Funktionen für seine IDE-Produkte bereitzustellen, und wurde im vergangenen Jahr der Öffentlichkeit zugänglich gemacht.

Laut JetBrains basiert Open Source Mellum auf dem Glauben an die Kraft von Transparenz, Zusammenarbeit und gemeinsamem Fortschritt. Von Linux und Git bis hin zu Node.js und Docker - das Open-Source-Paradigma war eine wichtige Triebkraft für große Technologiesprünge. Wenn man bedenkt, dass es bereits Open-Source-LLMs gibt, die einige Branchenführer übertreffen, ist es nicht unwahrscheinlich, dass die allgemeine Entwicklung der KI eine ähnliche Entwicklung nehmen wird.

Der Schritt bedeutet auch, dass JetBrains eine seiner Kerntechnologien für die Gemeinschaft öffnet. Mit der Freigabe von Mellum auf Hugging Face bietet das Unternehmen Forschern, Pädagogen und leitenden technischen Teams die Möglichkeit, Einblicke in das Innenleben eines speziellen Modells zu erhalten. Dies ist mehr als nur die Bereitstellung eines Tools, es ist eine Investition in offene Forschung und Zusammenarbeit.

Was ist ein spezialisiertes Modell?

Im Bereich des maschinellen Lernens ist die Spezialisierung kein neues Konzept, sondern ein zentraler Ansatz, der die Modellentwicklung seit Jahrzehnten leitet - die Entwicklung von Modellen zur effizienten und effektiven Lösung bestimmter Aufgaben. In den letzten Jahren hat sich die Diskussion in der KI jedoch allmählich dahingehend verschoben, dass versucht wird, alle Aufgaben mit verallgemeinerten Großmodellen abzudecken, was jedoch häufig mit erheblichen Kosten für die Berechnung und die Umwelt verbunden ist.

Dedizierte ModelleStattdessen kehrt sie zum ursprünglichen Zweck der Spezialisierung zurück: Modelle zu erstellen, die in einem bestimmten Bereich gut funktionieren.

Dies kann mit einer "T-Fähigkeit" verglichen werden: Eine Person verfügt über ein breites Wissen über viele Themen (Breite des Wissens, der horizontale Balken des T), aber über ein tiefes Fachwissen in einem bestimmten Bereich (Tiefe des Wissens, der vertikale Balken des T). Spezialisierte Modelle folgen der gleichen Philosophie; sie sind nicht dafür gemacht, alles zu beherrschen, sondern sich zu spezialisieren und sich in einer einzigen Aufgabe auszuzeichnen, um in einem bestimmten Bereich wirklich wertvoll zu sein.

Mellum ist die Verkörperung dieser Philosophie. Es ist ein relativ kleines, effizientes Modell, das für codebezogene Aufgaben entwickelt wurde, angefangen bei der Code-Vervollständigung.

Der Grund für diesen Ansatz ist, dass nicht alle Probleme generische Lösungen erfordern und nicht alle Teams über die Ressourcen oder die Notwendigkeit verfügen, große, allumfassende Modelle zu betreiben. Spezialisierte Modelle (wie Mellum) bieten deutliche Vorteile:

- Präzision für bereichsspezifische Aufgaben.

- Kostengünstig in Bezug auf Betrieb und Einsatz.

- Der Berechnungsaufwand und der CO2-Fußabdruck sind gering.

- Bessere Zugänglichkeit für Forscher, Lehrkräfte und kleine Teams.

Dabei handelt es sich nicht um einen technologischen Rückschritt, sondern um die Anwendung bewährter Spezialisierungsprinzipien auf moderne KI-Probleme. JetBrains sieht dies als einen klügeren Weg nach vorne.

Wie sieht die Leistung von Mellum aus?

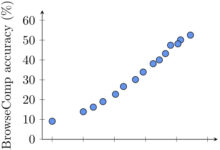

Mellum ist ein mehrsprachiges parametrisches 4B-Modell (Mellum-4b-base), die speziell für die Code-Vervollständigung optimiert wurde. JetBrains hat es in mehreren Sprachen auf mehreren Datensätzen getestet und eine umfangreiche manuelle Bewertung in seiner IDE durchgeführt.

Nachstehend finden Sie Daten, die die Leistung von Mellum mit einer Reihe von Modellen mit einer größeren Anzahl von Parametern vergleichen (alle Einzelheiten, Ergebnisse und Vergleiche finden Sie in der Modellkarte von Hugging Face):

| Modellierung | HumanEval Infilling (einzeilig) | HumanEval Infilling (mehrere Zeilen) | RepoBench 1.1 (2K Kontext, py) | SAFIM (Durchschnitt) |

|---|---|---|---|---|

| Mellum-4B-Basis | 66.2 | 38.5 | 28.2 | 38.1 |

| InCoder-6B | 69.0 | 38.6 | - | 33.8 |

| CodeLlama-7B-Basis | 83.0 | 50.8 | 34.1 | 45.0 |

| CodeLlama-13B-Basis | 85.6 | 56.1 | 36.2 | 52.8 |

| DeepSeek-Coder-6.7B | 80.7 | - | - | 63.4 |

Hinweis: HumanEval Infilling testet die Fähigkeiten zum Ausfüllen von Code, RepoBench bewertet die Leistung im Kontext einer realen Codebasis, und SAFIM ist ein weiterer Benchmark-Test zur Codevervollständigung. Zu den Vergleichsmodellen gehören die CodeLlama-Familie von Meta und das Coder-Modell von DeepSeek.

Die Daten zeigen, dass Mellum trotz seiner geringen Teilnehmerzahl bei bestimmten Benchmarks wettbewerbsfähig ist (insbesondere wenn man seine Größe berücksichtigt). Dies ist ein weiterer Beleg dafür, dass spezielle Modelle bei bestimmten Aufgaben eine effiziente Leistung erzielen können. Die Anzahl der Parameter ist nicht das einzige Maß für die Leistungsfähigkeit eines Modells, sondern auch die aufgabenspezifische Optimierung ist entscheidend.

Für wen ist Mellum?

Es ist wichtig, sich darüber im Klaren zu sein, dass die aktuelle Version von Mellum, die auf Hugging Face veröffentlicht wurde, nicht in erster Linie für den durchschnittlichen Endentwickler gedacht ist, der das Modell nicht direkt abstimmen oder einsetzen wird.

Das Modell steht den folgenden Gruppen offen:

- KI/ML-Forscher: Insbesondere Wissenschaftler, die sich mit der Rolle der KI in der Softwareentwicklung befassen, Benchmarking durchführen oder die Interpretierbarkeit von Modellen untersuchen.

- KI/ML-Ingenieure und Pädagogen: Es kann als Grundlage für das Erlernen des Aufbaus, der Feinabstimmung und der Anpassung von domänenspezifischen Sprachmodellen oder zur Unterstützung von Bildungsprojekten verwendet werden, die sich auf LLM-Architektur und Spezialisierung konzentrieren.

Mellum jetzt erleben

Das Mellum-Basismodell ist jetzt erhältlich in Gesicht umarmen Live gehen. JetBrains betont, dass dies erst der Anfang ist und dass ihr Ziel nicht darin besteht, Allgemeinheit anzustreben, sondern fokussierte, effiziente Werkzeuge zu bauen. Diejenigen, die auf der Grundlage von Mellum erforschen, experimentieren oder bauen möchten, können jetzt auf das Modell zugreifen und es ausprobieren.