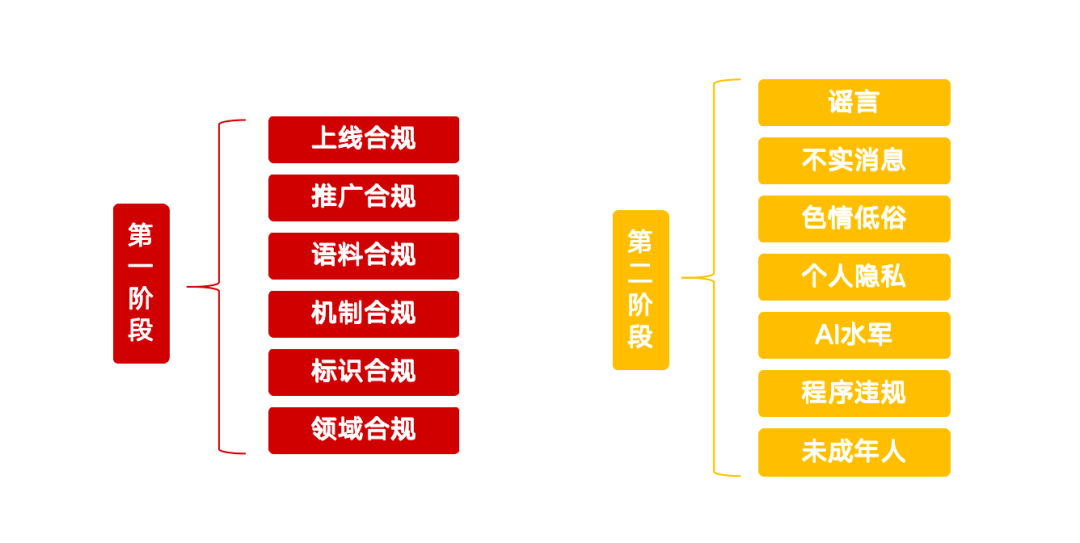

Kürzlich hat das Zentralamt für Internet-Informationstechnologie eine Sonderaktion mit dem Titel "Clear - Rectify the Abuse of AI Technology" (Klar - Bereinigung des Missbrauchs der KI-Technologie) ins Leben gerufen, die eine klare rote Linie für die Bewältigung einer Reihe von Problemen zieht, die bei der aktuellen Entwicklung der künstlichen Intelligenz aufgetreten sind. Diese Initiative zielt darauf ab, die gesunde Entwicklung der KI-Technologie zu lenken und potenzielle Risiken zu verhindern. Die Sonderaktion konzentriert sich auf 13 Hauptrichtungen und ist in zwei Phasen mit detaillierten Anforderungen an KI-Produkte, -Dienste, -Inhalte und -Verhaltensnormen unterteilt.

Phase I: Quellenmanagement und Infrastruktur

Die erste Phase der Aktion konzentriert sich auf das Quellenmanagement der KI-Technologie, mit dem Ziel, vorschriftswidrige KI-Anwendungen zu bereinigen, das Management der Inhaltskennzeichnung zu stärken und die Fähigkeit der Plattform zu verbessern, Fälschungen zu erkennen und zu identifizieren.

Nicht konforme KI-Produkte müssen die Online-Konformität erfüllen

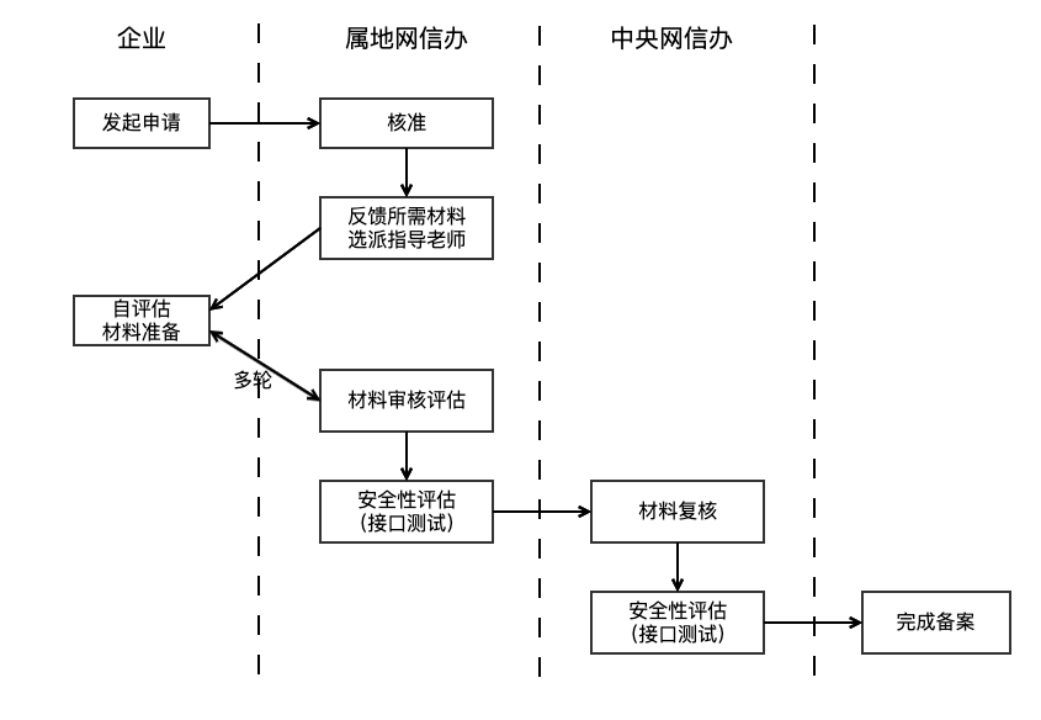

Die Regulierungsbehörde wies darauf hin, dass Anwendungen, die generative KI-Technologie nutzen, um Dienstleistungen für die Öffentlichkeit zu erbringen, den Prozess der Einreichung oder Registrierung großer Modelle durchlaufen müssen. Diese Anforderung stützt sich auf Artikel 17 der Interim Measures for the Administration of Generative Artificial Intelligence Services (im Folgenden als Interim Measures bezeichnet), der klarstellt, dass KI-Produkte vor ihrer offiziellen Markteinführung eine Sicherheitsbewertung durchlaufen müssen. Die Einreichung der Unterlagen wird in der Regel drei bis sechs Monate in Anspruch nehmen. Darüber hinaus verstößt es gegen das Gesetz, illegale und unethische Funktionen wie das "Ausziehen mit einem Klick" anzubieten oder biometrische Merkmale anderer Personen (z. B. Stimmen und Gesichter) ohne Genehmigung zu klonen oder zu bearbeiten.

Die Identifizierung und Regulierung nicht registrierter KI-Dienste ist zu einer Herausforderung geworden. Die Regulierungsbehörden können technische Mittel wie Web-Crawler einsetzen, um verschiedene Plattformen zu überwachen, indem sie feststellen, ob die Dienste Big-Model-API-Schnittstellen aufrufen (z. B. Dialoggenerierung, Bildsynthese) und welche technischen Merkmale sie aufweisen. Was die Einhaltung des Funktionsdesigns betrifft, so stützt sich die Regulierung informeller Kanaldienste neben der internen rechtlichen Bewertung von Unternehmen und App-Shop-Audits derzeit eher auf die Meldung von Nutzerbeschwerden. Die Anbieter von Diensten sollten selbst prüfen, ob KI-Produkte eine doppelte Einreichung (Einreichung des großen Modells und des Algorithmus) durchlaufen haben, und sicherstellen, dass das funktionale Design den Spezifikationen entspricht.

Förderung der Konformität: Gegen illegale KI-Produkt-Tutorials und -Ware wird vorgegangen

Die Sonderaktion konzentriert sich auch auf die Förderung von KI-Produkten. Tutorials, in denen die Verwendung von nicht konformen KI-Produkten zur Erstellung von gesichts- und stimmverändernden Videos gelehrt wird, der Verkauf von nicht konformen Produkten wie "Stimmsynthesizern" und "Gesichtsveränderungswerkzeugen" sowie die Vermarktung und Werbung für nicht konforme KI-Produkte sind in die Abhilfemaßnahmen einbezogen. Es liegt in der Verantwortung der Anbieter, die Konformität von KI-Produkten zu überprüfen, bevor sie diese bewerben. Plattformen müssen die Prüfung von Inhalten verstärken, nicht nur um sicherzustellen, dass die Inhalte selbst legal sind, sondern auch um die Konformität der in den Inhalten beworbenen KI-Produkte zu erkennen und zu prüfen, z. B. durch das anfängliche Screening von semantischen Modellen, ergänzt durch manuelle Eingriffe.

Corpus-Compliance: Schulungsdatenquellen und -verwaltung im Fokus

Die Konformität von Trainingsdaten ist die Grundlage für die Sicherheit von KI-Modellen. In Artikel 7 der vorläufigen Maßnahmen wird betont, dass Diensteanbieter Daten und zugrunde liegende Modelle aus legitimen Quellen verwenden sollten. Die Grundanforderungen für die Sicherheit generativer KI-Dienste (nachstehend "Grundanforderungen" genannt) werden weiter verfeinert, indem festgelegt wird, dass die Quelle nicht genutzt werden sollte, wenn der Korpus mehr als 51 TP3T an illegalen und unerwünschten Informationen enthält. Gleichzeitig werden die Vielfalt der Datenquellen, die zu befolgenden Open-Source-Protokolle, die Aufzeichnungen über selbst gesammelte Daten und die rechtlichen Verfahren für die kommerzielle Datenbeschaffung klar definiert.

Aufgrund des Datenschutzes und der technischen Vertraulichkeit ist die Regulierung des Trainingskorpus recht schwierig und erfolgt in der Regel in Form von Befragungen und materiellen Nachweisen. Unternehmen stehen auch vor großen Herausforderungen bei der Verwaltung großer Mengen von Trainingsdaten mit komplexen Quellen und unterschiedlicher Qualität. In den Grundanforderungen wird empfohlen, dass Unternehmen das Filtern von Schlüsselwörtern, das Screening von Klassifikationsmodellen und manuelle Stichproben kombinieren, um illegale und unerwünschte Informationen im Korpus zu bereinigen.

Einhaltung des Mechanismus: Verbesserte Sicherheitsmanagementmaßnahmen

Unternehmen müssen Sicherheitsmechanismen wie Inhaltskontrolle und Absichtserkennung einrichten, die der Größe ihres Unternehmens angemessen sind, sowie ein wirksames Verwaltungsverfahren für verletzende Konten und ein regelmäßiges System zur Selbstbewertung der Sicherheit. Bei Diensten wie KI-Autoreplys, auf die über API-Schnittstellen zugegriffen wird, müssen soziale Plattformen achtsam und streng sein. Kapitel 7 der Grundanforderungen verlangt von den Dienstanbietern, die Benutzereingaben zu überwachen und Maßnahmen zu ergreifen, wie z. B. die Einschränkung von Diensten für Benutzer, die wiederholt illegale Informationen eingeben. Darüber hinaus sollten die Unternehmen über Aufsichtspersonal verfügen, das dem Umfang ihrer Dienste entspricht und für die Überwachung von Richtlinien und die Analyse von Beschwerden zuständig ist, um die Qualität und Sicherheit der Inhalte zu verbessern. Ein solider Risikokontrollmechanismus ist eine Voraussetzung für die Einführung von KI-Produkten.

Einhaltung der Kennzeichnungspflicht: Umsetzung der Kennzeichnungsanforderungen für KI-generierte Inhalte

Um die Transparenz zu erhöhen, sehen die Maßnahmen zur Kennzeichnung von durch künstliche Intelligenz erzeugten synthetischen Inhalten (im Folgenden "Kennzeichnungsmaßnahmen") vor, dass die Diensteanbieter explizite oder implizite Kennzeichnungen zu tief synthetisierten Inhalten hinzufügen und sicherstellen müssen, dass die expliziten Kennzeichnungen in der Datei enthalten sind und implizite Kennzeichnungen zu den Metadaten hinzugefügt werden, wenn der Nutzer die Datei herunterlädt oder kopiert. Der Ansatz wird von der nationalen Norm "Network Security Technology Artificial Intelligence Generated Synthetic Content Identification Method" begleitet, die ab dem 1. September 2025 in Kraft treten wird. Unternehmen sind verpflichtet, auf dieser Grundlage Selbstprüfungen durchzuführen und technische Mittel einzusetzen, um KI-generierte Inhalte auf ihren Plattformen zu erkennen und bei verdächtigen Inhalten Warnmeldungen zu versenden. Die Regulierungsbehörden können auch die Aufklärung der Nutzer verbessern, um die öffentliche Anerkennung von KI-generierten Inhalten zu verbessern.

Domain Compliance: Fokus auf Sicherheitsrisiken in Schlüsselindustrien

KI-Produkte, die für die Bereitstellung von Q&A-Diensten in Schlüsselbereichen wie Gesundheitswesen, Finanzen und Minderjährige angemeldet wurden, müssen branchenspezifische Sicherheitsaudits und Kontrollmaßnahmen einrichten. Verhinderung des Phänomens der "KI-Verschreibung", der Veranlassung von Investitionen oder der Verwendung von "KI-Illusionen" zur Irreführung der Nutzer. Die Compliance-Governance in diesen spezifischen Bereichen ist komplex und segmentiert und erfordert Fachwissen und einen speziellen Compliance-Korpus. Die Regulierungsbehörden der Branche und die führenden Unternehmen werden eine Schlüsselrolle bei der Festlegung von Standards und der Gewährleistung von Sicherheitsmaßnahmen spielen. Zu den allgemeinen Lösungen gehören die Erkennung von Phantomen, die manuelle Genehmigung wichtiger Vorgänge usw., um dem Risiko eines KI-Kontrollverlusts vorzubeugen.

Phase II: Hartes Durchgreifen gegen die Nutzung von KI für illegale und unerlaubte Aktivitäten

Die zweite Phase der Sonderaktion konzentriert sich auf die Nutzung der KI-Technologie zur Erstellung und Verbreitung von Gerüchten, unzutreffenden Informationen, pornografischen und vulgären Inhalten sowie zur Nachahmung anderer Personen und zur Beteiligung an Aktivitäten der Cyber-Squads.

Bekämpfung des Einsatzes von KI zur Schaffung und Veröffentlichung von Gerüchten

Zu den Abhilfemaßnahmen gehören das Fabrizieren von Gerüchten über aktuelle Angelegenheiten und den Lebensunterhalt der Menschen aus dem Nichts, die böswillige Interpretation von politischen Maßnahmen, das Fabrizieren von Details auf der Grundlage von Notfällen, das Ausgeben offizieller Informationen sowie die böswillige Lenkung durch Ausnutzung der kognitiven Verzerrungen der KI. Chinas gemeinsame Plattform zur Verbreitung von Gerüchten im Internet ist seit langem in Betrieb, aber im Zeitalter der KI stellen die geringeren Kosten der Gerüchteproduktion und die höhere Zuverlässigkeit neue Herausforderungen für die Politik dar. Die Regulierung stützt sich hauptsächlich auf die Überwachung der öffentlichen Meinung und die Berichterstattung der Nutzer, und die Strafen für KI-Gerüchte in Schlüsselbereichen könnten erhöht werden. Dienstanbieter müssen ihre Fähigkeit zur Erkennung von KI-generierten Gerüchten verbessern, z. B. durch den Einsatz von KI-Tools zur Kalibrierung der Genauigkeit von Inhalten, die Überwachung von abnormalem Kontoverhalten und die manuelle Stichprobenkontrolle von Hotspot-Inhalten.

Beseitigung der Nutzung von KI zur Erstellung und Veröffentlichung ungenauer Informationen

Dazu gehören das Zusammensetzen und Bearbeiten von Grafiken und Videos, die in keinem Zusammenhang stehen, um gemischte Informationen zu generieren, das Verwischen und Verändern von Fakten, das Wiederaufwärmen alter Nachrichten, das Veröffentlichen übertriebener oder pseudowissenschaftlicher Inhalte im Zusammenhang mit Berufsfeldern und das Verbreiten von Aberglauben mit Hilfe von KI-Wahrsagerei und -Wahrsagerei und so weiter. Im Vergleich zu Gerüchten sind ungenaue Informationen zwar weniger subjektiv und böswillig, aber ihr verborgener Charakter und ihre potenziellen Auswirkungen sind nicht zu übersehen. Die Governance stützt sich hauptsächlich auf die Inhaltsplattformen, um den ökologischen Aufbau zu stärken, minderwertige Inhalte mit technischen Mitteln zu identifizieren und Maßnahmen zu ergreifen, um die Verbreitung relevanter Inhalte und Urheber einzuschränken oder Strafen zu verhängen.

Behebung der Nutzung von KI zur Herstellung und Verbreitung pornografischer und vulgärer Inhalte

Der Einsatz von KI zur Erstellung pornografischer oder unanständiger Bilder und Videos, wie z. B. KI-"Ausziehen mit einem Klick" und KI-Zeichnen, sowie die Produktion von Softpornografie, pornografischen Bildern der zweiten Generation, blutiger Gewalt, grotesken und grotesken Bildern und "kleinem gelben Text", werden allesamt streng geahndet. Die KI-Technologie verbessert zwar die Effizienz der Inhaltsproduktion, kann aber auch zur Erstellung solcher unerwünschten Inhalte missbraucht werden. Herkömmliche Prüfmethoden wie Schlüsselwortbibliotheken, semantische Modelle und Bildklassifizierung ("Pornografie-Erkennungsmodelle") sind relativ ausgereift, um nutzergenerierte Inhalte (UGC) zu erkennen. Die Merkmalsverteilung von KI-generierten Inhalten kann sich jedoch von derjenigen von UGC unterscheiden, und die Dienstanbieter müssen darauf achten, die Trainingsdaten des Modells zu aktualisieren, um die Erkennungsgenauigkeit zu erhalten.

Untersuchung und Umgang mit der Nutzung von KI, um sich als andere Personen auszugeben, um Verstöße zu begehen

Handlungen wie das Imitieren von Persönlichkeiten des öffentlichen Lebens durch KI-Gesichtstausch, Stimmenklonen und andere tiefgreifende Fälschungsmethoden zum Zwecke der Täuschung oder des Gewinns, das Spoofing und Diskreditieren von Persönlichkeiten des öffentlichen Lebens oder historischen Persönlichkeiten, der Einsatz von KI zur Verkörperung von Freunden und Verwandten, um Betrug zu begehen, sowie der missbräuchliche Einsatz von KI zur "Wiederauferstehung von Toten" und der Missbrauch von Informationen über Tote stehen im Mittelpunkt der Abhilfemaßnahmen. Diese Risiken ergeben sich aus dem Durchsickern und dem Missbrauch von persönlichen Daten. Es ist wichtig, die Öffentlichkeit für den Schutz der Privatsphäre zu sensibilisieren und langfristig einen Mechanismus zur Rückverfolgbarkeit von Daten einzurichten, um die Einhaltung der Datenschutzbestimmungen entlang der gesamten Kette zu gewährleisten.

Bekämpfung des Einsatzes von KI für cyber-terroristische Aktivitäten

Die "KI-Wasserarmee" ist eine neue Variante der Netzwerk-Wasserarmee. Der Einsatz von KI-Technologie zur Massenregistrierung und zum Betrieb sozialer Konten, der Einsatz von KI-Inhaltsfarmen oder KI-Manuskriptwaschanlagen zur Erzeugung minderwertiger homogenisierter Inhalte in großen Mengen, um den Strom zu bündeln, sowie der Einsatz von KI-Gruppenkontrollsoftware, sozialen Robotern, um das Ausmaß der Kontrolle und Bewertung zu bündeln, und andere Verhaltensweisen werden streng geahndet werden. Die Governance muss an den beiden Dimensionen Inhalt und Konto ansetzen, minderwertige und AIGC-Inhalte innerhalb der Plattform erkennen, die Verhaltensmerkmale von Konten, die AIGC-Inhalte veröffentlichen, überwachen und ein schnelles Eingreifen automatisieren, um die Kosten für das Übel der Wasserarmeen zu erhöhen.

Regulierung des Verhaltens von KI-Produktdiensten und -Anwendungen

Die Herstellung und Verbreitung von gefälschten KI-Websites und -Anwendungen, die Bereitstellung von nicht konformen Funktionen durch KI-Anwendungen (z. B. die Bereitstellung von "Hot Search und Hot List Expansion" durch Autorentools), die Bereitstellung von vulgären und softpornografischen Dialogdiensten durch KI-Software für soziale Chats sowie der Verkauf und die Werbung für nicht konforme KI-Anwendungen, -Dienste oder -Kurse, die Menschen von der Nutzung von KI-Produkten abhalten, fallen allesamt in den Anwendungsbereich der Abhilfemaßnahmen. Damit wird die Konformität der Markteinführung und Verbreitung von KI-Produkten erneut betont und die Definition von "Hülle" und illegalen Funktionen hinzugefügt. Dienstleistungsanbieter sollten sich an die ursprüngliche Absicht der Technologie halten, den Menschen zu dienen.

Schutz der Rechte und Interessen von Minderjährigen vor AI

Ein weiterer Schwerpunkt dieser Sonderaktion sind KI-Anwendungen, die Minderjährige in die Abhängigkeit treiben, oder Inhalte, die ihre körperliche und geistige Gesundheit beeinträchtigen, und die noch unter den Jugendschutz fallen. Daher erfordert die Anwendung von KI in Bildungsszenarien für Minderjährige besondere Vorsicht und eine strenge Kontrolle der Nutzung der Szenarien; bei anderen Produkten, mit denen Minderjährige häufig in Berührung kommen, sollte der Jugendschutzmodus verschärft und die KI-Anwendungsrechte eingeschränkt werden.