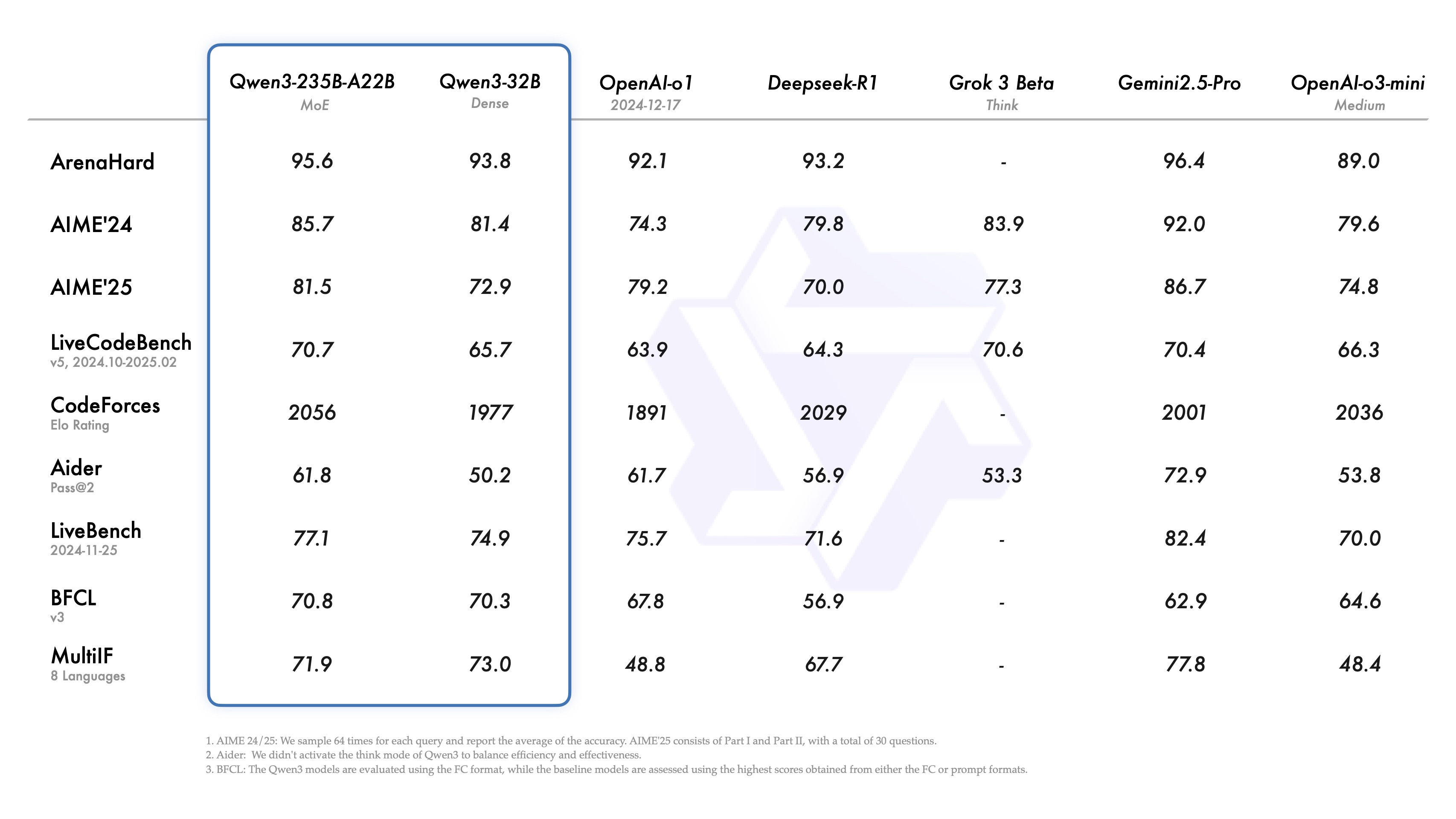

Der Bereich der großen Sprachmodelle hat ein neues Mitglied. Kürzlich hat die Qwen-Familie großer Sprachmodelle ihre neueste Version, Qwen3, veröffentlicht. Nach Angaben des Entwicklerteams hat sich gezeigt, dass ihr Flaggschiff, Qwen3-235B-A22B, in Benchmarks für Codierungs-, mathematische und allgemeine Fähigkeiten mit Qwen3-235B-A22B vergleichbar ist. DeepSeek-R1 , o1 . o3-mini Der Qwen3 ist so konzipiert, dass er die Leistung der Topmodelle der Branche wie dem Grok-3 und dem Gemini-2.5-Pro erreicht. Die Auswahl dieser Konkurrenten spiegelt die Positionierung des Qwen3 wider, da er in direktem Dialog mit den aktuellen Leistungsmaßstäben stehen soll.

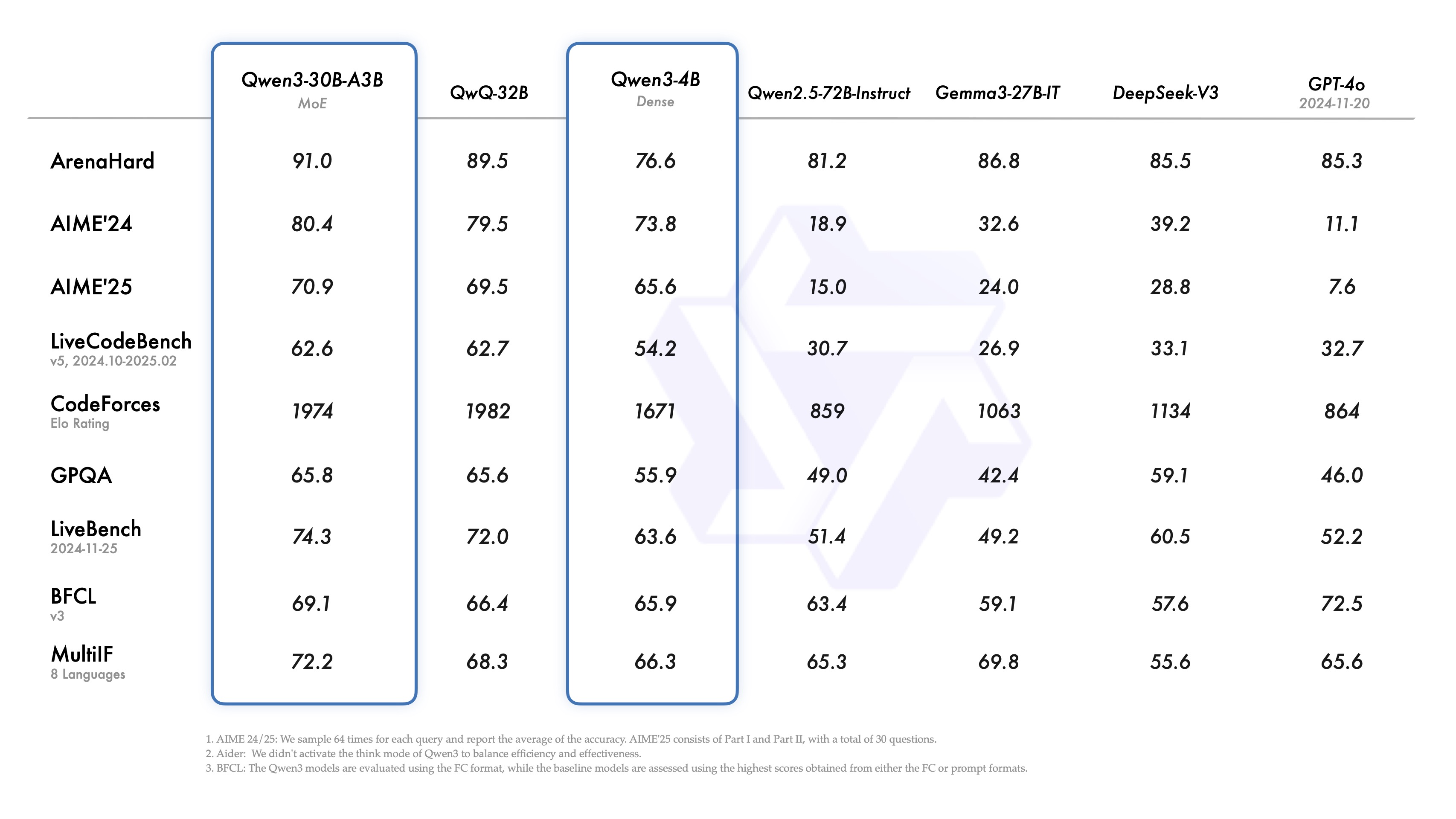

Interessant ist, dass das kleine Mixed Expert (MoE)-Modell Qwen3-30B-A3B die Leistung von QwQ-32B mit einer größeren Anzahl von Kovariaten (wenn auch mit einem Zehntel der Aktivierungsparameter des letzteren) übertrifft, und sogar das kleinere Modell Qwen3-4B soll die Leistung von Qwen2.5-72B-Instruct erreichen. Dies zeigt einen erheblichen Effizienzgewinn aufgrund der optimierten Modellarchitektur und der verbesserten Trainingsmethoden.

Ein Höhepunkt der Veröffentlichung ist die Freigabe der Gewichte von zwei MoE-Modellen: Qwen3-235B-A22B (235 Milliarden Gesamtparameter, 22 Milliarden aktiviert) und Qwen3-30B-A3B (30 Milliarden Gesamtparameter, 3 Milliarden aktiviert). MoE ist eine Technik, die es einem Modell ermöglicht, nur einen Teil des "Experten"-Netzes zu aktivieren, wenn es Schlussfolgerungen zieht. MoE ist eine Technik, die es den Modellen ermöglicht, nur einen Teil des "Experten"-Netzes zu aktivieren, wenn sie Schlussfolgerungen ziehen. Dadurch werden die Rechenanforderungen erheblich reduziert, während die Leistungsfähigkeit beibehalten wird, was für den Einsatz großer Modelle in einem breiteren Spektrum von Szenarien wichtig ist.

Außerdem hat das Team gemäß der Apache-2.0-Lizenz die Gewichte für sechs dichte Modelle mit einer Parameterabdeckung von 600 Millionen bis 32 Milliarden geöffnet, nämlich Qwen3-32B, Qwen3-14B, Qwen3-8B, Qwen3-4B, Qwen3-1.7B und Qwen3-0.6B.

Überblick über die Modellspezifikationen (dichte Modelle):

| Modelle | Schichten | Köpfe (Q / KV) | Krawatte einbetten | Kontext Länge |

|---|---|---|---|---|

| Qwen3-0.6B | 28 | 16 / 8 | Ja | 32K |

| Qwen3-1.7B | 28 | 16 / 8 | Ja | 32K |

| Qwen3-4B | 36 | 32 / 8 | Ja | 32K |

| Qwen3-8B | 36 | 32 / 8 | Nein | 128K |

| Qwen3-14B | 40 | 40 / 8 | Nein | 128K |

| Qwen3-32B | 64 | 64 / 8 | Nein | 128K |

Übersicht über die Modellspezifikationen (MoE-Modell):

| Modelle | Schichten | Köpfe (Q / KV) | # Experten (Gesamt / Aktiviert) | Kontext Länge |

|---|---|---|---|---|

| Qwen3-30B-A3B | 48 | 32 / 4 | 128 / 8 | 128K |

| Qwen3-235B-A22B | 94 | 64 / 4 | 128 / 8 | 128K |

Diese Modelle und ihre vortrainierten Versionen (z. B. Qwen3-30B-A3B-Base) sind bereits auf wichtigen Plattformen wie Hugging Face, ModelScope, Kaggle und anderen verfügbar. Für den Einsatz der Modelle wird die Verwendung von SGLang und vLLM und andere Frameworks. Für lokale Anwendungsszenarien sind Ollama, LMStudio, MLX lama.cppund KTransformatoren und andere Tools ermöglichen einen einfachen Zugang.

Entwickler können die Qwen Chat Web und mobile Anwendungen, um die Leistungsfähigkeit von Qwen3 zu erleben.

Analyse der Hauptmerkmale

Qwen3 führt mehrere bemerkenswerte Funktionen ein:

- Hybride DenkmodiQwen3 unterstützt zwei Problemlösungsmodi:

- Modus des Denkens. Das Modell führt eine schrittweise Argumentation durch, zeigt den Denkprozess und gibt dann die endgültige Antwort. Dies gilt für komplexe Probleme, die eine eingehende Analyse erfordern.

- Nicht-Denk-Modus. Das Modell ermöglicht eine schnelle, nahezu sofortige Reaktion in Szenarien, in denen es auf Geschwindigkeit ankommt und das Problem relativ einfach ist.

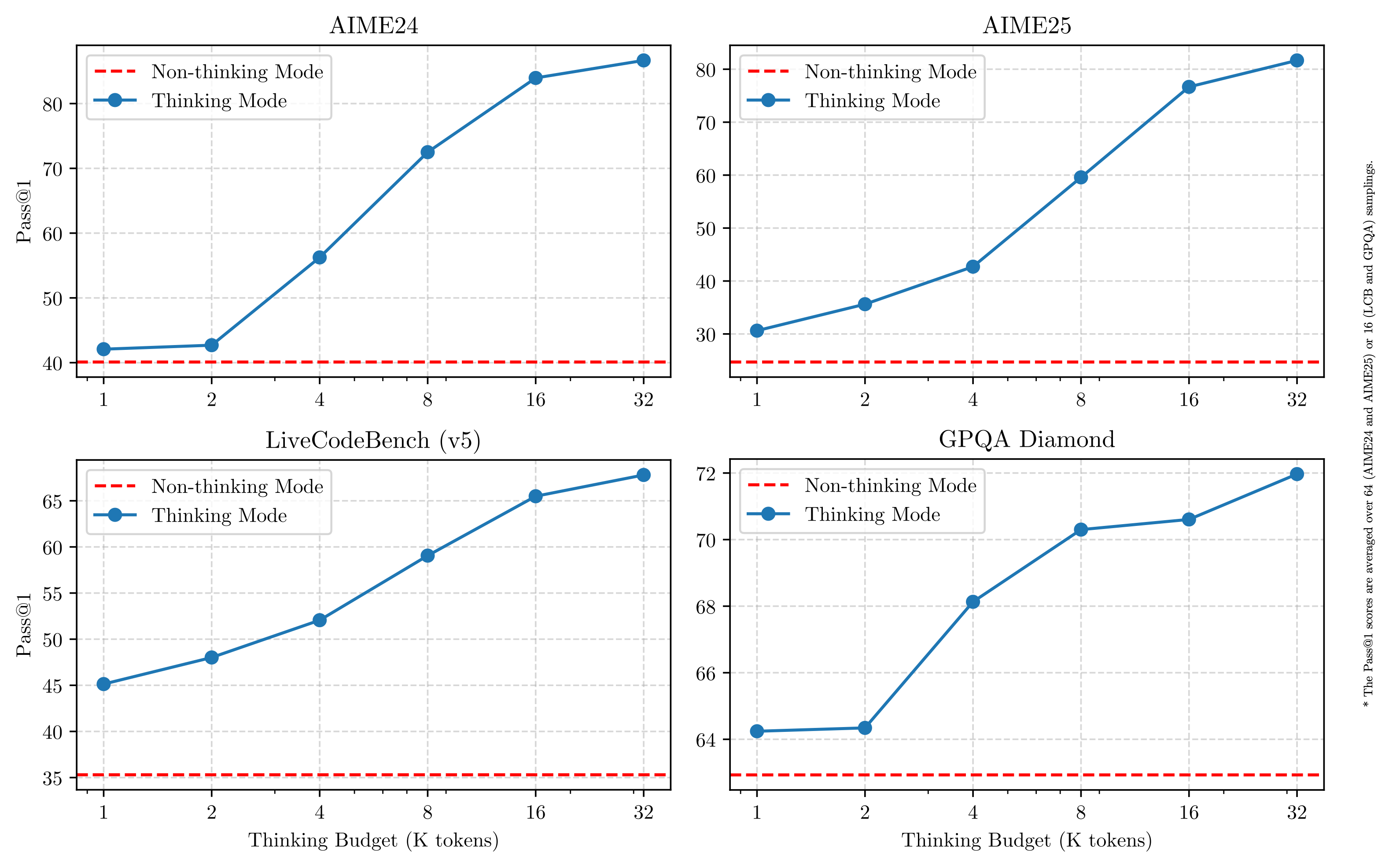

Diese Konstruktion gibt dem Benutzer die Flexibilität, die "Denktiefe" des Modells je nach den Anforderungen der Aufgabe zu steuern. Noch wichtiger ist, dass dieses Hybridmodell eine stabile und effiziente Steuerung des "Denkbudgets" des Modells ermöglicht. Wie in der Abbildung unten zu sehen ist, weist die Leistung von Qwen3 eine Skalierbarkeit und gleichmäßige Verbesserungen auf, die in direktem Zusammenhang mit dem zugewiesenen Budget für das logische Denken stehen. Die Benutzer können die Budgets für bestimmte Aufgaben leichter konfigurieren und so ein besseres Gleichgewicht zwischen Kosteneffizienz und Denkqualität finden. Dies liefert neue Ideen für das Kostenmanagement von großen Modellen in realen Anwendungen.

- Umfassende mehrsprachige UnterstützungQwen3-Modelle unterstützen bis zu 119 Sprachen und Dialekte. Diese umfassende Mehrsprachigkeit eröffnet neue Möglichkeiten für internationalisierte Anwendungen und hilft globalen Benutzern, die Vorteile der Modelle zu nutzen.

Sprache Familie Sprachen und Dialekte Indo-Europäisch Englisch, Französisch, Portugiesisch, Deutsch, Rumänisch, Schwedisch, Dänisch, Bulgarisch, Russisch, Tschechisch, Griechisch, Ukrainisch, Spanisch, Niederländisch, Slowakisch, Kroatisch. Polnisch, Litauisch, Norwegisch Bokmål, Norwegisch Nynorsk, Persisch, Slowenisch, Gujarati, Lettisch, Italienisch, Okzitanisch, Nepali, Marathi, Weißrussisch. Serbisch, Luxemburgisch, Venezianisch, Assamesisch, Walisisch, Schlesisch, Asturisch, Chhattisgarhi, Awadhi, Maithili, Bhojpuri, Sindhi, Irisch, Färöisch, Hindi. Punjabi, Bengali, Oriya, Tadschikisch, Ostjiddisch, Lombardisch, Ligurisch, Sizilianisch, Friaulisch, Sardisch, Galicisch, Katalanisch, Isländisch, Toskisch Albanisch. Limburgisch, Dari, Afrikaans, Mazedonisch, Singhalesisch, Urdu, Magahi, Bosnisch, Armenisch Sino-Tibetisch Chinesisch (Vereinfachtes Chinesisch, Traditionelles Chinesisch, Kantonesisch), Birmanisch Afroasiatisch Arabisch (Standard, Najdi, Levantiner, Ägyptisch, Marokkanisch, Mesopotamisch, Ta'izzi-Adeni, Tunesisch), Hebräisch, Maltesisch Austronesisch Indonesisch, Malaiisch, Tagalog, Cebuano, Javanisch, Sundanisch, Minangkabau, Balinisch, Banjar, Pangasinan, Iloko, Waray (Philippinen) Dravidisch Tamil, Telugu, Kannada, Malayalam Türkisch Türkisch, Nord-Aserbaidschanisch, Nord-Usbekisch, Kasachisch, Baschkirisch, Tatarisch Tai-Kadai Thailändisch, Laotisch Uralisch Finnisch, Estnisch, Ungarisch Austroasiatisch Vietnamesisch, Khmer Andere Japanisch, Koreanisch, Georgisch, Baskisch, Haitianisch, Papiamento, Kabuverdianu, Tok Pisin, Swahili - Verbesserte AgentenkapazitätenDas Qwen3-Modell ist für die Codierung und die Fähigkeit, Aufgaben als intelligenter Agent auszuführen, optimiert. Das Team hat auch die Unterstützung für MCP (Multi-Agent Collaboration Platform) verbessert. Der unten stehende Videolink zeigt, wie Qwen3 denkt und mit der Umgebung interagiert (z. B. das Aufrufen von Tools).Link zur Videopräsentation: https://qianwen-res.oss-accelerate-overseas.aliyuncs.com/mcp.mov

Details zur Ausbildung: Daten, Phasen und Optimierung

Die Menge der Pre-Training-Daten für Qwen3 ist deutlich größer als die von Qwen2.5, das 18 Billionen Token verwendete, und Qwen3, das mit etwa 36 Billionen Token fast doppelt so viele Pre-Training-Daten hat und 119 Sprachen und Dialekte abdeckt.

Zu den Datenquellen gehörten nicht nur Webseiten, sondern auch PDF-ähnliche Dokumente. Das Team nutzt Qwen2.5-VL Das Modell extrahierte Text aus diesen Dokumenten und verwendete Qwen2.5, um die Qualität der extrahierten Inhalte zu verbessern. Um den Anteil der Mathematik- und Codedaten zu erhöhen, wurden mit Qwen2.5-Math und Qwen2.5-Coder auch synthetische Daten wie Lehrbücher, Quizpaare und Codeschnipsel erzeugt.

Der Vorschulungsprozess ist in drei Phasen unterteilt:

- Phase S1. Mehr als 30 Billionen Dollar Token In dieser Phase wird das Modell mit einer Kontextlänge von 4K Token trainiert, um ihm grundlegende sprachliche Fähigkeiten und allgemeine Kenntnisse zu vermitteln.

- Phase S2. Erhöhung des Anteils wissensintensiver Daten (z. B. MINT-, Codierungs- und Schlussfolgerungsaufgaben), Optimierung des Datensatzes und Fortsetzung des Pre-Trainings mit weiteren 5 Billionen Token.

- Phase S3. Die Verwendung von qualitativ hochwertigen langen Kontextdaten erweitert die Kontextlänge des Modells auf 32K Token (und sogar 128K bei einigen Modellen) und stellt sicher, dass das Modell lange Eingaben effizient verarbeiten kann.

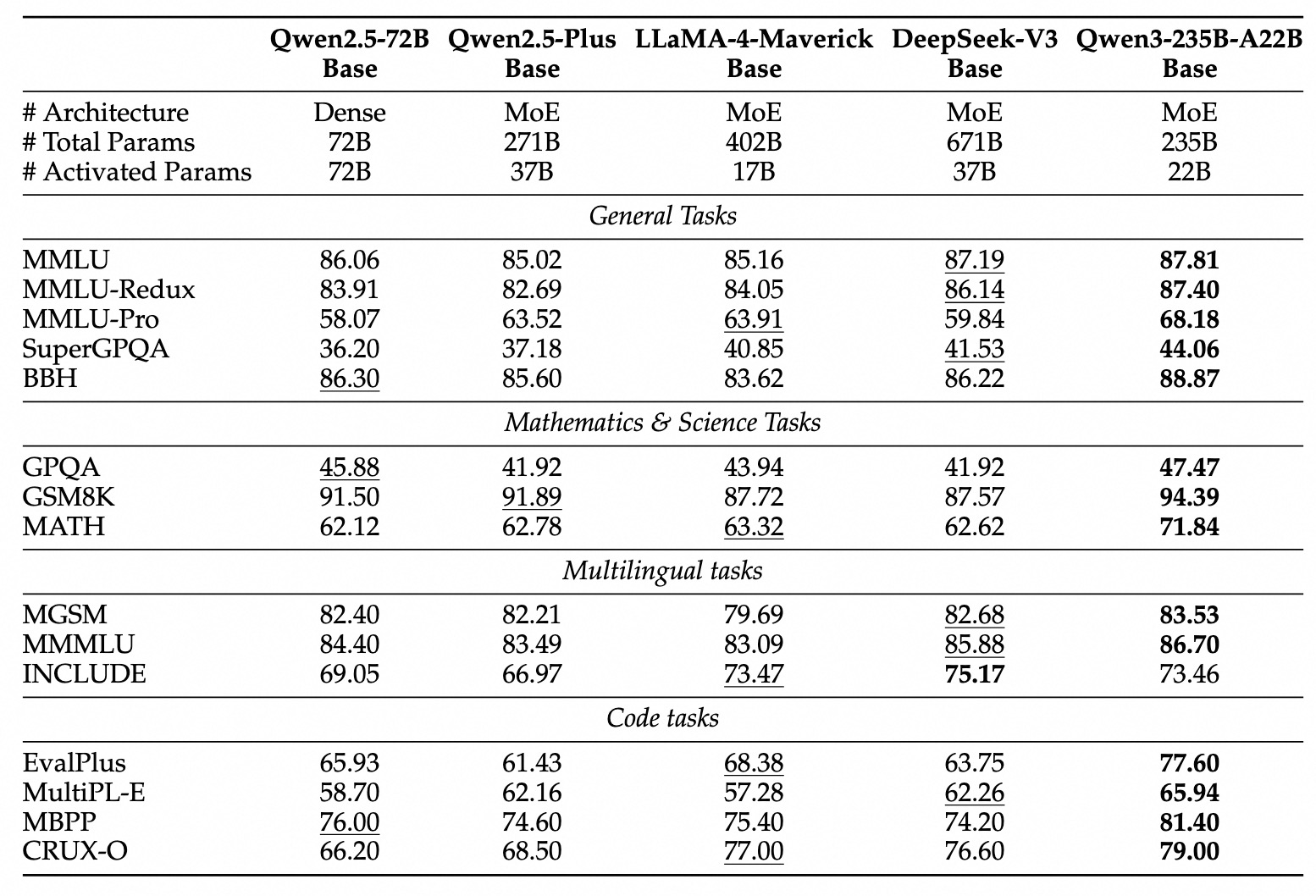

Dank der verbesserten Modellarchitektur, einer größeren Anzahl von Trainingsdaten und effizienteren Trainingsmethoden erreicht die Gesamtleistung des dichten Basismodells Qwen3 das Niveau des Basismodells Qwen2.5, das eine viel größere Anzahl von Kovariaten aufweist. Beispielsweise ist die Leistung von Qwen3-1.7B/4B/8B/14B/32B-Base vergleichbar mit der von Qwen2.5-3B/7B/14B/32B/72B-Base. Insbesondere das dichte Qwen3-Basismodell übertrifft sogar das größere Qwen2.5-Modell in Bereichen wie STEM, Codierung und Inferenz.

Für das Qwen3-MoE-Basismodell erreichen sie mit nur etwa 10% Aktivierungsparametern eine ähnliche Leistung wie das dichte Qwen2.5-Basismodell, was erhebliche Einsparungen bei den Trainings- und Inferenzkosten bedeutet.

Prozess nach der Ausbildung

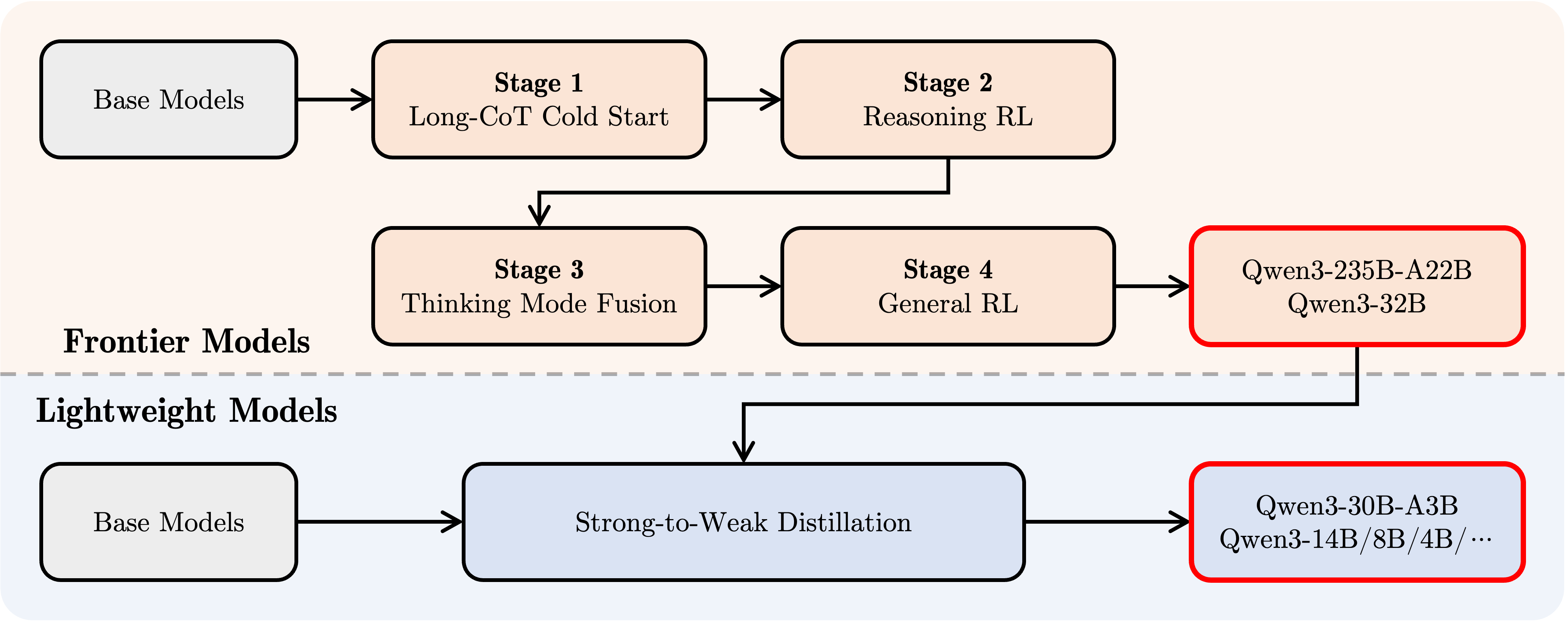

Um ein gemischtes Modell zu entwickeln, das schrittweises Denken mit schnellen Reaktionsmöglichkeiten kombiniert, implementierte das Qwen-Team einen vierstufigen Nachschulungsprozess:

- Langer CoT-Kaltstart. Die Modelle werden mit Hilfe von langen Gedankenketten abgestimmt, die verschiedene Aufgaben und Bereiche wie Mathematik, Codierung, logisches Denken, MINT usw. abdecken, mit dem Ziel, grundlegende logische Fähigkeiten zu entwickeln.

- Vernunftbasiertes RL. Ausweitung der Investition von Rechenressourcen in das Verstärkungslernen und Nutzung von regelbasierten Belohnungen (RBR) zur Verbesserung der Erkundung und Nutzung von Modellen, um die Inferenzleistung weiter zu verbessern.

- Konvergenz der Denkmuster. Integration von Nicht-Denkfähigkeiten in das Denkmodell. Die Integration von Denk- und Schnellreaktionsfähigkeiten wird durch Feinabstimmung einer Mischung aus langen CoT-Daten und verallgemeinerten Befehls-Feinabstimmungsdaten (die durch das erweiterte Denkmodell in Phase 2 generiert werden) erreicht.

- Allgemeines Reinforcement Learning (Allgemeines RL). Verstärkungslernen wird auf über 20 generische Domänenaufgaben angewandt, um die generischen Fähigkeiten des Modells weiter zu stärken (z. B. Befolgung von Anweisungen, Einhaltung von Formaten, Fähigkeiten des Agenten usw.) und um unerwünschte Verhaltensweisen zu korrigieren.

Entwicklung mit Qwen3

Hier ist eine kurze Anleitung zur Verwendung von Qwen3 in verschiedenen Frameworks. Das erste ist ein Standardbeispiel für die Verwendung von Qwen3-30B-A3B in der Hugging Face Transformers Library:

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-30B-A3B"

# 加载 tokenizer 和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备模型输入

prompt = "给我简要介绍一下大型语言模型。"

messages = [

{"role": "user", "content": prompt}

]

# apply_chat_template 用于构建符合 Qwen 对话格式的输入

# enable_thinking=True 启用思考模式 (默认为 True)

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True # 在思考模式和非思考模式间切换,默认为 True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 进行文本生成

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)

# 提取生成的内容部分 (去除输入部分)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解析思考内容 (如果存在)

# 寻找 '</think>' 对应的 token id (151668)

try:

# rindex 从后往前查找 151668

index = len(output_ids) - output_ids[::-1].index(151668)

except ValueError:

# 如果没有找到 '</think>',说明没有思考内容

index = 0

# 分别解码思考内容和最终回复内容

thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip("\n")

content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip("\n")

print("思考内容:", thinking_content)

print("最终回复:", content)

Um den Denkmodus zu deaktivieren, setzen Sie den Parameter enable_thinking einfach auf False:

text = tokenizer.apply_chat_template( messages, tokenize=False, add_generation_prompt=True, enable_thinking=False # 默认为 True )

Für die Modellbereitstellung können Endpunkte, die mit der OpenAI-API kompatibel sind, mit sglang>=0.4.6.post1 oder vllm>=0.8.4 erstellt werden:

- SGLang verwenden.

python -m sglang.launch_server --model-path Qwen/Qwen3-30B-A3B --reasoning-parser qwen3

- Verwendung von vLLM.

vllm serve Qwen/Qwen3-30B-A3B --enable-reasoning --reasoning-parser deepseek_r1

(Hinweis: Der Originalartikel hier verwendet den deepseek_r1 Parser, Entwickler müssen dessen Kompatibilität mit Qwen3 prüfen)

In der lokalen Entwicklungsumgebung kann ollama mit einem einfachen Befehl verwendet werden ollama qwen3:30b-a3b ausführen, um mit dem Modell zu interagieren. Darüber hinaus unterstützen Tools wie LMStudio, llama.cpp und ktransformers die Erstellung und den lokalen Betrieb von Qwen3.

Fortgeschrittene Nutzung: Dynamisches Umschalten der Denkmodi

Qwen3 bietet einen "Soft-Switching"-Mechanismus, der es dem Benutzer ermöglicht, das Verhalten des Modells dynamisch zu steuern, wenn enable_thinking=True. Sie können insbesondere /think- oder /no_think-Tags zu Benutzerfragen oder Systemmeldungen hinzufügen, um den Denkmodus des Modells von Runde zu Runde umzuschalten. In einem Dialog mit mehreren Runden folgt das Modell der letzten Anweisung.

Im Folgenden wird ein Beispiel für einen Mehrrunden-Dialog gegeben:

from transformers import AutoModelForCausalLM, AutoTokenizer

class QwenChatbot:

def __init__(self, model_name="Qwen/Qwen3-30B-A3B"):

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

# 注意:实际运行时需要确保有足够的 GPU 显存加载模型

# device_map="auto" 可能需要根据实际硬件调整

self.model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto", # 自动选择合适的精度

device_map="auto" # 自动分配模型到可用设备

)

self.history = [] # 用于存储对话历史

def generate_response(self, user_input):

# 将当前用户输入加入历史记录

messages = self.history + [{"role": "user", "content": user_input}]

# 使用 apply_chat_template 构建输入

# 注意:这里没有显式设置 enable_thinking,会使用模型的默认行为或最近的 /think /no_think 指令

text = self.tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

inputs = self.tokenizer(text, return_tensors="pt").to(self.model.device)

# 生成回复

response_ids = self.model.generate(

**inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)[0][len(inputs.input_ids[0]):].tolist() # 提取生成内容

# 解码回复文本

response = self.tokenizer.decode(response_ids, skip_special_tokens=True).strip()

# 更新对话历史

self.history.append({"role": "user", "content": user_input})

# 注意:此处仅添加解码后的纯文本回复,未处理思考内容

# 如果需要保留或展示思考过程,需要像之前的例子一样解析 output_ids

self.history.append({"role": "assistant", "content": response})

# 返回解码后的回复文本

return response

# 示例用法

if __name__ == "__main__":

# 确保在有足够资源的机器上运行

try:

chatbot = QwenChatbot()

# 第一次输入 (默认启用思考模式)

user_input_1 = "strawberries 这个单词里有多少个 'r'?"

print(f"用户: {user_input_1}")

response_1 = chatbot.generate_response(user_input_1)

print(f"助手: {response_1}")

print("----------------------")

# 第二次输入,使用 /no_think 禁用思考模式

user_input_2 = "那么,blueberries 这个单词里有多少个 'r'? /no_think"

print(f"用户: {user_input_2}")

response_2 = chatbot.generate_response(user_input_2)

print(f"助手: {response_2}")

print("----------------------")

# 第三次输入,使用 /think 再次启用思考模式

user_input_3 = "真的吗?请再想想。 /think"

print(f"用户: {user_input_3}")

response_3 = chatbot.generate_response(user_input_3)

print(f"助手: {response_3}")

except Exception as e:

print(f"运行出错: {e}")

print("请确保已安装所需依赖,并拥有足够的计算资源(如 GPU 显存)。")

Agentennutzung: Werkzeuganruf

Qwen3 zeichnet sich durch seine Fähigkeit aus, Werkzeuge aufzurufen. Empfohlene Verwendung Qwen-Agent Framework (https://github.com/QwenLM/Qwen-Agent), um die Vorteile der Agent-Funktionen von Qwen3 voll auszuschöpfen. Qwen-Agent kapselt Vorlagen und Parser für Tool-Aufrufe intern und vereinfacht so die Entwicklung.

Dies kann geschehen durch MCP Konfigurationsdateien, die Verwendung der Integrationswerkzeuge von Qwen-Agent oder die eigene Integration anderer Werkzeuge, um die Menge der verfügbaren Werkzeuge zu definieren.

import os

from qwen_agent.agents import Assistant

# 定义 LLM 配置

llm_cfg = {

'model': 'Qwen3-30B-A3B', # 指定使用的 Qwen3 模型

# 如果使用阿里云 ModelScope 提供的 DashScope API:

# 'model_type': 'qwen_dashscope',

# 'api_key': os.getenv('DASHSCOPE_API_KEY'), # 需要设置环境变量

# 如果使用兼容 OpenAI API 的自定义端点 (例如 VLLM 或 SGLang 部署的):

'model_server': 'http://localhost:8000/v1', # 替换为你的 API 地址

'api_key': 'EMPTY', # 对于本地部署或不需要 key 的情况

# 可选:其他生成参数配置

# 'generate_cfg': {

# # 如果模型的原始输出将思考过程 <think>...</think> 包含在最终内容里,设为 True

# # 如果 VLLM/SGLang 等框架已分离 reasoning_content 和 content,则设为 False 或不设置

# 'thought_in_content': False,

# },

}

# 定义工具列表

tools = [

{'mcpServers': { # 可以指定 MCP 配置文件或直接定义服务

'time': { # 定义一个名为 'time' 的工具

'command': 'uvx', # 使用 uvx 启动

# 启动参数,运行 mcp-server-time,并设置时区

'args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']

},

"fetch": { # 定义一个名为 'fetch' 的工具,用于访问网页

"command": "uvx",

"args": ["mcp-server-fetch"]

}

}

},

'code_interpreter', # 使用 Qwen-Agent 内置的代码解释器工具

# 可以继续添加其他自定义或内置工具

]

# 初始化 Agent

# 需要确保 uvx 和相应的 mcp-server-* 已安装并配置好

bot = Assistant(llm=llm_cfg, function_list=tools)

# 流式生成调用示例

messages = [{'role': 'user', 'content': '访问 https://qwenlm.github.io/blog/ 页面,并介绍一下 Qwen 的最新进展。'}]

responses = None # 初始化 responses 变量

# bot.run 返回一个生成器,用于流式输出

for responses in bot.run(messages=messages):

# 可以在这里处理中间步骤的输出,例如工具调用和观察结果

# print(responses) # 打印每个中间步骤或最终回复

pass # 循环结束后,responses 将包含最终的完整回复

# 打印最终的回复内容

if responses:

print(responses)

else:

print("未能获取到回复。")

(Hinweis: Um das Agent-Beispiel auszuführen, müssen Sie die qwen-agent-Bibliothek und die zugehörigen Abhängigkeiten installieren und sicherstellen, dass die Tools uvx und mcp-server-* verfügbar sind).

Zukunftsaussichten

Qwen3 wird als ein wichtiger Meilenstein auf dem Weg zu allgemeiner künstlicher Intelligenz (AGI) und künstlicher Superintelligenz (ASI) angesehen. Durch die Skalierung von Pre-Training und Reinforcement Learning erreicht das Modell ein höheres Maß an Intelligenz. Die Verschmelzung von hybriden Denkmustern bietet den Nutzern die Flexibilität, ihr Denkbudget zu kontrollieren, während die umfassende Sprachunterstützung die globale Zugänglichkeit verbessert.

Für die Zukunft plant das Qwen-Team die weitere Verbesserung der Modellfähigkeiten in mehreren Dimensionen, einschließlich der Optimierung von Modellarchitekturen und Trainingsmethoden für die Datenskalierung, die Vergrößerung der Modellgröße, die Ausweitung der Kontextlänge, die Erweiterung der Modalitätsunterstützung und die Verbesserung des Verstärkungslernens durch Umgebungsfeedback, um Schlussfolgerungen mit langem Zeithorizont zu ermöglichen. Das Team ist der Ansicht, dass sich die Industrie von der Ära des Trainings von "Modellen" zur Ära des Trainings von "Intelligenzen" (Agenten) bewegt. Die nächste Iteration verspricht weitere sinnvolle Fortschritte für die Arbeit und das Leben zu bringen.