Allgemeine Einführung

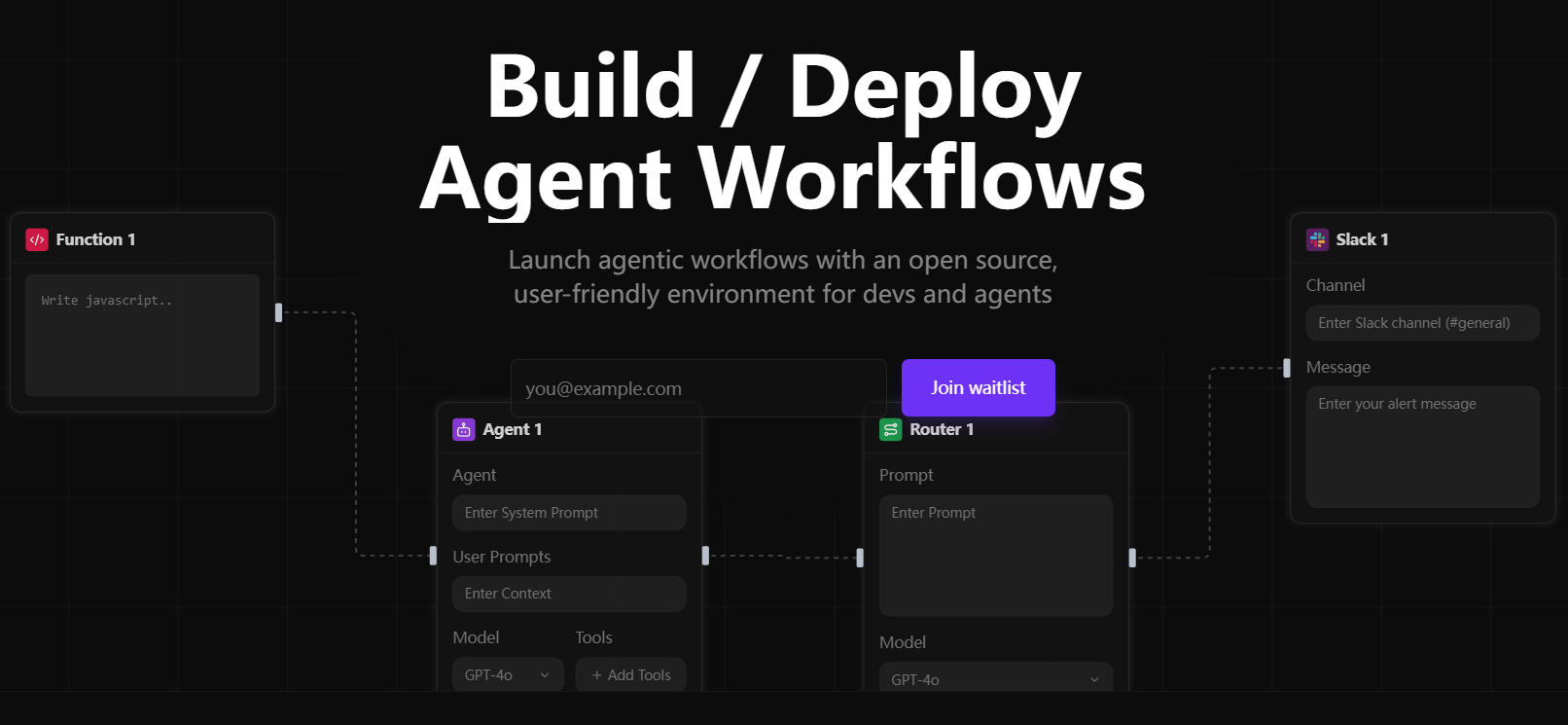

Sim Studio ist eine Open-Source-Plattform für die Erstellung von KI-Agenten-Workflows, die den Nutzern hilft, über eine leichtgewichtige, intuitive visuelle Schnittstelle schnell umfangreiche Sprachmodell-Workflows (LLM) zu entwerfen, zu testen und einzusetzen. Benutzer können komplexe Multi-Agenten-Anwendungen mit Drag-and-Drop ohne tiefgreifende Programmierung erstellen. Es unterstützt sowohl lokale als auch Cloud-Modelle und ist mit einer breiten Palette von Tool-Integrationen wie Slack und Datenbanken kompatibel.Sim Studio ist modular aufgebaut und eignet sich für Entwickler, Forscher und Unternehmensanwender. Eine offizielle, in der Cloud gehostete Version (https://simstudio.ai) und selbst gehostete Optionen sind verfügbar, um unterschiedliche Bedürfnisse zu erfüllen.

KI-Agenten-Frameworks gibt es heutzutage in Hülle und Fülle. Warum empfehle ich gerade Sim Studio? Ich habe eine Liste mit den Funktionen einiger der wichtigsten Open-Source-Frameworks für KI-Agenten zusammengestellt, die derzeit verfügbar sind:

| Name des Rahmens | zentrales Paradigma | Wichtigste Vorteile | Anwendbare Szenarien |

|---|---|---|---|

| LangGraph | Graph-basierter Prompting-Workflow | Explizite DAG-Kontrolle, Verzweigung und Fehlersuche | Komplexe mehrstufige Aufgaben, erweiterte Fehlerbehandlung |

| OpenAI Agenten SDK | OpenAI Advanced Toolchain | Integration von Tools wie Web- und Dateisuche | Teams, die sich auf das OpenAI-Ökosystem verlassen |

| Smolagents | Code-zentrierte Minimal-Agent-Schleifen | Einfache Einrichtung, direkte Codeausführung | Schnelle Automatisierung von Aufgaben ohne komplexe Choreografie |

| CrewAI | Multi-Agenten-Zusammenarbeit (Crews) | Rollenbasierter paralleler Arbeitsablauf mit gemeinsamem Speicher | Komplexe Aufgaben, die die Zusammenarbeit mehrerer Experten erfordern |

| AutoGen | asynchroner Multi-Agenten-Chat | Echtzeit-Dialog, ereignisgesteuert | Szenarien, die gleichzeitige Echtzeit- und Multi-LLM-"Sprach"-Interaktion erfordern |

| Sim-Studio | Visueller Workflow Builder | Intuitive Oberfläche, schnelle Bereitstellung, Open-Source-Flexibilität | Schnelles Prototyping und Bereitstellung einer Produktionsumgebung |

Es gibt heute eine ganze Reihe von Low-Code/No-Code-Plattformen zur Erstellung von KI-Agenten auf dem Markt, und ich habe eine Liste zusammengestellt, wie sie im Vergleich zu Sim Studio abschneiden:

| Terrasse | Besonderheiten | Anwendbare Szenarien | Preise |

|---|---|---|---|

| Vertex AI Builder | Code-freie Plattform der Unternehmensklasse mit komplexen APIs | Workflow-Automatisierung für Großunternehmen | die Kosten decken |

| Balken AI | Horizontale Plattform mit Unterstützung für mehrere Agenten vor Ort | Bereichsübergreifende Automatisierung (Compliance, Kundendienst usw.) | die Kosten decken |

| Microsoft Copilot Studio | Niedriger Code, 1200+ Datenverbindungen | Interner Chatbot, Auftragsverwaltung | die Kosten decken |

| Lyzr Agent Studio | Modular und für das Prototyping geeignet | Finanzen, Automatisierung der Personalverwaltung | die Kosten decken |

| Sim-Studio | Open Source, visuelle Schnittstelle, flexible Bereitstellung | Der gesamte Prozess vom Prototyp bis zur Produktion | frei und quelloffen |

Wie Sie sehen können, ist Sim Studio als Open-Source-Projekt in Bezug auf Funktionalität und Flexibilität nicht schlecht, und es besteht kein finanzieller Druck, es zu verwenden.

Funktionsliste

- Visueller Workflow-Editor Entwurf von KI-Agenten-Workflows mit einer Drag-and-Drop-Oberfläche, die bedingte Logik und mehrstufige Aufgaben unterstützt.

- Unterstützung mehrerer Modelle Kompatibel mit Cloud- und lokalen LLMs, z. B. mit lokalen Modellen, die über Ollama laufen.

- Werkzeugintegration Unterstützung für die Verbindung mit externen Tools wie Slack, Datenbanken und erweiterte Proxy-Funktionen.

- API-Bereitstellung Generierung von Workflow-APIs mit einem Klick zur einfachen Integration in andere Systeme.

- lokaler Einsatz Self-Hosting-Unterstützung über Docker oder manuell für datenschutzsensible Szenarien.

- Modulare Erweiterungen Erhöht die Flexibilität, indem es den Benutzern ermöglicht, Funktionsblöcke und Werkzeuge anzupassen.

- Protokollierung und Fehlersuche Detaillierte Protokolle für die Optimierung von Arbeitsabläufen und die Fehlerbehebung bereitstellen.

- Unterstützung von Entwicklungscontainern Vereinfachen Sie die Einrichtung lokaler Entwicklungsumgebungen mit VS Code-Entwicklungscontainern.

Hilfe verwenden

Das Herzstück von Sim Studio sind die leichtgewichtigen und intuitiven Funktionen zur Erstellung von Arbeitsabläufen. Im Folgenden werden der Installationsprozess, die Bedienung der Hauptfunktionen und die Verwendung spezieller Features detailliert beschrieben, um sicherzustellen, dass die Benutzer schnell loslegen können.

Einbauverfahren

Sim Studio bietet drei Optionen für das Selbsthosten: Docker (empfohlen), Entwicklungscontainer und manuelle Installation. Im Folgenden werden hauptsächlich Docker und die manuelle Installation beschrieben. Der Entwicklungscontainer ist für Entwickler geeignet, die mit VS Code vertraut sind.

Weg 1: Docker-Installation (empfohlen)

Docker bietet eine einheitliche Laufzeitumgebung, die für die meisten Benutzer geeignet ist. Docker und Docker Compose müssen zunächst installiert werden.

- Klonen der Codebasis

Läuft im Terminal:git clone https://github.com/simstudioai/sim.git cd sim

- Umgebungsvariablen konfigurieren

Kopieren und bearbeiten Sie die Umgebungsdatei:cp sim/.env.example sim/.env

in der .env-Datei konfiguriert:

- BETTER_AUTH_SECRET: Erzeugt einen Zufallsschlüssel für die Authentifizierung.

- RESEND_API_KEY: wird für die Überprüfung der Mailbox verwendet, wenn nicht gesetzt, wird der Überprüfungscode auf der Konsole ausgegeben.

- Datenbankeinstellungen: PostgreSQL wird standardmäßig verwendet, Sie müssen sicherstellen, dass der Datenbankdienst läuft.

- OLLAMA_HOST: auf http://host.docker.internal:11434 gesetzt, wenn ein lokales Modell verwendet wird.

- Neue Dienste

Führen Sie den folgenden Befehl aus:docker compose up -d --build

oder ein Skript verwenden:

./start_simstudio_docker.sh

Sobald der Dienst gestartet ist, besuchen Sie http://localhost:3000/w/, um auf die Workflow-Schnittstelle zuzugreifen.

- Management-Dienstleistungen

- Logbuch ansehen:

docker compose logs -f simstudio

- Einstellung von Dienstleistungen:

docker compose down

- Starten Sie den Dienst neu (nach der Code-Aktualisierung):

docker compose up -d --build

- Logbuch ansehen:

- Lokale Modelle verwenden

Wenn lokales LLM erforderlich ist (z.B. LLaMA), ziehen Sie das Modell:./sim/scripts/ollama_docker.sh pull <model_name>

Starten Sie Dienste, die lokale Modelle unterstützen:

./start_simstudio_docker.sh --local

Oder wählen Sie je nach Hardware:

# 有 NVIDIA GPU docker compose up --profile local-gpu -d --build # 无 GPU docker compose up --profile local-cpu -d --build

Wenn Sie bereits eine Ollama-Instanz haben, ändern Sie die Datei docker-compose.yml, um sie hinzuzufügen:

extra_hosts: - "host.docker.internal:host-gateway" environment: - OLLAMA_HOST=http://host.docker.internal:11434

Modus 2: Manuelle Installation

Für Entwickler, die eine benutzerdefinierte Umgebung mit installiertem Node.js, npm und PostgreSQL benötigen.

- Klonen und Installieren von Abhängigkeiten

git clone https://github.com/simstudioai/sim.git cd sim/sim npm install

- Konfiguration der Umgebung

Kopieren und bearbeiten Sie die Umgebungsdatei:cp .env.example .env

Konfigurieren Sie BETTER_AUTH_SECRET, Datenbankverbindungen usw.

- Initialisierung der Datenbank

Push-Datenbank-Architektur:npx drizzle-kit push

- Starten des Entwicklungsservers

npm run dev

Besuchen Sie http://localhost:3000.

Ansatz 3: Entwicklung von Containern

- Installieren Sie die Erweiterung Remote - Containers in VS Code.

- Öffnen Sie das Projektverzeichnis und klicken Sie auf "Reopen in Container".

- Führen Sie npm run dev oder sim-start aus, um den Dienst zu starten.

Hauptfunktionen

Das Herzstück von Sim Studio ist der visuelle Workflow-Editor, der im Folgenden beschrieben wird:

Arbeitsabläufe erstellen

- Melden Sie sich bei Sim Studio an (http://localhost:3000/w/).

- Klicken Sie auf "Neuer Workflow", um den Editor zu öffnen.

- Ziehen Sie den Knoten Agent und wählen Sie LLM (Cloud- oder lokales Modell).

- Fügen Sie einen Tools-Knoten hinzu (z. B. Slack oder Datenbank) und konfigurieren Sie die Parameter.

- Verwenden Sie den Knoten Bedingte Logik, um die Verzweigungslogik festzulegen.

- Verbinden Sie Knoten und speichern Sie Arbeitsabläufe.

Test Arbeitsablauf

- Klicken Sie auf "Test" und geben Sie die Beispieldaten ein.

- Anzeigen von Ausgaben und Protokollen zur Überprüfung der Knotenausführung.

- Passen Sie die Knoten oder die Logik nach Bedarf an und testen Sie erneut.

Arbeitsablauf bei der Bereitstellung

- Klicken Sie auf Bereitstellen und wählen Sie API generieren.

- Abrufen des API-Endpunkts (z. B. http://localhost:3000/api/workflow/).

- Testen Sie die API:

curl -X POST http://localhost:3000/api/workflow/<id> -d '{"input": "示例数据"}'

Debugging-Workflow

- Überprüfen Sie die Ein- und Ausgänge des Knotens, indem Sie das "Protokoll" im Editor anzeigen.

- Verwenden Sie die Versionskontrolle, um Workflow-Snapshots für ein einfaches Rollback zu speichern.

Featured Function Bedienung

- Lokale Modellunterstützung Die Ausführung eines lokalen Modells über Ollama ist für datenschutzsensitive Szenarien geeignet. Nach der Konfiguration wählen Sie das Modell am Agentenknoten aus und testen die Leistung.

- Werkzeugintegration Nehmen Sie Slack als Beispiel, geben Sie das API-Token in den Toolknoten ein, legen Sie das Nachrichtenziel fest und testen Sie die Funktionalität des Nachrichtenversands.

- Entwicklungscontainer Containerisierte Entwicklung über VS Code, mit automatischer Umgebungskonfiguration für schnelle Iteration.

caveat

- Bei Docker-Installationen ist darauf zu achten, dass Port 3000 nicht belegt ist.

- Lokale Modelle erfordern eine hohe Hardware-Konfiguration (16 GB RAM empfohlen, GPU optional).

- Produktionsumgebungen müssen mit RESEND_API_KEY und HTTPS konfiguriert werden.

- Aktualisieren Sie den Code regelmäßig:

git pull origin main docker compose up -d --build

Technologiepaket

Sim Studio verwendet ein modernes Technologiepaket, um Leistung und Entwicklungseffizienz zu gewährleisten:

- Abb. Muster Next.js (App-Router)

- umfassende Datenbank PostgreSQL + Drizzle ORM

- Akkreditierung : Bessere Autorisierung

- Schnittstellen : Shadcn, Rückenwind CSS

- Statusverwaltung : Zustand

- Prozess-Editor ReactFlow

- (Computer-)Datei Fumadocs

Anwendungsszenario

- Automatisierte Kundenbetreuung

Entwerfen Sie Multi-Agenten-Workflows, integrieren Sie Datenbanken und Slack, automatisieren Sie Antworten auf Kundenfragen und benachrichtigen Sie den menschlichen Kundendienst, geeignet für E-Commerce-Plattformen. - Datenanalyse

Erstellung von Workflows zur Extraktion von Daten aus Datenbanken, Aufruf von LLM zur Erstellung von Berichten, Bereitstellung als APIs, geeignet für Finanzanalysen. - Pädagogische Instrumente

Erstellung interaktiver Lernagenten, Kombination lokaler Modelle zur Beantwortung von Fragen und Integration von Tools zur Erstellung von Testfragen für den Online-Unterricht.

QA

- Unterstützt Sim Studio Windows?

Windows wird unterstützt, erfordert aber Docker Desktop oder Node.js. Der Docker-Ansatz wird empfohlen, um eine einheitliche Umgebung zu gewährleisten. - Wie kann ich mich mit einer bestehenden Ollama-Instanz verbinden?

Ändern Sie docker-compose.yml, fügen Sie die Zuordnung host.docker.internal hinzu und setzen Sie OLLAMA_HOST. - Welche Hardware ist für ein lokales Modell erforderlich?

16 GB RAM empfohlen, GPU für bessere Leistung, kann auf weniger leistungsfähigen Geräten langsam laufen. - Wie kann ich Code beisteuern?

Siehe https://github.com/simstudioai/sim/blob/main/.github/CONTRIBUTING.md.