继上月推出新一代开放模型 Gemma 3 后,Google 近日再次拓展其模型生态,发布了基于量化感知训练 (Quantization-Aware Training, QAT) 优化的新版本。 Gemma 3 此前已凭借其在 BF16 精度下于单个高端 GPU(如 NVIDIA H100)上运行的能力,证明了其领先性能。而 QAT 版本的推出,旨在显著降低模型的内存需求,同时尽可能保持高质量输出,从而让强大的 AI 模型能够在更多消费级硬件上运行。

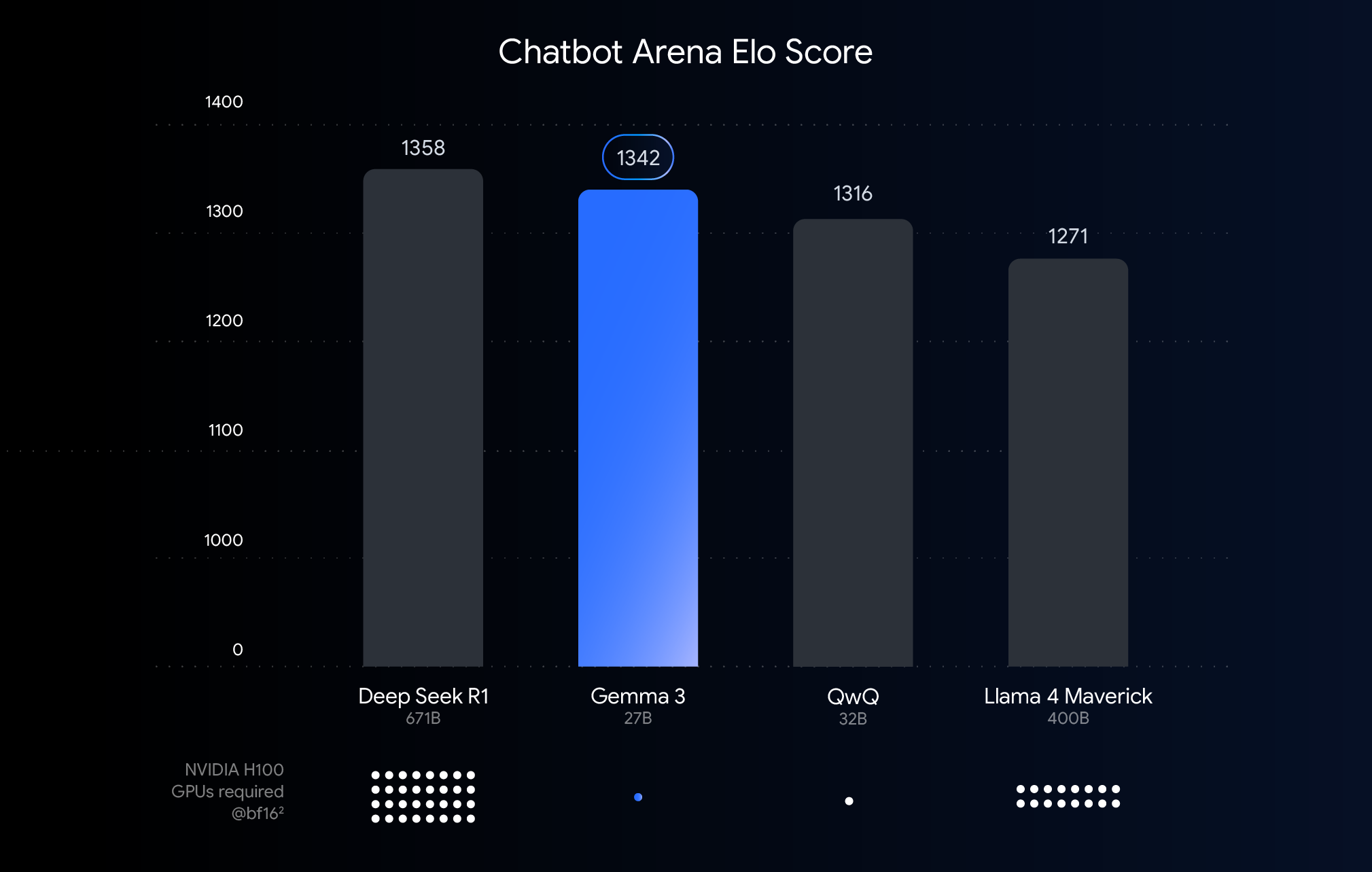

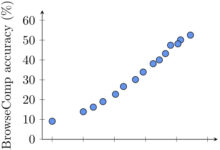

该图表依据 Chatbot Arena Elo 分数对 AI 模型进行排名,分数越高代表用户偏好度越高。圆点标注了模型运行所需 NVIDIA H100 GPU 的预估数量。

理解性能、精度与量化门槛

上图展示了近期发布的大型语言模型的性能(Elo 分数)对比。更高的柱状图意味着模型在人类评估者进行的匿名并排比较中表现更佳。图表下方标注了在 BF16 数据类型下运行各模型所需的 NVIDIA H100 GPU 预估数量。

选择 BF16 进行比较,是因为它是许多大型模型推理时常用的数值格式,代表模型参数以 16 位精度存储。在统一的 BF16 设置下比较,有助于在相同的推理配置中评估模型本身的固有能力,排除了不同硬件或量化等优化技术带来的变量。

值得注意的是,虽然该图表使用 BF16 进行公平比较,但在实际部署超大型模型时,为了降低对硬件(如图形处理器数量)的巨大需求,通常需要采用如 FP8 等更低精度的格式,这可能需要在性能和可行性之间做出权衡。

打破硬件壁垒:让 AI 更易获得

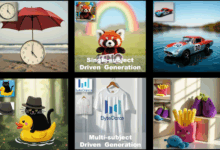

尽管 Gemma 3 在高端硬件上表现出色,适用于云部署和研究场景,但用户反馈清晰地表明,市场期望能在现有硬件上运用 Gemma 3 的能力。推动强大 AI 技术的普及,意味着需要让模型在台式机、笔记本电脑甚至移动设备中常见的消费级 GPU 上也能高效运行。在本地运行大型模型,不仅可以增强数据隐私性、降低网络延迟、支持离线应用,还为用户提供了更大的定制化空间。

QAT 技术:平衡性能与可访问性的关键

量化技术是实现这一目标的关键。在 AI 模型中,量化旨在降低模型存储和计算时使用的数字(即模型参数)的精度。这类似于通过减少图像使用的颜色数量来压缩图像。相较于每个数字使用 16 位 (BF16),量化可以使用更少的位数,例如 8 位 (int8) 甚至 4 位 (int4)。

采用 int4 意味着每个数字仅用 4 位表示,数据大小相比 BF16 减少了 4 倍。传统的量化方法(如训练后量化 PTQ)通常在模型训练完成后进行,虽然易于实施,但可能导致明显的性能下降。此次 Google 采用的 QAT 技术则有所不同。

QAT 在模型训练过程中就引入了量化步骤,模拟低精度运算。这种方法允许模型在训练时就适应低精度环境,从而在后续量化时能够更好地保持准确性,实现更小、更快的模型。具体而言,Google 对 Gemma 3 模型应用了约 5000 步的 QAT,以未量化检查点的概率作为目标。据称,通过这种方式,在量化到 Q4_0 格式时,困惑度(Perplexity,衡量模型预测能力的指标)的下降幅度减少了 54% (使用 llama.cpp 评估)。

显著效果:VRAM 占用大幅降低

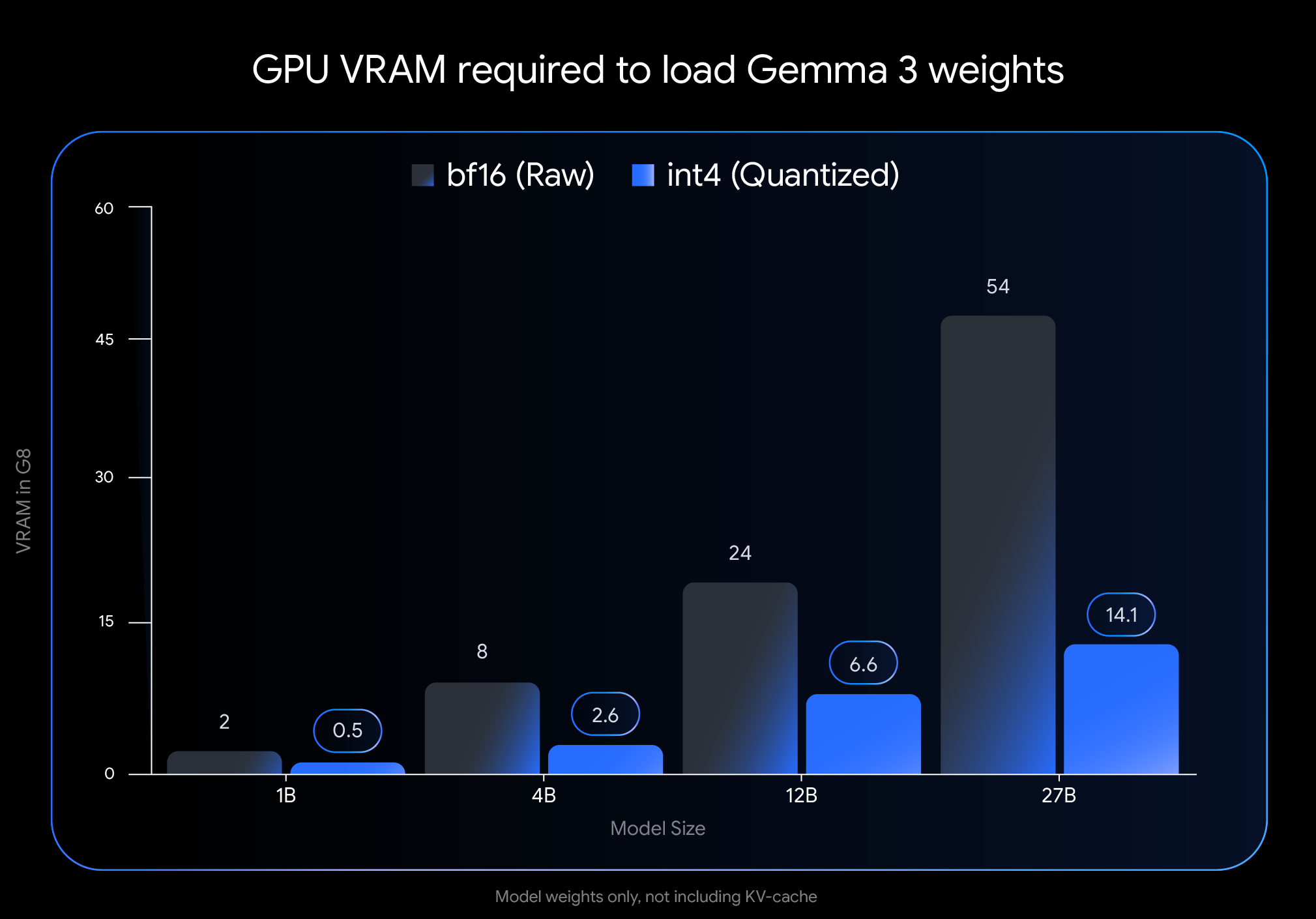

int4 量化带来的影响是显著的,尤其是在加载模型权重所需的显存 (VRAM) 方面:

- Gemma 3 27B: 从 54 GB (

BF16) 降至 14.1 GB (int4) - Gemma 3 12B: 从 24 GB (

BF16) 缩减至 6.6 GB (int4) - Gemma 3 4B: 从 8 GB (

BF16) 减少至 2.6 GB (int4) - Gemma 3 1B: 从 2 GB (

BF16) 降至 0.5 GB (int4)

注意: 此数据仅代表加载模型权重所需的 VRAM。运行模型还需要额外的 VRAM 用于 KV 缓存,该缓存存储对话上下文信息,其大小取决于上下文长度。

在你的设备上运行 Gemma 3

显存需求的大幅降低,使得在广泛使用的消费级硬件上运行更大、更强的模型成为可能:

- Gemma 3 27B (

int4): 现在可以轻松运行在单个拥有 24GB VRAM 的桌面级NVIDIA RTX 3090或类似显卡上,用户得以在本地运行 Google 最大的 Gemma 3 变体。 - Gemma 3 12B (

int4): 能够在拥有 8GB VRAM 的笔记本 GPU(如NVIDIA RTX 4060 Laptop GPU)上高效运行,将强大的 AI 能力带到便携设备。 - 更小模型 (4B, 1B): 为资源更受限的系统(包括部分移动设备)提供了更高的可访问性。

与主流工具轻松集成

为了方便用户在自己的工作流中使用这些模型,Google 已在 Hugging Face 和 Kaggle 上提供了官方的 int4 和 Q4_0 未量化 QAT 模型。同时,Google 与多个流行的开发者工具进行了合作,以便用户无缝试用基于 QAT 的量化检查点:

- Ollama: 通过简单命令即可快速运行,所有 Gemma 3 QAT 模型已获得原生支持。

- LM Studio: 提供用户友好的界面,可在桌面上轻松下载和运行 Gemma 3 QAT 模型。

- MLX: 利用

MLX框架在Apple Silicon上实现 Gemma 3 QAT 模型的高效、优化推理。 - Gemma.cpp: Google 提供的专用 C++ 实现,可在 CPU 上进行高效推理。

- llama.cpp: 对 GGUF 格式的 QAT 模型提供原生支持,便于集成到现有工作流。

Gemmaverse 生态中的更多量化选择

除了官方发布的 QAT 模型,活跃的 Gemmaverse 社区也提供了许多替代方案。这些方案通常采用训练后量化 (PTQ) 技术,由 Bartowski, Unsloth, GGML 等社区成员贡献,并在 Hugging Face 上提供。探索这些社区选项为用户提供了在模型大小、速度和质量之间进行权衡的更广泛选择,以满足特定需求。

即刻开始体验

将前沿的 AI 性能带到易于获取的硬件上,是推动 AI 开发民主化的关键一步。借助通过 QAT 优化的 Gemma 3 模型,用户现在可以在自己的台式机或笔记本电脑上利用尖端 AI 能力。这不仅降低了开发者和研究人员探索大型语言模型的门槛,也预示着更强大的边缘 AI 应用的潜力。

探索量化模型并开始构建:

- 在 PC 上使用

Ollama运行:https://ollama.com/library/gemma3 - 在

Hugging Face和Kaggle上查找模型: - 在移动设备上运行(通过

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/