先月の新世代オープンモデルの発表に続き ジェマ3 グーグルは最近、量子化対応トレーニング(QAT)に最適化した新バージョンを発表し、モデルのエコシステムを拡大した。 Gemma 3は以前 BF16 精度は、シングルハイエンドGPU(例えば、以下のようなもの)よりも低い。 NVIDIA H100QATバージョンは、可能な限り最高品質の出力を維持しながら、モデルのメモリ要件を大幅に削減するように設計されているため、強力なAIモデルをよりコンシューマーグレードのハードウェアで実行することができます。しかし、QATバージョンは、可能な限り最高品質の出力を維持しながら、モデルのメモリ要件を大幅に削減するように設計されているため、強力なAIモデルをよりコンシューマーグレードのハードウェアで実行することができます。

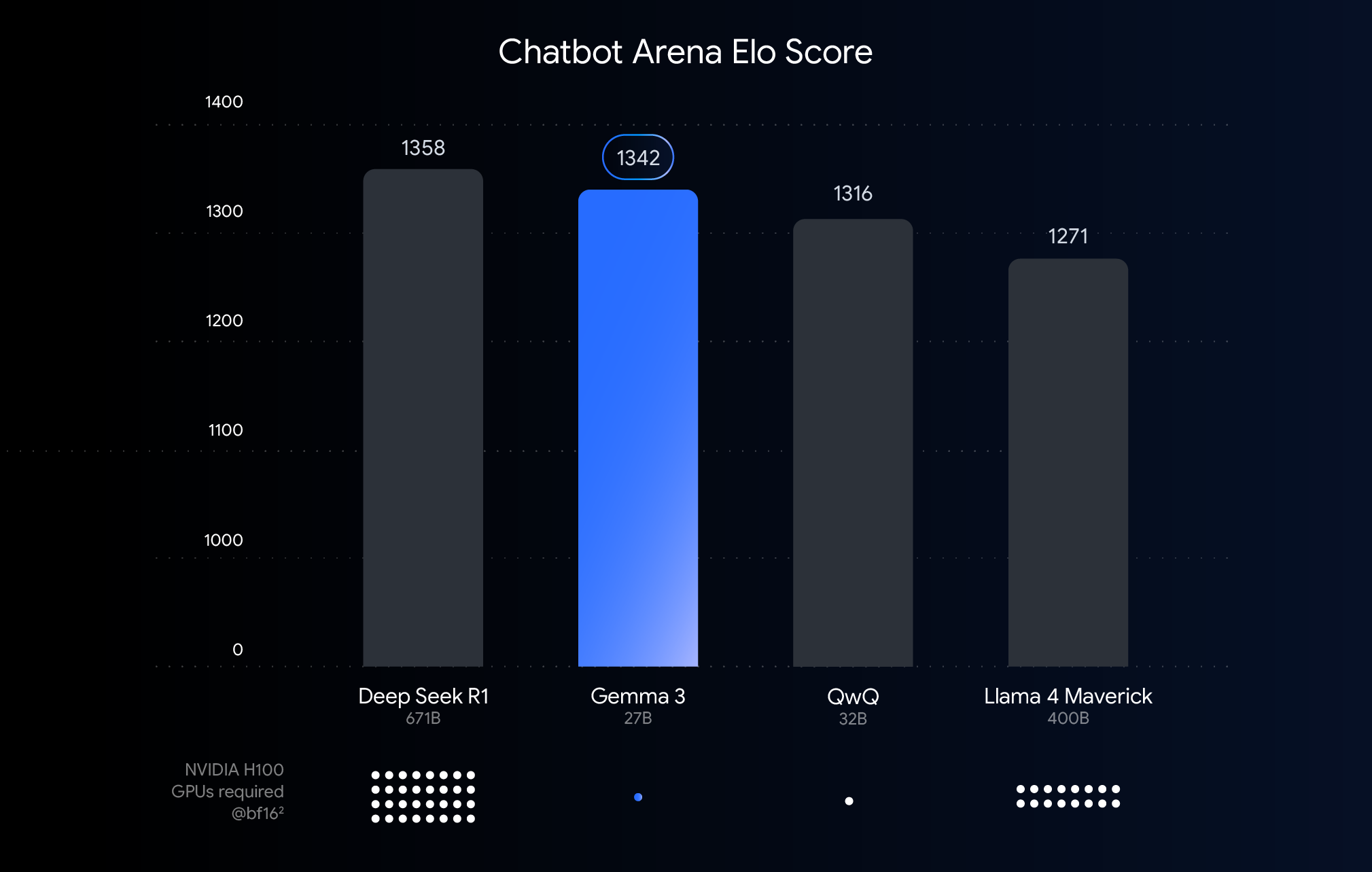

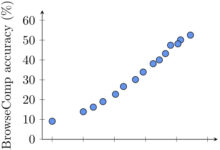

このグラフは、チャットボット・アリーナEloスコアに基づいてAIモデルをランク付けしたもので、スコアが高いほどユーザーの好みが高いことを表しています。ドットは、モデルの実行に必要なものを示しています。 NVIDIA H100 GPUの推定数。

性能、精度、定量化のしきい値を理解する

上のグラフは、最近リリースされた大規模言語モデルの性能(Eloスコア)の比較です。棒グラフが高いほど、人間の評価者による匿名での横並び比較において、モデルの性能が高いことを意味します。グラフの一番下は、Eloスコアでの性能を示しています。 BF16 データ型の下で各モデルを実行するのに必要な NVIDIA H100 GPUの見積もり番号。

オプション BF16 この比較は、多くの大規模モデル推論で一般的に使用されている数値フォーマットであり、16ビット精度で保存されたモデルパラメータを表現するためである。統一された BF16 このセットアップの下での比較は、異なるハードウェアや定量化などの最適化技術によってもたらされる変数を除いて、同じ推論構成におけるモデル自体の固有の能力を評価するのに役立つ。

注目すべきは、このチャートでは BF16 公正な比較を行うことができますが、非常に大規模なモデルを実際に展開する場合、ハードウェアへの膨大な要求(例えば、グラフィックプロセッサーの数)を減らすために、しばしば FP8 などの低精度フォーマットでは、性能と実現可能性のトレードオフが必要になる場合がある。

ハードウェアの壁を打ち破る:AIをより身近なものに

Gemma 3は、クラウド展開や研究シナリオ用のハイエンドハードウェアで優れた性能を発揮しますが、ユーザーからのフィードバックは、市場が既存のハードウェアでGemma 3の機能を活用できることを期待していることを明確に示しています。強力なAI技術の採用を促進するということは、デスクトップやラップトップ、さらにはモバイルデバイスで一般的に見られるコンシューマーグレードのGPUでモデルを効率的に実行できるようにする必要があるということです。大規模なモデルをローカルで実行することで、データのプライバシーが強化され、ネットワークの待ち時間が短縮され、オフラインアプリケーションをサポートするだけでなく、ユーザーのカスタマイズの余地が広がります。

QATテクノロジー:パフォーマンスとアクセシビリティを両立させる鍵

定量化技術は、この目標を達成するための鍵となる。AIモデリングにおいて定量化は、モデルの保存や計算で使用される数値(つまりモデル・パラメーター)の精度を下げることを目的としている。これは、画像に使用される色数を減らして画像を圧縮することに似ている。1つの数値に16ビットを使用するのに比べ(BF16)、量子化はより少ないビット数、例えば8ビット(int8)、あるいは4ビット(int4).

採用 int4 つまり、各桁はわずか4ビットで表現され、データサイズは BF16 4倍削減された。従来の定量化手法(例:学習後の定量化PTQ)は通常、モデルの学習後に実行されるため、実装は簡単だが、パフォーマンスが大幅に低下する可能性がある。Googleが使用するQAT手法は異なります。

QATでは、モデルのトレーニング中に量子化ステップを導入し、低精度演算のシミュレーションを行います。このアプローチにより、モデルはトレーニング中に低精度環境に適応することができ、その後の定量化時に精度を維持しやすくなり、より小型で高速なモデルを実現することができる。具体的には、GoogleはGemma 3モデルに約5,000ステップのQATを適用し、未量子化のチェックポイントの確率をターゲットにした。こうすることで、以下のように定量化されると主張する。 Q4_0 モデルの予測力の尺度である当惑度は、フォーマット(以下のように ラマ.cpp (評価)。

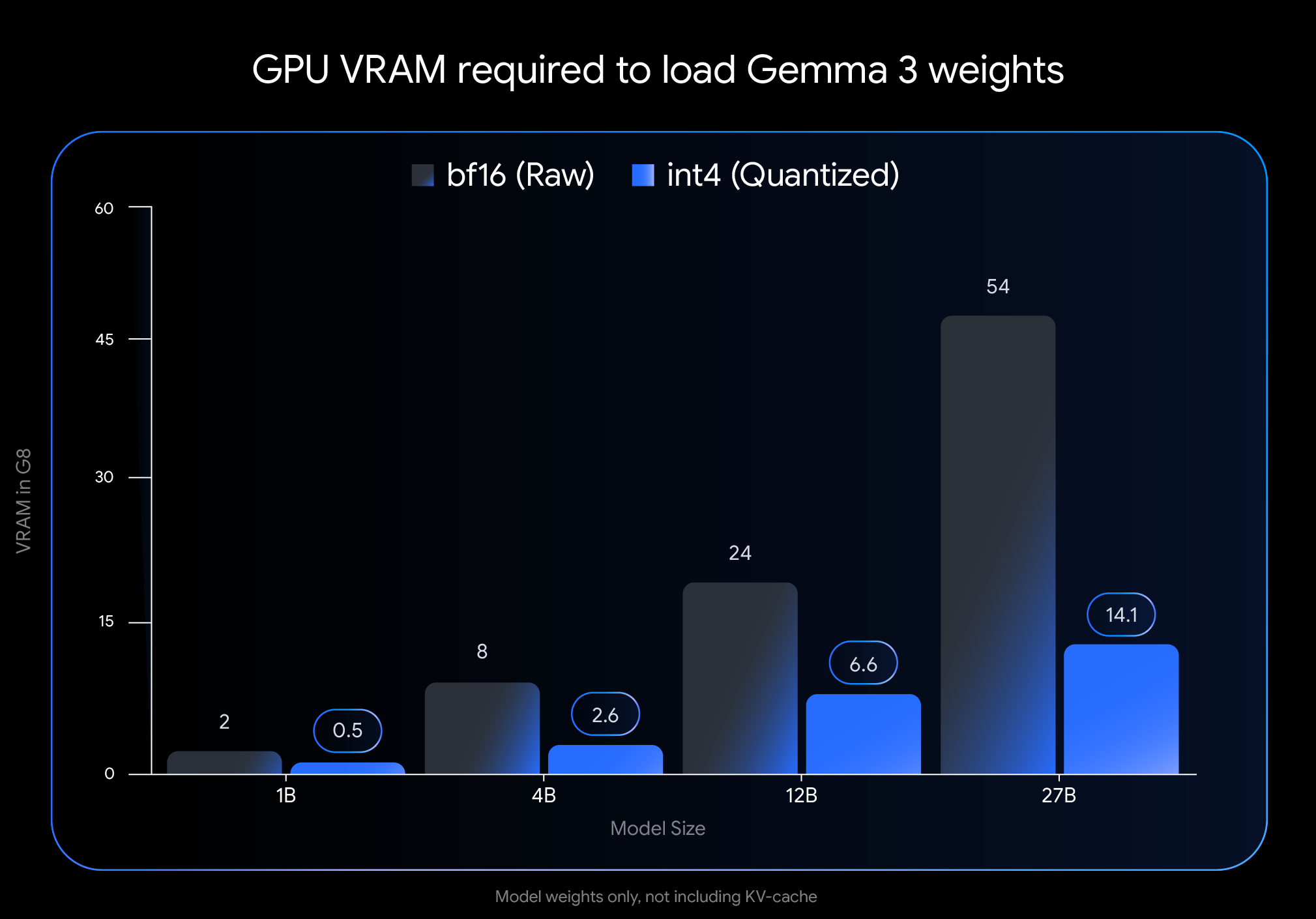

大きな効果:VRAM使用量が劇的に減少

int4 特に、モデルの重みをロードするのに必要なビデオメモリ(VRAM)の量という点で、定量化の影響は大きい:

- ジェマ 3 27B. 54GBから(

BF16に変更する。 14.1 GB (int4) - ジェマ 3 12B. 24GBから(

BF16への削減 6.6 GB (int4) - ジェマ 3 4B. 8GBから

BF16に減少した。 2.6 GB (int4) - ジェマ 3 1B 2GBから(

BF16に変更する。 0.5 GB (int4)

注意。 このデータは、モデルの重みをロードするために必要なVRAMのみを表している。モデルを実行するには、対話コンテキスト情報を格納するKVキャッシュ用のVRAMも追加で必要となり、そのサイズはコンテキストの長さに依存する。

Gemma 3をあなたのデバイスで実行してください!

必要なグラフィックスメモリが劇的に削減されたことで、広く入手可能なコンシューマーグレードのハードウェアで、より大きく、よりパワフルなモデルを実行することが可能になった:

- ジェンマ3 27B (

int4): これで、24GB VRAMのデスクトップ・クラス1台で簡単に実行できるようになった。NVIDIA RTX 3090または同様のグラフィックカードで、グーグルの最大のGemma 3バリアントをローカルで実行することができた。 - ジェンマ3 12B (

int4): のような8GBのVRAMを搭載したラップトップGPUを使用することができます。NVIDIA RTX 4060 Laptop GPU同社はまた、携帯機器に強力なAI機能をもたらす。 - 小型モデル(4B、1B)。 一部のモバイル機器を含む、よりリソースに制約のあるシステムにより高いアクセシビリティを提供する。

主流ツールとの容易な統合

ユーザーが自分のワークフローでこれらのモデルを使いやすくするために、Googleは Hugging Face 歌で応える Kaggle オフィシャル int4 歌で応える Q4_0 定量化されていないQATモデル同時にグーグルは、ユーザーがQATベースの定量化されたチェックポイントをシームレスに試すことができるよう、いくつかの人気のある開発者ツールと提携している:

- オーラマ シンプルなコマンドで素早く実行でき、Gemma 3 QATの全モデルがネイティブでサポートされている。

- LMスタジオ デスクトップ上でGemma 3 QATモデルを簡単にダウンロードし、実行するためのユーザーフレンドリーなインターフェイスを提供します。

- MLX。 用いる

MLXフレームワークはApple SiliconGemma 3 QATモデルの効率的で最適な推論 - Gemma.cpp. CPU上で効率的な推論を行うための、Googleによる専用のC++実装。

- llama.cpp。 GGUF形式のQATモデルをネイティブサポートし、既存のワークフローに容易に統合。

ゲムマバース・エコロジーの定量的選択肢を増やす

公式発表されたQATモデルに加えて、アクティブな Gemmaverse コミュニティはまた、多くの代替案を提供している。これらのスキームでは、通常、訓練後の定量化(PTQ)技術が使用される。 Bartowski, Unsloth, GGML およびその他の地域社会からの貢献、そして Hugging Face でご利用いただけます。これらのコミュニティ・オプションを探求することで、ユーザーは特定のニーズを満たすために、モデルのサイズ、スピード、品質の間のトレードオフの選択肢の幅を広げることができます。

今すぐ始めよう!

最先端のAI性能を簡単にアクセスできるハードウェアにもたらすことは、AI開発の民主化において重要なステップです。QATを通じて最適化されたGemma 3モデルにより、ユーザーは自分のデスクトップやラップトップで最先端のAI機能を活用できるようになりました。これは、開発者や研究者が大規模な言語モデルを探求するための障壁を下げるだけでなく、より強力なエッジAIアプリケーションの可能性を示すものでもあります。

定量的モデルを探求し、それを構築し始める:

- PCでの使用

Ollama走っている:https://ollama.com/library/gemma3 - ある

Hugging Face歌で応えるKaggleこのモデルを調べてみて: - モバイルデバイスで動作(via

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/