ソフトウェア開発ツールを提供するJetBrainsはこのほど、コード補完のために特別に設計された言語モデルであるMellumの基本バージョンをオープンソース化し、Hugging Faceプラットフォームで利用可能にしたと発表した。この動きは、ソフトウェア開発におけるAI分野の透明性とコラボレーションを促進することを目的としている。

Mellumの設計哲学は、全方位的な存在を目指すのではなく、コードの完成という1つのコア・タスクに焦点を当てている。 JetBrainsはこのタイプのモデルをこう呼んでいる。 専用モデル (specializedモデル)であり、広範な汎用性をやみくもに追求するのではなく、特定のドメインで深い機能を持つことを設計目標としていることを強調している。このモデルは、Java、Kotlin、Python、Go、PHP、C、C++、C#、JavaScript、TypeScript、CSS、HTML、Rust、Rubyなど、さまざまなプログラミング言語のコード補完をサポートしている。

オープンソース Mellum-4b-base は、Mellum ファミリーの最初のモデルです。 JetBrainsは将来、視差予測など、さまざまなコーディングタスクに対応する専用モデルを追加して、このファミリーを拡張する予定です。

オープンソースの背後にある考察

Mellumをオープンソースにするという決定は、軽々しく行われたものではない。 Mellumは、既存のオープンソースモデルを微調整したものではなく、同社のIDE製品にクラウドベースのコード補完機能を提供するためにJetBrainsによって一から開発され、昨年一般に公開された。

JetBrainsは、オープンソース・メラムは、透明性、コラボレーション、進歩の共有の力に対する信念に基づいていると述べている。LinuxやGitからNode.jsやDockerに至るまで、オープンソースのパラダイムは、テクノロジーの大きな飛躍の重要な原動力となってきました。すでにオープンソースのLLMがいくつかの業界リーダーを凌駕していることを考えると、AIの全体的な発展が同様の軌跡をたどる可能性は低くない。

この動きはまた、ジェットブレインズがコアテクノロジーのひとつをコミュニティに開放することを意味する。Mellum on Hugging Faceをリリースすることで、同社は研究者、教育者、上級技術チームに、特殊なモデルの内部構造を理解する機会を提供する。これは単なるツールの提供ではなく、オープンな研究とコラボレーションへの投資なのだ。

スペシャライズド・モデルとは何か?

機械学習の分野では、専門化は新しい概念ではなく、特定のタスクを効率的かつ効果的に解決するモデルを構築するという、数十年にわたってモデル設計を導いてきた中核的なアプローチである。しかし近年、AIにおける議論は、一般化されたグランドモデルですべてのタスクをカバーしようとする方向に徐々にシフトしている。

専用モデルその代わりに、特殊化の本来の目的である、特定のドメインで優れたパフォーマンスを発揮するモデルを構築することに立ち戻る。

これは「T字スキル」に例えることができる。つまり、個人は多くのトピックに関する幅広い知識(知識の幅、T字の横棒)を持っているが、特定の領域については深い専門知識(知識の深さ、T字の縦棒)を持っている。スペシャライズド・モデルも同じ哲学に従っている。すべてを扱えるように作られているのではなく、特定の領域で真に価値を発揮するために、ひとつのタスクに特化し、秀でているのだ。

Mellumはこの哲学を具現化したものだ。コード補完から始まるコード関連タスクのために設計された、比較的小型で効率的なモデルである。

このアプローチの理由は、すべての問題が汎用的な解決策を必要とするわけではなく、すべてのチームが大規模で包括的なモデルを実行するリソースや必要性を持っているわけではないからである。特殊化されたモデル(Mellumなど)には、明確な利点がある:

- ドメイン固有のタスクに精度を提供する。

- 運用と配備の面で費用対効果が高い。

- 計算の必要性とカーボンフットプリントは低い。

- 研究者、教育者、小規模チームにとって、より利用しやすい環境を提供します。

これは技術的な後退ではなく、実績のある特殊化の原理を現代のAI問題に応用したものである。 ジェットブレインズはこれを、よりスマートな前進の道と見なしている。

メルームの成績は?

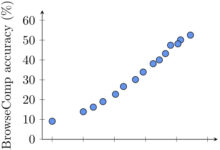

Mellumは多言語の4Bパラメトリックモデル(Mellum-4b-baseコード補完のために最適化されている。 JetBrainsは、複数のデータセットで複数の言語にわたってベンチマークを実施し、IDEで広範な手動評価を行いました。

以下は、メルエムのパフォーマンスを、より大きなパラメーター数を持ついくつかのモデルと比較したデータである(完全な詳細、結果、比較は、ハギング・フェイスのモデル・カードで見ることができる):

| モデリング | HumanEvalインフィリング(シングルライン) | HumanEvalインフィリング(複数行) | RepoBench 1.1 (2K context, py) | サフィム(平均) |

|---|---|---|---|---|

| メラム-4B-ベース | 66.2 | 38.5 | 28.2 | 38.1 |

| インコーダー6B | 69.0 | 38.6 | - | 33.8 |

| CodeLlama-7Bベース | 83.0 | 50.8 | 34.1 | 45.0 |

| CodeLlama-13Bベース | 85.6 | 56.1 | 36.2 | 52.8 |

| DeepSeek-Coder-6.7B | 80.7 | - | - | 63.4 |

注:HumanEval Infillingはコード・フィリング能力をテストし、RepoBenchは実際のコード・ベースのコンテキストでパフォーマンスを評価し、SAFIMは別のコード・コンプリーション・ベンチマーク・テストである。比較モデルには、Meta社のCodeLlamaファミリーとDeepSeek社のCoderモデルがあります。

このデータから、メルエムは、参加人数が少ないにもかかわらず、特定のベンチマークで(特にその規模を考慮に入れた場合)競争力のある性能を発揮していることがわかる。このことは、専用モデルが特定のタスクで効率的なパフォーマンスを達成できるという考え方をさらに裏付けている。パラメータ数はモデルの能力を測る唯一の尺度ではなく、タスクに特化した最適化も重要である。

メラムは誰のためにあるのか?

Hugging FaceでリリースされたMellumの現在のバージョンは、平均的なエンド開発者を主な対象としていないことを明確にすることが重要である。

このモデルには以下のグループが参加できる:

- AI/ML研究者: 特に、ソフトウェア開発におけるAIの役割を探求したり、ベンチマーキングを実施したり、モデルの解釈可能性を調査したりする学者たち。

- AI/MLエンジニアと教育者: ドメイン固有の言語モデルを構築、微調整、適応させる方法を学ぶための基礎として、あるいはLLMアーキテクチャと専門化に焦点を当てた教育プロジェクトをサポートするために使用することができる。

今すぐメルエムを体験

メルエムのベースモデルは現在、以下のモデルが用意されている。 ハグする顔 稼動開始 JetBrainsは、これは始まりに過ぎず、彼らのゴールは汎用性を目指すことではなく、焦点を絞った効率的なツールを構築することだと強調している。Mellumをベースにして探求、実験、構築したい人は、このモデルにアクセスして試すことができる。