はじめに

Local Deep Researchは、ユーザーが複雑な問題に対して深いリサーチを行い、詳細なレポートを作成することを支援するために設計されたオープンソースのAIリサーチアシスタントです。ローカルでの操作をサポートしており、ユーザーはクラウドサービスに依存することなく研究タスクを完了できる。このツールは、ローカルの大規模言語モデリング(LLM)と、学術データベース、ウィキペディア、ウェブコンテンツなどのソースをカバーするさまざまな検索機能を組み合わせています。ユーザーは簡単なインストールと設定により、引用を含む包括的なレポートを素早く作成することができる。このプロジェクトは、プライバシー保護と柔軟性を重視しており、学術研究、技術探索、個人の知識管理に適している。

機能一覧

- データのプライバシーを保護するために、ローカルの大きな言語モデルをサポートしています。

- Wikipedia、arXiv、PubMedなどの適切な検索ツールを自動的に選択。

- 構造化されたセクションと引用を含む詳細なレポートを作成。

- 数秒で簡潔な回答を生成するクイックサマリー機能を提供。

- 包括的な分析のためのウェブ検索と組み合わせたローカル文書検索をサポートします。

- ウェブインターフェースとコマンドラインインターフェースを備え、柔軟な操作が可能。

- グローバルユーザーのための多言語検索に対応。

ヘルプの使用

設置プロセス

Local Deep Researchには、Python環境と関連する依存関係のインストールが必要です。以下は、詳細なインストール手順です:

- クローン倉庫

ターミナルで以下のコマンドを実行し、プロジェクトをローカルにクローンする:git clone https://github.com/LearningCircuit/local-deep-research.git cd local-deep-research

- 依存関係のインストール

Pythonのパッケージ管理ツールを使って必要なライブラリをインストールする:pip install -e .ブラウザの自動化機能が必要なら、Playwrightをインストールしよう:

playwright install - 現地モデルの設置(Ollama)

ローカル・ディープ・リサーチは、以下の採用をサポートする。 オーラマ ローカルの大規模言語モデルを実行する。https://ollama.ai、Ollamaをダウンロードしてインストールし、レコメンデーション・モデルを引き出す:ollama pull gemma3:12bOllamaサービスがバックグラウンドで実行されていることを確認する。

- SearXNGの設定(オプション)

最良の検索結果を得るためには、SearXNG検索サービスをセルフホストすることをお勧めします。以下のコマンドを実行して SearXNG を起動します:docker pull searxng/searxng docker run -d -p 8080:8080 --name searxng searxng/searxngプロジェクトのルート・ディレクトリにある

.envファイルを使用して SearXNG アドレスを設定します:SEARXNG_INSTANCE=http://localhost:8080 SEARXNG_DELAY=2.0 - スターターキット

- ウェブインタフェース次のコマンドを実行してウェブ版を起動し、http://127.0.0.1:5000:

ldr-web - コマンドラインインタフェース次のコマンドを実行すると、コマンドライン版が起動します:

ldr

- ウェブインタフェース次のコマンドを実行してウェブ版を起動し、http://127.0.0.1:5000:

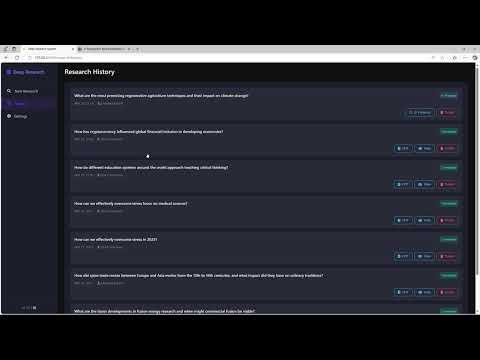

主な機能の操作

1.簡単な要約の作成

クイック・サマリー機能は、迅速な回答が必要なユーザーのためのものです。ウェブ・インターフェースを開き、「核融合エネルギーにおける最近の進歩」のような研究上の質問を入力します。Quick Summary "ボタンをクリックすると、数秒後に重要な情報と出典を含む簡単な回答が表示されます。コマンドラインを使用する場合は、それを実行します:

from local_deep_research import quick_summary

results = quick_summary(query="核聚变能源的最新进展", search_tool="auto", iterations=1, questions_per_iteration=2, max_results=30)

print(results["summary"])

結果は、簡単な要約と参照リンクが付いたテキストとして出力される。

2.詳細レポートの作成

詳細レポート機能は、包括的な分析を必要とするユーザーに適しています。ウェブ・インターフェースで質問を入力した後、「レポート作成」オプションを選択します。このツールは、検索と分析を複数回実行し、目次、章、引用を含むレポートをMarkdown形式で生成します。レポート生成時間は、問題の複雑さと検索ラウンド数(デフォルトでは2)に依存します。コマンドラインの操作例

from local_deep_research import generate_report

report = generate_report(query="核聚变能源的最新进展", search_tool="auto", iterations=2)

print(report)

生成されたレポートはローカルに保存され、通常はプロジェクト・ルート・ディレクトリのパス examples フォルダー

3.ローカル文書検索

ユーザーはプライベート文書(PDF、TXTなど)を指定したフォルダにアップロードし、RAG(Retrieval Augmented Generation)機能で分析することができます。ドキュメントのパスを設定します:

DOC_PATH=/path/to/your/documents

ウェブ・インターフェースでレポート・ソースとして「ローカル・ドキュメント」を選択すると、ツールはローカル・ドキュメントとウェブ検索を組み合わせたレポートを生成する。コマンドライン操作:

results = quick_summary(query="分析我的文档中的AI趋势", report_source="local")

4.多言語検索

このツールは、英語以外の質問の多言語検索をサポートしています。ウェブ・インターフェイスに中国語または他の言語で質問を入力すると、ツールは自動的に検索ツールを適応させ、関連する結果を返す。例えば、"latest breakthroughs in quantum computing"(量子コンピューターにおける最新のブレークスルー)と入力すると、ツールは中国語と英語の両方のソースを検索する。

設定パラメータ

ユーザーは config.py もしかしたら .env このファイルはパラメーターを調整する:

search_tool検索ツールの選択(デフォルト)auto).iterationsスタディ・ラウンドの数を設定する(デフォルトは 2)。max_results検索結果の最大数(デフォルト50)。max_filtered_resultsフィルタリングされた結果の数(デフォルトは5)。

ほら

- 外部リソースを検索するために、安定したインターネット接続を確保する。

- ローカルモデルの性能はハードウェアに依存するため、GPUアクセラレーションを推奨する。

- Ollamaとプロジェクトのコードを定期的に更新し、最新の機能を追加する。

アプリケーションシナリオ

- 学術研究

学生や研究者は、Local Deep Researchを使って学術論文やウェブページから情報を素早く収集し、引用レポートを作成することができます。例えば、「Breakthroughs in Quantum Computing(量子コンピューティングのブレークスルー)」を研究する場合、このツールはarXivとPubMedから最新の論文を取得し、構造化されたレポートを生成します。 - 技術探究

技術愛好家は、「サプライチェーンにおけるブロックチェーン」などの新たな技術動向を探ることができます。このツールは、現地のドキュメントとウェブ検索を組み合わせて、包括的な分析を提供します。 - 個人の知識管理

ユーザーは、個人的なメモや文書をアップロードして、外部情報とともに自分の知識ベースを整理することができる。例えば、「AI開発予測2025」に関する個人的なレポートなど。

品質保証

- ローカル・ディープ・リサーチにはネットワークが必要か?

ローカルモデルはインターネット接続なしで動作するが、検索機能(例:Wikipedia、arXiv)はインターネット接続を必要とする。ユーザーはローカルドキュメントのみを使用することもできます。 - どのような大きな言語モデルに対応していますか?

Ollama がホストするモデルは、デフォルトで次のようにサポートされています。gemma3:12b.ユーザーはconfig.py以下のような他のモデルを設定する。 ブイエルエルエム またはLMStudio。 - 報道の質はどうすれば向上するのか?

検索回数を増やすiterations)と結果数(max_results)、またはより強力なモデルを使用する。問題を明確に記述することも、精度の向上に役立つ。 - Windowsシステムはサポートされていますか?

はい、このプロジェクトは設定プロセスを簡素化するために、Windowsワンクリックインストーラーを提供しています。ダウンロードするにはGitHubリポジトリをご覧ください。