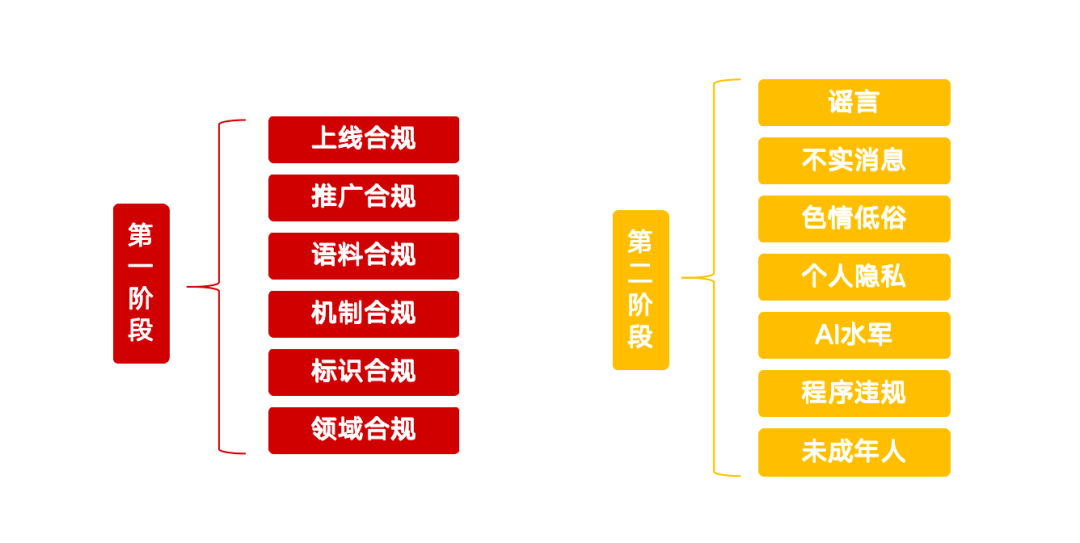

最近、インターネット情報技術中央弁公室は、「明確-AI技術の乱用を是正する」という特別行動を開始し、現在の人工知能の発展で生じている多くの問題のガバナンスに明確なレッドラインを引いた。このイニシアチブは、AI技術の健全な発展を導き、潜在的なリスクを防止することを目的としている。この特別行動は13の重要な方向性に焦点を当て、2つのフェーズに分けられ、AI製品、サービス、コンテンツ、行動規範に関する詳細な要件が定められている。

フェーズI:ソース・ガバナンスとインフラ

アクションの第一段階は、AI技術のソース管理に重点を置き、問題のあるAIアプリケーションのクリーンアップ、コンテンツラベリング管理の強化、プラットフォームの偽造品検出・識別能力の向上を目指す。

非準拠のAI製品はオンライン・コンプライアンスを完了する必要がある

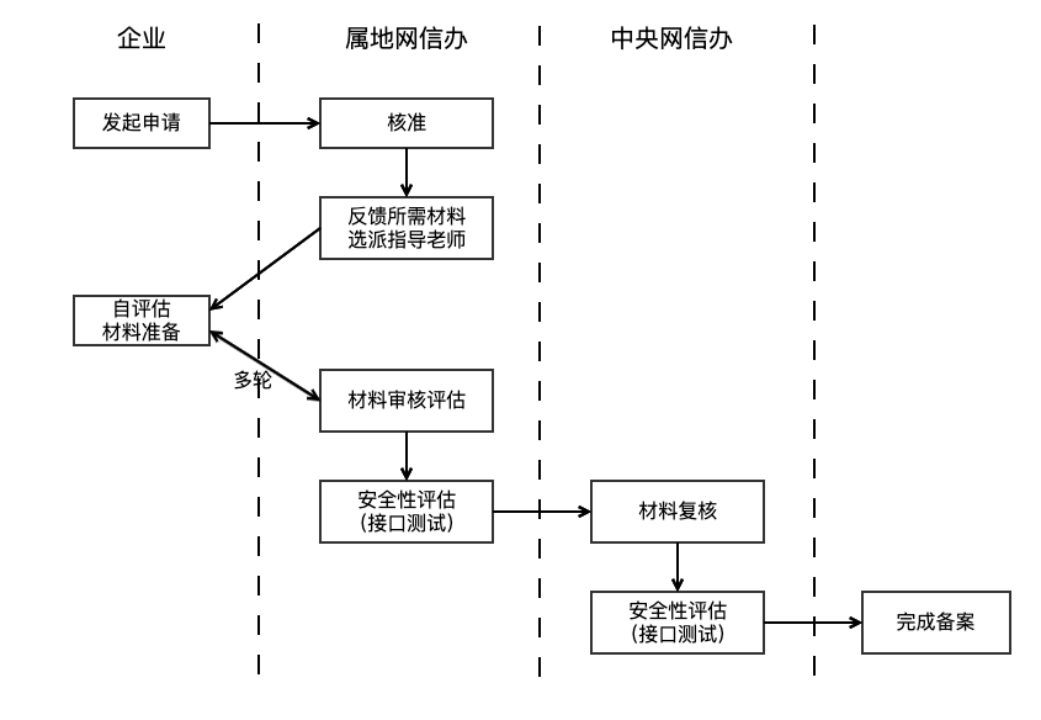

規制当局は、ジェネレーティブAI技術を使用して公衆にサービスを提供するアプリケーションは、大型モデルの申請または登録プロセスを満たさなければならないと指摘した。この要件は、「ジェネレーティブ人工知能サービス管理暫定弁法」(以下、暫定弁法)の第17条に基づいており、AI製品が正式に発売される前に安全性評価に合格する必要があることを明確にしている。申請サイクルには通常3〜6ヶ月かかると予想される。また、「ワンクリック脱衣」のような違法かつ非倫理的な機能を提供したり、他人の生体特徴(声や顔など)を無断でクローン化したり編集したりすることは法律違反となる。

未登録のAIサービスを特定し、規制することが課題となっている。規制当局は、ウェブクローラなどの技術的手段を用いて、サービスがビッグモデルのAPIインターフェース(対話生成、画像合成など)を呼び出しているかどうかや、その技術的特徴を特定することで、様々なプラットフォームを監視することができる。機能設計のコンプライアンスについては、企業の内部法的評価やアプリショップの監査に加えて、インフォーマルチャンネルサービスの規制は現在、ユーザーからの苦情報告により依存している。サービス提供者は、AI製品が二重申請(大型モデルの申請とアルゴリズムの申請)を完了しているかどうかを自己チェックし、機能設計が仕様に準拠していることを確認すべきである。

コンプライアンスの推進:違法なAI製品のチュートリアルと商品を取り締まる

また、今回の特別措置では、AI製品のプロモーションにも焦点が当てられている。非準拠のAI製品を使って顔を変える動画や声を変える動画を作成することを教えるチュートリアル、「音声合成ツール」や「顔を変えるツール」などの非準拠製品の販売、非準拠のAI製品のマーケティングやプロモーションは、すべて是正措置に含まれる。プロモーターは、AI製品の販売促進を選択する前に、その製品のコンプライアンスを確認する責任がある。プラットフォームはコンテンツ監査を強化する必要があり、コンテンツそのものが合法であることを保証するだけでなく、例えばセマンティックモデルの初期スクリーニングや手動介入による補完を通じて、コンテンツ内で宣伝されるAI製品のコンプライアンスを特定し、監査する能力を持つ必要がある。

コーパス・コンプライアンス:トレーニングのデータソースと管理に注目

学習データのコンプライアンスは、AIモデルのセキュリティの基礎である。暫定措置の第7条では、サービス提供者は正規のソースからのデータと基礎モデルを使用することが強調されている。生成AIサービスの安全性に関する基本要求事項(以下、基本要求事項)はさらに洗練され、コーパスに5%以上の違法で望ましくない情報が含まれている場合、そのソースを採取すべきではないと規定されている。同時に、データソースの多様性、従うべきオープンソースプロトコル、自己採取データの記録、商用データ調達の法的手続きなどが明確に定義されている。

データのプライバシーや技術的な機密性のため、トレーニング・コーパスの規制は非常に難しく、通常は質問と資料による証明という形をとる。また、企業は、複雑なソースと様々な品質を持つ大量のトレーニングデータを管理する上で、大きな課題に直面している。基本要件では、企業はキーワードフィルタリング、分類モデルスクリーニング、手動サンプリングを組み合わせて、コーパス内の違法で望ましくない情報を一掃することを推奨しています。

メカニズムへの準拠:安全管理措置の強化

企業は、コンテンツ監査や意図認識など、事業規模に見合ったセキュリティの仕組みを確立するとともに、違反アカウントに対する効果的な管理プロセスや、定期的なセキュリティ自己評価システムを構築する必要がある。APIインターフェイスを通じてアクセスするAI自動返信などのサービスについては、ソーシャルプラットフォームは心して厳格に対応する必要がある。基本要件第7章では、サービス提供者に対し、ユーザーの入力を監視し、不正な入力を繰り返すユーザーにはサービスを制限するなどの措置をとることを求めている。また、コンテンツの質と安全性を向上させるため、サービス規模に見合った監督スタッフを配置し、ポリシーの追跡や苦情の分析にあたるべきである。健全なリスクコントロールの仕組みは、AI製品の発売の前提条件である。

ラベリング・コンプライアンス:AIが生成したコンテンツに対するラベリング要件の実装

透明性を高めるため、「人工知能が生成した合成コンテンツのマーク付けに関する措置」(以下、マーク付け措置)では、サービスプロバイダは、深く合成されたコンテンツに明示的または暗黙的なマークを追加し、明示的なマークはファイルに含まれ、暗黙的なマークはユーザがファイルをダウンロードまたはコピーする際にメタデータに追加されるようにすることが求められると規定している。このアプローチは、2025年9月1日以降に施行される国家標準「ネットワークセキュリティ技術人工知能生成合成コンテンツ識別方法」を伴っている。企業はこれに基づいてセルフチェックを行い、プラットフォーム上でAIが生成したコンテンツを検出する技術的手段を導入し、疑わしいコンテンツに対してアラートを提供することが求められる。また、規制当局は、AIが生成したコンテンツの社会的認知を向上させるため、ユーザー教育を強化する可能性がある。

ドメイン・コンプライアンス:主要産業のセキュリティリスクに注目

医療、金融、未成年者などの主要分野でQ&Aサービスを提供するために申請されたAI製品は、業界固有のセキュリティ監査と管理措置を設定しなければならない。AI処方」、投資誘導、あるいは「AI錯覚」を利用してユーザーを惑わす現象を防止する。これらの特定分野におけるコンプライアンス・ガバナンスは複雑かつ細分化されており、ドメイン専門家の知識と専門的なコンプライアンス・コーパスが必要となる。業界規制当局とヘッドライン企業は、基準を設定し、セキュリティ対策を確実に実施する上で重要な役割を果たす。一般的なソリューションとしては、ファントム検知、重要な操作の手動承認などがあり、AIがコントロールを失うリスクから守っている。

第2段階:違法・不法行為へのAIの利用を取り締まる

特別措置の第2段階は、噂、不正確な情報、ポルノ、低俗なコンテンツを作成・流布し、他人になりすましてサイバースクワッド活動に従事するためにAI技術を使用することに焦点を当てる。

AIを使った噂の作成と公表への対策

是正の範囲には、時事問題や人々の生活に関連する噂を空から捏造すること、政策を悪意を持って解釈すること、緊急事態を根拠に詳細を捏造すること、公式の情報発表を装うこと、さらにはAIの認知バイアスを利用した悪意ある誘導などが含まれる。中国のインターネット共同風評払拭プラットフォームは長い間運用されてきたが、AIの時代には、風評作成のコストが削減され、忠実度が増したことで、新たなガバナンスの課題となっている。規制は主に世論監視とユーザーからの通報に依存しており、主要分野におけるAIの噂に対する罰則が強化される可能性がある。サービス・プロバイダーは、AIツールを使ってコンテンツの精度を校正したり、異常なアカウント行動を監視したり、ホットスポットのコンテンツを手動でスポットチェックするなど、AIが生成した噂を検出する能力を向上させる必要がある。

AIを使用して不正確な情報を作成し、公表することを一掃する。

このような行為には、無関係な画像や動画をつなぎ合わせて編集し、混在した情報を生成すること、事実の要素をぼかして変更すること、古いニュースを蒸し返すこと、専門分野に関連する誇張された内容や疑似科学的な内容を公表すること、AI占いや占いの助けを借りて迷信を広めること、などが含まれる。噂に比べれば、不正確な情報は主観的で悪質ではないかもしれないが、その隠された性質と潜在的な影響は無視できない。ガバナンスは主に、コンテンツ・プラットフォームがエコロジー構築を強化し、技術的手段によって低品質コンテンツを特定し、関連コンテンツやクリエイターの拡散を制限したり、罰則を科したりする措置を講じることに依存している。

ポルノや下品なコンテンツを制作・配信するためにAIを使用することの是正

AIの「ワンクリック脱衣」や「AIお絵かき」など、AIを利用してポルノやわいせつな画像・動画を生成したり、ソフトポルノ、第二世代ポルノ画像、流血暴力、グロテスク・グロテスクな画像、「小さな黄色い文字」などを制作したりすることは、すべて取り締まりの対象となる。AI技術はコンテンツ制作の効率を向上させる一方で、こうした好ましくないコンテンツの制作に悪用される可能性もある。キーワード・ライブラリ、セマンティック・モデル、画像分類(「ポルノ識別モデル」)といった従来の審査手法は、ユーザー生成コンテンツ(UGC)の識別には比較的成熟している。しかし、AIが生成したコンテンツの特徴分布は、UGCのそれとは異なる可能性があり、サービス・プロバイダーは、識別精度を維持するために、モデルの学習データの更新に注意を払う必要がある。

他者になりすまして侵害行為を行うためにAIを使用した場合の調査と対処

AIのフェイススワップ、ボイスクローン、その他の綿密な偽造技術によって公人になりすまし、欺瞞や利益のために、公人や歴史上の人物になりすまして信用を失墜させる行為、AIを使って友人や親族になりすまして詐欺を働く行為、さらにはAIの不適切な使用による「死者の復活」や死者の情報の悪用など、すべての行為が是正の焦点となっている。こうしたリスクは、個人のプライバシー情報の漏洩や悪用に起因する。プライバシー保護に対する国民の意識を高め、長期的にはデータのトレーサビリティ・メカニズムを確立し、チェーン全体を通じてデータのコンプライアンスを確保することが重要である。

サイバー傭兵活動にAIを利用することへの対策

「AI水軍」とは、ネットワーク水軍の新たな亜種である。AI技術を使ってソーシャルアカウントの一括登録・運用を「上げる」、AIコンテンツファームやAI原稿洗浄を使って低品質な均質化コンテンツを一括生成して流れをブラッシュアップする、さらにAI集団制御ソフトやソーシャルロボットを使って制御量や評価量をブラッシュアップするなどの行動が厳しく取り締まられることになる。ガバナンスは、コンテンツとアカウントという2つの次元から出発し、プラットフォーム内の低品質コンテンツやAIGCコンテンツを検出し、AIGCコンテンツを公開するアカウントの行動特性を監視し、迅速な介入を自動化することで、水軍の弊害のコストを高める必要がある。

AI製品サービスとアプリケーションの行動を規制する

模倣品・シェルAIウェブサイトやアプリケーションの制作・普及、AIアプリケーションによるコンプライアンス違反機能の提供(オーサリングツールによる「ホット検索・ホットリスト展開」の提供など)、AIソーシャルチャットソフトによる低俗・ソフトポルノ的な対話サービスの提供、AI製品の利用を逸脱させるコンプライアンス違反のAIアプリケーション・サービス・講座の販売・宣伝などは、すべて是正の対象となる。これにより、AI製品の発売と普及のコンプライアンスが再度強調され、「シェル」と違法機能の定義が追加された。サービス・プロバイダーは、人々にサービスを提供するというテクノロジーの本来の目的を守るべきである。

AIに対する未成年者の権利と利益の保護

AIモデルは確率統計に基づいており、生成されるコンテンツには予測不可能性があるため、誤った値を出力し、未成年者の成長に潜在的なリスクをもたらす可能性がある。したがって、未成年者の教育シナリオにAIを適用する場合は、特に注意し、シナリオの利用を厳格に管理する必要がある。その他、未成年者の接触頻度が高い製品については、未成年者モードを強化し、AIの適用権を制限すべきである。