はじめに

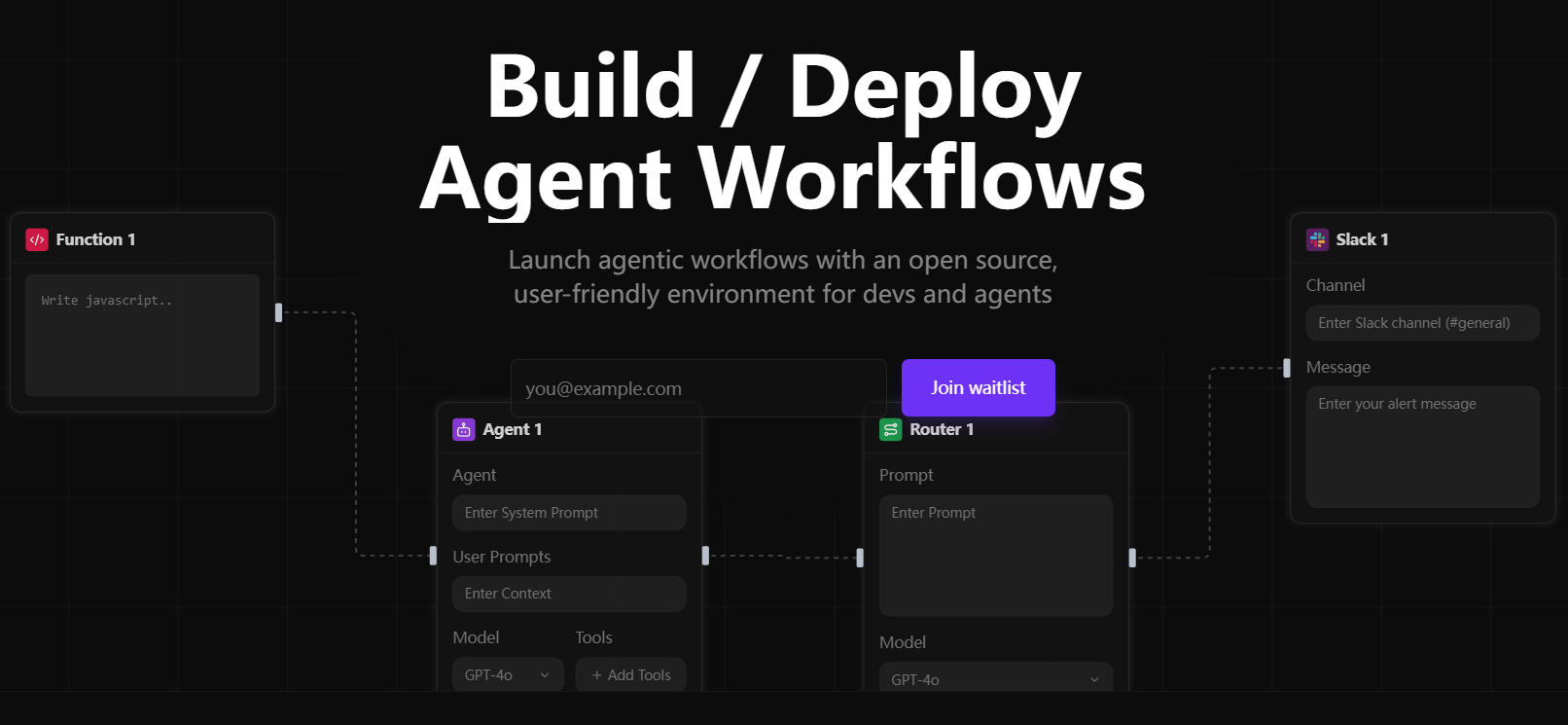

Sim StudioはオープンソースのAIエージェントワークフロー構築プラットフォームで、軽量で直感的なビジュアルインターフェースを通じて、大規模言語モデル(LLM)ワークフローの迅速な設計、テスト、デプロイを支援します。ユーザーは、深いプログラミングをすることなく、ドラッグ&ドロップで複雑なマルチエージェントアプリケーションを作成することができます。ローカルとクラウドの両方のモデルをサポートし、Slackやデータベースなどの幅広いツールとの互換性があります。公式のクラウドホスト版(https://simstudio.ai)とセルフホストオプションがあり、さまざまなニーズに対応できます。

昨今、AIエージェントフレームワークが花盛りですが、特にSim Studioをお勧めする理由は何でしょうか?現在公開されている主要なオープンソースのAIエージェントフレームワークの特徴をまとめてみました:

| フレームワーク名 | コアパラダイム | 主なメリット | 適用シナリオ |

|---|---|---|---|

| ラングラフ | グラフベースのプロンプトワークフロー | 明示的なDAG制御、分岐、デバッグ | 複雑な複数ステップのタスク、高度なエラー処理 |

| OpenAIエージェントSDK | OpenAIアドバンスツールチェーン | ウェブ検索やファイル検索などのツールの統合 | OpenAIのエコシステムに依存しているチーム |

| スモラージェンツ | コード中心の最小エージェント・ループ | 簡単なセットアップ、直接コード実行 | 複雑な振り付けを必要としないタスクの迅速な自動化 |

| クルーAI | マルチエージェントコラボレーション(クルー) | 共有メモリによる役割ベースの並列ワークフロー | 複数の専門家の協力を必要とする複雑なタスク |

| オートジェン | 非同期マルチエージェントチャット | リアルタイム対話、イベントドリブン | リアルタイムのコンカレントおよびマルチLM「音声」インタラクションを必要とするシナリオ |

| シム・スタジオ | ビジュアルワークフロービルダー | 直感的なインターフェイス、迅速な展開、オープンソースの柔軟性 | 迅速なプロトタイピングと本番環境の展開 |

現在、市場にはローコード/ノーコードのAIエージェント構築プラットフォームが数多くありますが、Sim Studioと比較してどうなのかを一覧にしてみました:

| テラス | 特性 | 適用シナリオ | 物価 |

|---|---|---|---|

| バーテックスAIビルダー | 複雑なAPIを備えたエンタープライズクラスのコード不要プラットフォーム | 大企業のワークフロー自動化 | コストをカバーする |

| ビームAI | 複数のオンプレミス・エージェントをサポートする水平プラットフォーム | 複数分野にわたる自動化(コンプライアンス、カスタマーサービスなど) | コストをカバーする |

| マイクロソフトコパイロットスタジオ | 低コード、1200以上のデータコネクタ | 社内チャットボット, 受注管理 | コストをカバーする |

| Lyzrエージェントスタジオ | モジュール式でプロトタイピングに最適 | 財務、人事オートメーション | コストをカバーする |

| シム・スタジオ | オープンソース、ビジュアルインターフェース、柔軟なデプロイメント | プロトタイプから生産までの全工程 | フリー・オープンソース |

お分かりのように、オープンソースプロジェクトであるSim Studioは、機能性や柔軟性において決して劣るものではなく、それを使うことに金銭的なプレッシャーもない。

機能一覧

- ビジュアルワークフローエディター AIエージェントのワークフローは、条件ロジックやマルチステップタスクをサポートするドラッグ&ドロップのインターフェースで設計できます。

- マルチモデル対応 クラウドLLMとローカルLLM(Ollamaで実行されるローカルモデルなど)に対応。

- ツール統合 Slack、データベース、拡張プロキシ機能などの外部ツールへの接続をサポート。

- APIの展開 ワークフローAPIをワンクリックで生成し、他のシステムに簡単に統合できます。

- ローカル展開 プライバシーに配慮したシナリオのために、Dockerまたは手動によるセルフホスティングをサポートします。

- モジュラー・エクステンション ファンクションブロックやツールのカスタマイズを可能にし、柔軟性を向上。

- ロギングとデバッグ ワークフローの最適化とエラーのトラブルシューティングのために詳細なログを提供します。

- 開発コンテナ・サポート VS Code開発コンテナでローカル開発環境のセットアップを簡素化。

ヘルプの使用

Sim Studioの中核は、軽量で直感的なワークフロー構築機能です。以下では、ユーザーがすぐに使い始められるように、インストール手順、主な機能の操作方法、特殊機能の使用方法について詳しく説明します。

設置プロセス

Sim Studioには、Docker(推奨)、開発用コンテナ、手動インストールの3つのセルフホスティングオプションがあります。以下は主にDockerと手動インストールで、開発コンテナはVS Codeに慣れている開発者に適しています。

方法1:Dockerのインストール(推奨)

Dockerは、ほとんどのユーザーに適した一貫した実行環境を提供する。DockerとDocker Composeを最初にインストールする必要がある。

- コードベースのクローン

ターミナルで実行:git clone https://github.com/simstudioai/sim.git cd sim

- 環境変数の設定

環境ファイルをコピーして編集する:cp sim/.env.example sim/.env

.envファイルで設定されている:

- BETTER_AUTH_SECRET: 認証用のランダムキーを生成する。

- RESEND_API_KEY: メールボックスの検証に使用されます。設定されていない場合、検証コードはコンソールに出力されます。

- データベースの設定:デフォルトではPostgreSQLが使用されています。

- OLLAMA_HOST: ローカルモデルを使用する場合はhttp://host.docker.internal:11434。

- サービス開始

以下のコマンドを実行する:docker compose up -d --build

またはスクリプトを使用する:

./start_simstudio_docker.sh

サービスが開始したら、http://localhost:3000/w/ にアクセスしてワークフローインターフェースにアクセスする。

- マネジメントサービス

- ログを見る

docker compose logs -f simstudio

- サービスの中止:

docker compose down

- サービスを再起動する(コード更新後):

docker compose up -d --build

- ログを見る

- ローカルモデルの使用

ローカルLLMが必要な場合は(LLaMAなど)、モデルを引き上げる:./sim/scripts/ollama_docker.sh pull <model_name>

地域モデルをサポートするサービスを開始する:

./start_simstudio_docker.sh --local

またはハードウェアに応じて選択する:

# 有 NVIDIA GPU docker compose up --profile local-gpu -d --build # 无 GPU docker compose up --profile local-cpu -d --build

すでにOllamaインスタンスがある場合は、docker-compose.ymlを修正して追加する:

extra_hosts: - "host.docker.internal:host-gateway" environment: - OLLAMA_HOST=http://host.docker.internal:11434

モード2:手動設置

Node.js、npm、PostgreSQLがインストールされたカスタム環境が必要な開発者向け。

- 依存関係のクローンとインストール

git clone https://github.com/simstudioai/sim.git cd sim/sim npm install

- 設定環境

環境ファイルをコピーして編集する:cp .env.example .env

BETTER_AUTH_SECRET、データベース接続などを設定する。

- データベースの初期化

データベース・アーキテクチャをプッシュする:npx drizzle-kit push

- 開発サーバーの起動

npm run dev

http://localhost:3000。

アプローチ3:コンテナの開発

- VS CodeにRemote - Containersエクステンションをインストールします。

- プロジェクト・ディレクトリを開き、"Reopen in Container "をクリックする。

- npm run devまたはsim-startを実行してサービスを開始する。

主な機能

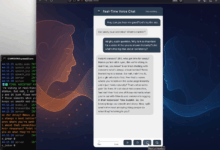

Sim Studioの中核をなすのは、以下に説明するビジュアルワークフローエディターです:

ワークフローの作成

- Sim Studio (http://localhost:3000/w/)にログインします。

- New Workflow "をクリックし、エディターに入ります。

- エージェントノードをドラッグ&ドロップし、LLM(クラウドまたはローカルモデル)を選択します。

- Toolsノード(SlackやDatabaseなど)を追加し、パラメータを設定します。

- Conditional Logic ノードを使用して分岐ロジックを設定します。

- ノードを接続し、ワークフローを保存します。

テスト・ワークフロー

- Test "をクリックし、例のデータを入力する。

- ノードの実行を確認するための出力とログを表示します。

- 必要に応じてノードまたはロジックを調整し、再試験を行う。

展開ワークフロー

- Deployをクリックし、Generate APIを選択する。

- APIエンドポイント(例:http://localhost:3000/api/workflow/)を取得する。

- APIをテストする:

curl -X POST http://localhost:3000/api/workflow/<id> -d '{"input": "示例数据"}'

デバッグ・ワークフロー

- エディタで "Log "を見て、ノードの入出力をチェックする。

- バージョン管理を使ってワークフローのスナップショットを保存し、簡単にロールバックできるようにする。

注目の機能操作

- 現地モデルのサポート Ollama を通してローカルモデルを実行することは、プライバシーに配慮したシナリオに適しています。設定後、エージェントノードでモデルを選択し、パフォーマンスをテストします。

- ツール統合 Slackを例にとって、ツールノードにAPIトークンを入力し、メッセージターゲットを設定し、メッセージ送信機能をテストする。

- 開発コンテナ VS Codeによるコンテナ化された開発、迅速な反復のための自動環境設定。

ほら

- Dockerのインストールでは、ポート3000が占有されていないことを確認する必要がある。

- ローカルモデルでは、高いハードウェア構成が必要です(16GB RAM推奨、GPUはオプション)。

- 本番環境では、RESEND_API_KEY と HTTPS を設定する必要があります。

- 定期的にコードを更新する:

git pull origin main docker compose up -d --build

テクノロジースタック

Sim Studioは、パフォーマンスと開発効率を確保するために最新の技術スタックを使用しています:

- 図案 :Next.js(アプリルーター)

- 総合データベース : PostgreSQL + Drizzle ORM

- 認定 より良い認証

- インターフェース シャドック、テイルウィンドCSS

- ステータス管理 : Zustand

- プロセス・エディター ReactFlow

- (さんぷ フマドックス

アプリケーションシナリオ

- 自動化されたカスタマーサービス

マルチエージェントワークフローを設計し、データベースとSlackを統合し、顧客の質問に対する回答を自動化し、人間のカスタマーサービスに通知します。 - データ分析

データベースからデータを抽出するワークフローを構築し、LLMを呼び出してレポートを生成し、財務分析に適したAPIとしてデプロイする。 - 教育ツール

インタラクティブな学習エージェントを作成し、ローカルモデルを組み合わせて質問に答え、オンライン教育のためのテスト問題生成ツールを統合する。

品質保証

- Sim StudioはWindowsをサポートしていますか?

Windowsにも対応していますが、Docker DesktopまたはNode.jsが必要です。一貫した環境を確保するために、Dockerのアプローチを推奨します。 - 既存のOllamaインスタンスに接続するには?

docker-compose.yml を修正し、host.docker.internal マッピングを追加し、OLLAMA_HOST を設定します。 - ローカルモデルに必要なハードウェアは?

16GBのRAMを推奨、パフォーマンス向上のためGPUを搭載、低スペックのデバイスでは動作が遅くなる可能性があります。 - コードを提供するには?

https://github.com/simstudioai/sim/blob/main/.github/CONTRIBUTING.md。