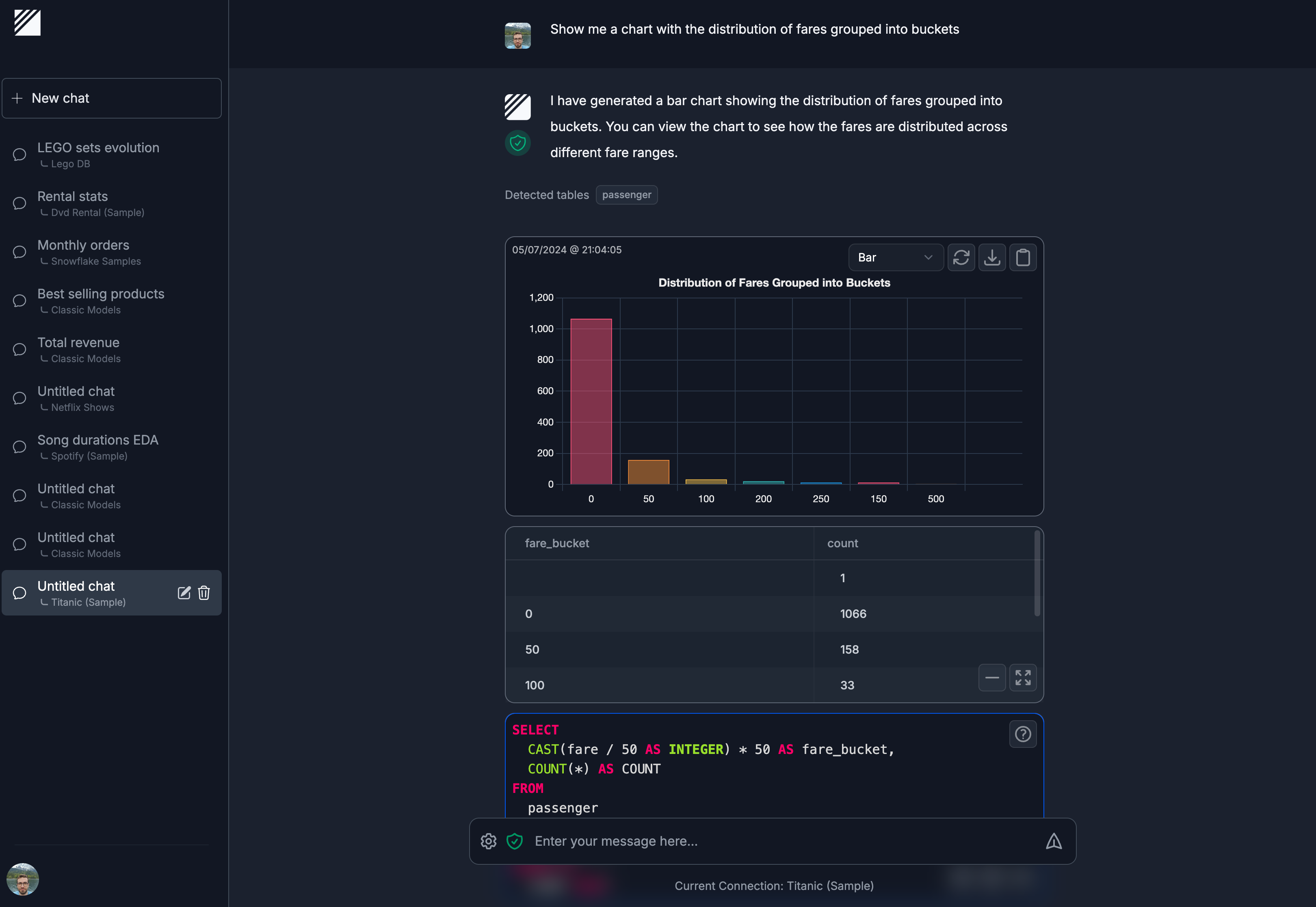

Step1X-Edit:自然言語指示による画像編集のためのオープンソースツール

はじめに

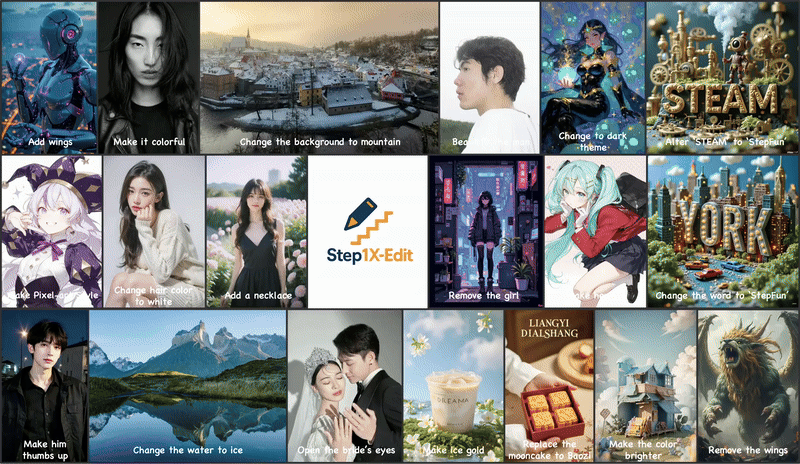

Step1X-Editは、Stepfun AIチームによって開発され、GitHubでホストされているオープンソースの画像編集フレームワークです。マルチモーダル大規模言語モデル(Qwen-VL)と拡散変換器(DiT)を組み合わせることで、ユーザーは、背景を変更したり、オブジェクトを削除したり、スタイルを切り替えるなど、簡単な自然言語コマンドで画像を編集することができます。このプロジェクトは2025年4月25日にリリースされ、GPT-4oやDiTのようなクローズドソースのモデルに近い性能を発揮する。 ジェミニ 2フラッシュ。step1X-Editは、モデルの重み、推論コード、GEdit-Benchベンチマークを提供し、幅広い編集シナリオをサポートします。Apache 2.0ライセンスは、自由な使用と商業的な開発を可能にし、開発者、デザイナー、研究者を魅了しています。コミュニティによるサポートは活発で ComfyUI ハードウェア要件を最適化するためのプラグインとFP8量子化バージョン。

現在 ステップAI 無料で体験できます。ただし、実際の画像編集結果はGPT-4oやジェミニ2フラッシュとは若干異なる。

機能一覧

- 背景をビーチに変更」や「写真から人物を削除」など、画像編集のための自然言語コマンドをサポート。

- マルチモーダル大規模言語モデル(Qwen-VL)を用いて画像とテキストのコマンドを解析し、正確な編集を生成する。

- 元の画像のディテールを維持する拡散変換(DiT)に基づいて、高品質の画像を生成します。

- GEdit-Benchベンチマークを提供し、実際のユーザーコマンドでの編集パフォーマンスを評価します。

- FP8定量モデルをサポートし、ハードウェア要件を低減し、低メモリGPUに適応。

- ComfyUIプラグインとの統合により、ワークフローが簡素化され、ユーザーエクスペリエンスが向上します。

- オンラインデモが用意されており、インストールせずに編集機能を体験できる。

- オープンソースのモデル重みと推論コードで、二次開発や研究をサポート。

ヘルプの使用

設置プロセス

Step1X-Editを使用するには、環境をインストールし、モデルウェイトをダウンロードする必要があります。以下は、Linuxシステム(Ubuntu 20.04以上を推奨)に適した詳細な手順です:

- 環境を整える

Python 3.10以降とCUDAツールキット(12.1推奨)がインストールされていることを確認してください。GPUを推奨します(NVIDIA H800など、80GBのRAMが最適)が、FP8量子化バージョンではより低いRAM(16GBまたは24GB)をサポートしています。conda create -n step1x python=3.10 conda activate step1x

- クローン倉庫

GitHubからStep1X-Editプロジェクトのコードをダウンロードしてください:git clone https://github.com/stepfun-ai/Step1X-Edit.git cd Step1X-Edit - 依存関係のインストール

PyTorch(2.3.1または2.5.1推奨)と関連ライブラリをインストールする:pip install torch==2.3.1 torchvision --index-url https://download.pytorch.org/whl/cu121 pip install -r requirements.txtフラッシュ・アテンションをインストールする(オプション、推論を加速するため):

pip install flash-attn --no-build-isolationFlash Attentionのインストールで問題が発生した場合は、公式スクリプトを参照して、システムに適したコンパイル済みホイールファイルを生成することができます:

python scripts/find_flash_attn_wheel.py - モデルウェイトのダウンロード

Hugging FaceまたはModelScopeからモデルの重みとVariable Autocoder (VAE)をダウンロードします:- Step1X-モデルを編集する:

step1x-edit-i1258.safetensors(約24.9GB) - VAE:

vae.safetensors(約335MB) - Qwen-VLモデル:

Qwen/Qwen2.5-VL-7B-Instruct

Pythonスクリプトによる自動ダウンロード:

from huggingface_hub import snapshot_download import os target_dir = "models/step1x" os.makedirs(target_dir, exist_ok=True) # 下载 Step1X-Edit 模型 snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["step1x-edit-i1258.safetensors"]) # 下载 VAE snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["vae.safetensors"]) # 下载 Qwen-VL qwen_dir = os.path.join(target_dir, "Qwen2.5-VL-7B-Instruct") snapshot_download(repo_id="Qwen/Qwen2.5-VL-7B-Instruct", local_dir=qwen_dir) - Step1X-モデルを編集する:

- 走り推理

提供された推論スクリプトを使って画像を編集します。例えば、画像を編集して背景を変更します:python scripts/run_inference.py --image_path assets/demo.png --prompt "将背景改为夜空" --output_path output.pngパラメータの説明

--image_path画像パスを入力します。--prompt編集コマンド(「空を夕焼けに変える」など)。--output_path出力画像のパス。--size_level解像度(デフォルト512x512、1024x1024はより多くのメモリを必要とします。)--seed生成の一貫性を制御するためのランダムシード。

ComfyUIプラグインの使用

Step1X-Editは、ワークフローへの統合を希望するユーザーのために、ComfyUIプラグインを提供しています。

- ComfyUIプラグインリポジトリをクローンします:

cd path/to/ComfyUI/custom_nodes git clone https://github.com/quank123wip/ComfyUI-Step1X-Edit.git - モデルウェイトを

ComfyUI/models/Step1x-Editカタログstep1x-edit-i1258.safetensorsvae.safetensors- Qwen-VLモデルフォルダー:

Qwen2.5-VL-7B-Instruct

- ComfyUIを起動し、Step1X-Editノードをロードします。

- ComfyUIのインターフェイスで、画像をアップロードし、編集コマンド(例えば "Add Wings")を入力し、結果を生成するためにワークフローを実行します。

主な機能

- 自然言語エディタ

ユーザーは画像をアップロードし、テキストコマンドを入力する。例えば、写真の背景を山の景色に変更するには、「change background to mountain view」と入力する。モデルはQwen-VLを通してコマンドを解析し、セマンティクスを抽出し、DiTと連携して新しい画像を生成する。例えば、「空を美しく」よりも「空を青い星空に」の方が効果的である。 - オブジェクトの削除または追加

写真から人物を削除」や「木を追加」などのコマンド。モデルは画像の残りの部分を保持し、指定された領域を正確に編集します。複雑なシーンでは、コマンドを複数回調整することで結果を最適化できます。 - スタイルシフト

画像をピクセルアート風に変換」や「宮崎スタイルに変更」など、スタイリッシュな編集が可能。モデルは拡散され、スタイル化された画像を生成します。 - オンラインデモ

Hugging Faceスペース(https://huggingface.co/spaces/stepfun-ai/Step1X-Edit)にアクセスし、画像をアップロードし、指示を入力し、直接体験してください。各世代はGPU時間によって制限され、無料ユーザーは2回の挑戦が可能。

ほら

- ハードウェア要件FP8量子化バージョンは、3090 TiのようなGPU用に16GBのメモリに減らすことができる。

- コマンドの最適化複雑な編集では、「背景を雪山に変更し、前景のキャラクターは変更しない」といった細かい指示が必要になる。

- 地域支援GitHubリポジトリには活発なコミュニティがあるので、問題が発生したらIssuesやDiscussionsをチェックしてほしい。

アプリケーションシナリオ

- コンテンツ制作

デザイナーはStep1X-Editを使って、広告素材の背景を素早く変更したり、スタイルを調整したりします。例えば、商品写真の背景をホリデーテーマに変更し、ビジュアルアピールを強化します。 - 個人写真編集

一般ユーザーでも、背景の乱れを取り除いたり、昼間の写真を夜間の写真に変更したりといった写真の美化が、オンラインデモを通じて簡単に行え、専門的なスキルも必要ない。 - Eコマース製品の最適化

Eコマースプラットフォームは、Step1X-Editを使用して、撮影コストを節約するために、ビーチや都市の背景に服を配置するなど、さまざまなシナリオで商品ディスプレイ画像を生成します。 - 学術研究

研究者は、GEdit-Benchのデータセットとモデルの重みを使用して、新しい画像編集アルゴリズムを開発したり、モデルの性能を比較したりします。

品質保証

- Step1X-Editはどの解像度をサポートしていますか?

512x512と1024x1024の解像度をサポートし、512x512はより速く、より少ないメモリで、1024x1024はより詳細で、より多くのメモリを必要とします。 - 編集結果を最適化するには?

具体的な指示を用い、曖昧な表現は避ける。異なる表現を何度か試すことで、結果を改善することができる。例えば、「空を変える」よりも「空を赤い夕焼けに変える」の方が明確です。 - 中国語のコマンドに対応していますか?

はい、このモデルは中国語のコマンドをサポートしており、英語と同等の結果が得られます。要件を簡潔に記述することをお勧めします。 - FP8 定量化されたバージョンの違いは?

FP8バージョンは必要メモリが少ない(16GBで動作)が、ディテールが若干犠牲になる可能性がある。ハードウェアリソースが限られているユーザーに最適です。 - 操作にはネットワークが必要ですか?

ローカルでの実行にはインターネット接続は必要ありません。オンラインデモはHugging Faceスペースへのアクセスが必要です。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません