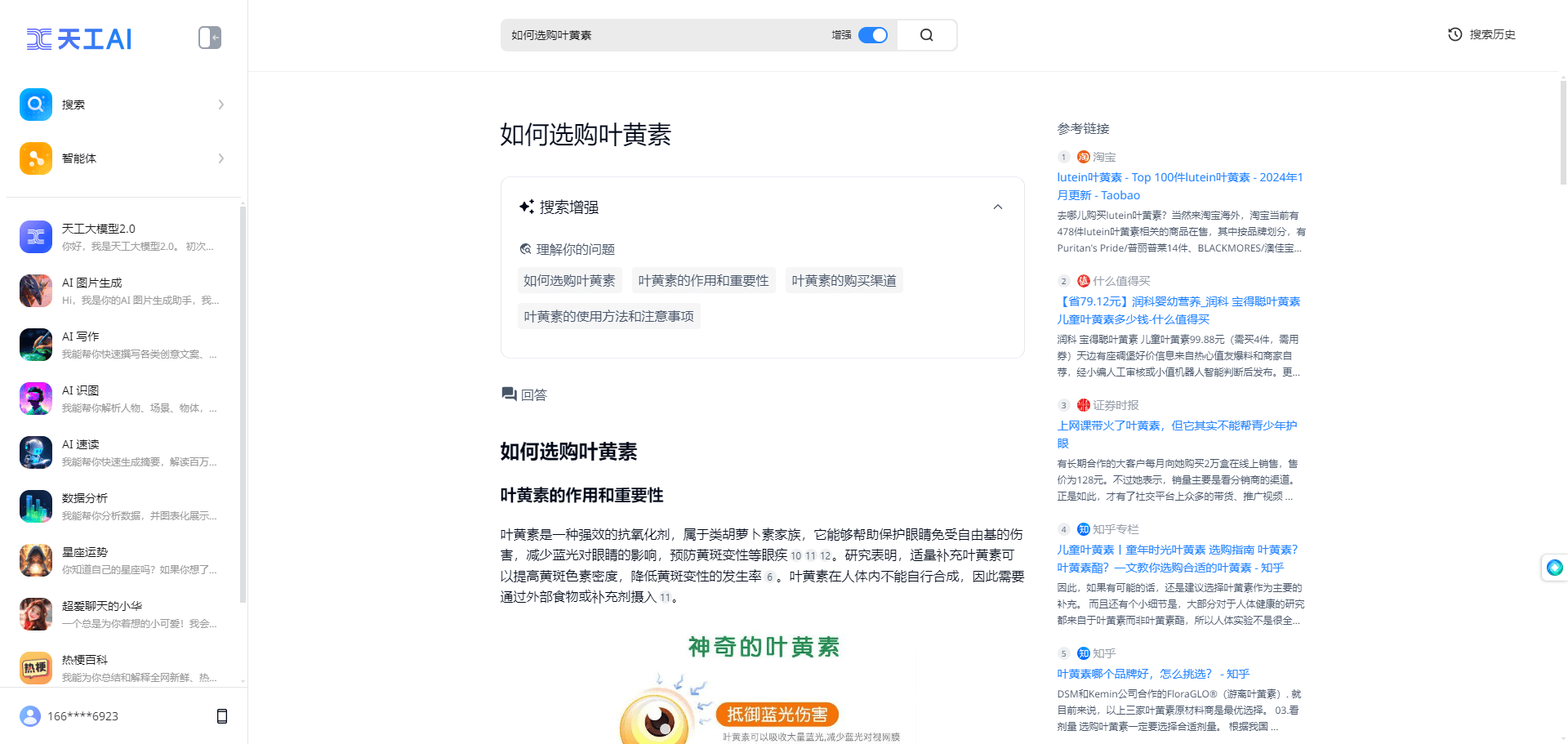

综合介绍

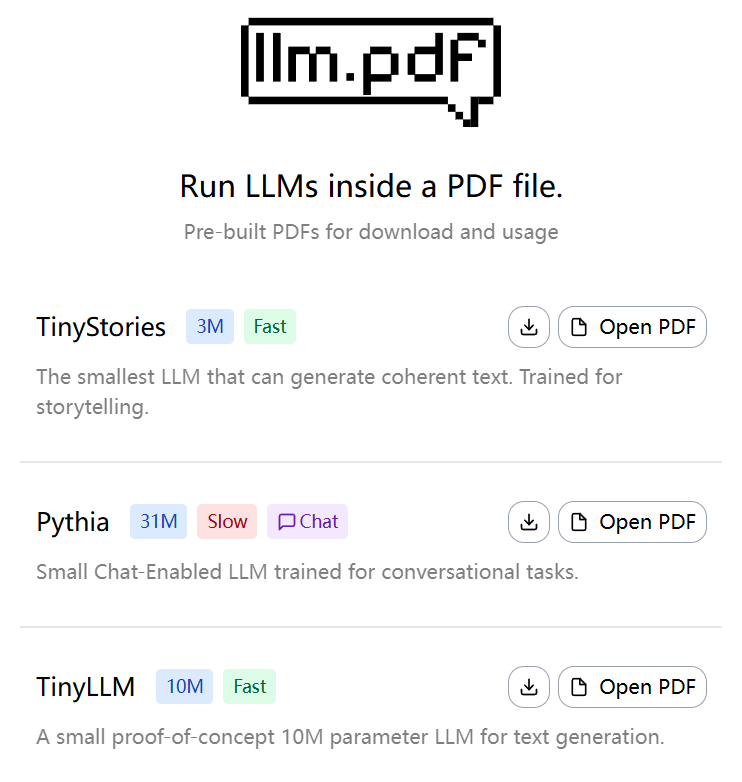

llm.pdf 是一个开源项目,允许用户在 PDF 文件中直接运行大型语言模型(LLM)。这个项目由 EvanZhouDev 开发,托管在 GitHub 上,展示了一种创新的方法:通过 Emscripten 将 llama.cpp 编译为 asm.js,并结合 PDF 的 JavaScript 注入功能,让 LLM 的推理过程完全在 PDF 文件中完成。项目支持 GGUF 格式的量化模型,推荐使用 Q8 量化模型以获得最佳性能。用户可以通过提供的 Python 脚本生成包含 LLM 的 PDF 文件,操作简单且高效。这个项目是一个概念验证,证明了在非传统环境中运行复杂 AI 模型的可行性,适合对 AI 和 PDF 技术感兴趣的开发者与研究者。

体验地址:https://evanzhoudev.github.io/llm.pdf/

功能列表

- 在 PDF 文件中运行大型语言模型,支持文本生成与交互。

- 使用 Emscripten 编译 llama.cpp 为 asm.js,实现浏览器环境中的模型推理。

- 支持 GGUF 格式的量化模型,推荐 Q8 量化以提升运行速度。

- 提供 Python 脚本

generatePDF.py,用于生成包含 LLM 的 PDF 文件。 - 支持模型文件通过 base64 编码嵌入 PDF,简化分发与使用。

- 提供 YouTube 视频教程,详细展示项目构建过程与使用方法。

- 开源代码,允许用户自定义与扩展功能。

使用帮助

安装与环境准备

要使用 llm.pdf 项目,用户需要准备一个支持 Python 3 的环境,并安装必要的依赖。以下是详细的安装步骤:

- 克隆项目仓库

打开终端,运行以下命令以克隆 llm.pdf 仓库:git clone https://github.com/EvanZhouDev/llm.pdf.git cd llm.pdf

- 安装 Python 依赖

项目依赖 Python 环境,推荐使用 Python 3.8 或更高版本。进入scripts目录,安装所需库:cd scripts pip install -r requirements.txt确保安装了 Emscripten 和其他必要的编译工具。如果未安装 Emscripten,可参考其官方文档进行配置。

- 准备 GGUF 模型

llm.pdf 仅支持 GGUF 格式的量化模型,推荐 Q8 量化模型以获得最佳性能。用户可以从 Hugging Face 或其他模型库下载 GGUF 模型,例如 TinyLLaMA 或其他小型 LLM。模型文件需保存到本地,例如/path/to/model.gguf。 - 生成 PDF 文件

项目提供了一个 Python 脚本generatePDF.py用于生成包含 LLM 的 PDF 文件。运行以下命令:python3 generatePDF.py --model "/path/to/model.gguf" --output "/path/to/output.pdf"--model:指定 GGUF 模型的路径。--output:指定生成的 PDF 文件保存路径。

脚本会将模型文件通过 base64 编码嵌入 PDF,并注入运行推理所需的 JavaScript 代码。生成过程可能需要几分钟,具体取决于模型大小和设备性能。

- 运行 PDF 文件

生成的 PDF 文件可以在支持 JavaScript 的 PDF 阅读器中打开,例如 Adobe Acrobat 或现代浏览器的 PDF 查看器。打开 PDF 后,模型会自动加载并运行推理。用户可以通过 PDF 界面输入文本,模型将生成相应的回复。注意:由于性能限制,135M 参数模型每生成一个 token 约需 5 秒。

特色功能操作

- 文本生成

在 PDF 文件中,用户可以通过文本输入框与 LLM 交互。输入提示(prompt)后,模型会逐 token 生成回复。推荐使用简短提示以减少推理时间。例如,输入“写一个关于猫的短句”,模型可能回复“猫咪喜欢追逐毛球。”生成的文本会显示在 PDF 的输出区域。 - 模型选择与优化

项目支持多种 GGUF 模型,用户可根据需求选择不同大小的模型。Q8 量化模型是推荐选择,因为它在性能与速度间取得了平衡。如果用户需要更快响应,可尝试更小的模型(如 135M 参数),但生成质量可能略低。 - 自定义扩展

llm.pdf 是开源项目,用户可以修改scripts/generatePDF.py或注入的 JavaScript 代码,以实现自定义功能。例如,添加新的交互界面或支持其他模型格式。用户需熟悉 Emscripten 和 PDF 的 JavaScript API。

注意事项

- 性能要求:运行 PDF 中的 LLM 推理需要较高的计算资源。建议在配备至少 8GB 内存的设备上运行。

- 模型兼容性:仅支持 GGUF 格式的量化模型。非量化模型或非 GGUF 格式会导致生成失败。

- 浏览器兼容性:部分旧版浏览器可能不支持 asm.js,建议使用最新版本的 Chrome 或 Firefox。

- 调试:如果 PDF 文件无法运行,可检查终端日志或浏览器的开发者工具(F12)查看 JavaScript 错误。

学习资源

项目提供了一个 YouTube 视频教程,详细讲解了 llm.pdf 的构建过程。用户可访问 GitHub 仓库的 README 或 docs 目录获取更多文档。社区讨论可在 GitHub Issues 页面找到,开发者可在此提出问题或贡献代码。

应用场景

- AI 技术展示

llm.pdf 可用于向客户或学生展示 AI 模型在非传统环境中的运行能力。例如,在技术会议上,开发者可以打开 PDF 文件,实时演示 LLM 的文本生成功能,突出 AI 的便携性与创新性。 - 教育与研究

学生和研究者可以使用 llm.pdf 学习 LLM 的推理过程与 PDF 的 JavaScript 功能。项目提供了一个实践平台,帮助用户理解模型量化的作用以及 Emscripten 的编译原理。 - 离线 AI 部署

在网络受限的环境中,llm.pdf 提供了一种无需服务器的 AI 部署方式。用户可以将模型嵌入 PDF,分发给他人,实现离线文本生成与交互。

QA

- llm.pdf 支持哪些模型?

llm.pdf 仅支持 GGUF 格式的量化模型,推荐 Q8 量化模型以获得最佳性能。用户可从 Hugging Face 下载兼容模型。 - 为什么生成的 PDF 文件运行缓慢?

PDF 中的 LLM peep推理受限于浏览器性能和模型大小。135M 参数模型每 token 约需 5 秒。建议使用 Q8 量化模型并在高性能设备上运行。 - 需要联网才能使用 llm.pdf 吗?

不需要。生成 PDF 后,模型和推理代码已嵌入文件,可离线运行。但生成 PDF 的过程需要联网下载依赖。 - 如何调试 PDF 文件中的错误?

打开 PDF 文件时,使用浏览器的开发者工具(F12)检查 JavaScript 错误。也可查看generatePDF.py的终端日志。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...