综合介绍

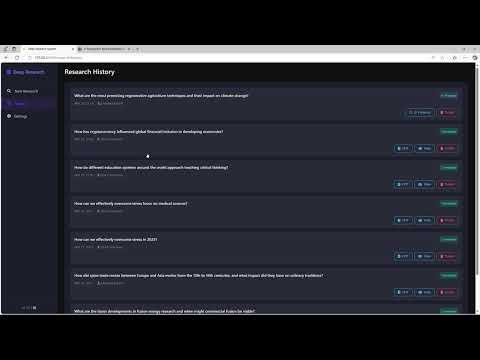

Local Deep Research 是一个开源的人工智能研究助手,旨在帮助用户针对复杂问题进行深度研究并生成详细的报告。它支持本地运行,使用户可以在不依赖云服务的情况下完成研究任务。工具结合了本地大语言模型(LLM)与多种搜索功能,覆盖学术数据库、维基百科、网页内容等来源。用户可以通过简单的安装和配置,快速生成包含引文的综合报告。项目强调隐私保护和灵活性,适合学术研究、技术探索或个人知识管理。

功能列表

- 支持本地大语言模型,保护数据隐私。

- 自动选择合适的搜索工具,如维基百科、arXiv、PubMed 等。

- 生成详细的报告,包含结构化章节和引文。

- 提供快速摘要功能,数秒内生成简要答案。

- 支持本地文档检索,结合网页搜索进行综合分析。

- 提供网页界面和命令行界面,操作灵活。

- 支持多语言搜索,适合全球用户。

使用帮助

安装流程

Local Deep Research 需要安装 Python 环境和相关依赖。以下是详细的安装步骤:

- 克隆仓库

在终端运行以下命令,将项目克隆到本地:git clone https://github.com/LearningCircuit/local-deep-research.git cd local-deep-research

- 安装依赖

使用 Python 的包管理工具安装所需库:pip install -e .如果需要浏览器自动化功能,安装 Playwright:

playwright install - 安装本地模型(Ollama)

Local Deep Research 支持通过 Ollama 运行本地大语言模型。访问 https://ollama.ai 下载并安装 Ollama,然后拉取推荐模型:ollama pull gemma3:12b确保 Ollama 服务在后台运行。

- 配置 SearXNG(可选)

为获得最佳搜索效果,建议自托管 SearXNG 搜索服务。运行以下命令启动 SearXNG:docker pull searxng/searxng docker run -d -p 8080:8080 --name searxng searxng/searxng在项目根目录的

.env文件中配置 SearXNG 地址:SEARXNG_INSTANCE=http://localhost:8080 SEARXNG_DELAY=2.0 - 启动工具

- 网页界面:运行以下命令启动网页版,访问 http://127.0.0.1:5000:

ldr-web - 命令行界面:运行以下命令启动命令行版:

ldr

- 网页界面:运行以下命令启动网页版,访问 http://127.0.0.1:5000:

操作主要功能

1. 生成快速摘要

快速摘要功能适合需要快速答案的用户。打开网页界面,输入研究问题,例如“核聚变能源的最新进展”。点击“快速摘要”按钮,工具会在几秒内返回简要答案,包含关键信息和来源。如果使用命令行,运行:

from local_deep_research import quick_summary

results = quick_summary(query="核聚变能源的最新进展", search_tool="auto", iterations=1, questions_per_iteration=2, max_results=30)

print(results["summary"])

结果会以文本形式输出,包含简短的总结和参考链接。

2. 生成详细报告

详细报告功能适合需要全面分析的用户。在网页界面输入问题后,选择“生成报告”选项。工具会进行多轮搜索和分析,生成包含目录、章节和引文的 Markdown 格式报告。报告生成时间取决于问题的复杂度和搜索轮次(默认 2 轮)。命令行操作示例:

from local_deep_research import generate_report

report = generate_report(query="核聚变能源的最新进展", search_tool="auto", iterations=2)

print(report)

生成的报告会保存在本地,路径通常为项目根目录下的 examples 文件夹。

3. 本地文档检索

用户可以将私人文档(如 PDF、TXT)上传至指定文件夹,通过检索增强生成(RAG)功能分析。配置文档路径:

DOC_PATH=/path/to/your/documents

在网页界面选择“本地文档”作为报告来源,工具会结合本地文档和网页搜索生成报告。命令行操作:

results = quick_summary(query="分析我的文档中的AI趋势", report_source="local")

4. 多语言搜索

工具支持多语言搜索,适合非英语问题。在网页界面输入中文或其他语言的问题,工具会自动适配搜索工具,返回相关结果。例如,输入“量子计算的最新突破”,工具会搜索中文和英文来源。

配置参数

用户可以通过修改 config.py 或 .env 文件调整参数:

search_tool:选择搜索工具(默认auto)。iterations:设置研究轮次(默认 2)。max_results:每轮搜索的最大结果数(默认 50)。max_filtered_results:过滤后的结果数(默认 5)。

注意事项

- 确保网络连接稳定,以便搜索外部资源。

- 本地模型性能取决于硬件,推荐使用 GPU 加速。

- 定期更新 Ollama 和项目代码,以获取最新功能。

应用场景

- 学术研究

学生和研究人员可以使用 Local Deep Research 快速收集学术论文和网页信息,生成带引文的报告。例如,研究“量子计算的突破”时,工具会从 arXiv 和 PubMed 检索最新论文,生成结构化报告。 - 技术探索

技术爱好者可以探索新兴技术趋势,如“区块链在供应链中的应用”。工具结合本地文档和网页搜索,提供全面分析。 - 个人知识管理

用户可以将私人笔记或文档上传,结合外部信息整理知识库。例如,整理“2025年AI发展预测”的个人报告。

QA

- Local Deep Research 是否需要联网?

本地模型运行不需要联网,但搜索功能(如维基百科、arXiv)需要网络连接。用户可选择仅使用本地文档。 - 支持哪些大语言模型?

默认支持 Ollama 托管的模型,如gemma3:12b。用户可通过config.py配置其他模型,如 vLLM 或 LMStudio。 - 如何提高报告质量?

增加搜索轮次(iterations)和结果数量(max_results),或使用更强大的模型。确保问题描述清晰也有助于提高准确性。 - 是否支持 Windows 系统?

是的,项目提供 Windows 一键安装包,简化配置流程。访问 GitHub 仓库下载。