Um anúncio recente no campo da memória corporal inteligente de IA despertou muito interesse no setor.A Mem0 Company publica relatórios de pesquisaA Zep afirma que seu produto é o líder do setor (SOTA) na tecnologia AI Smart Body Memory e supera seus concorrentes, incluindo a Zep, em benchmarks selecionados. No entanto, essa alegação foi rapidamente contestada pela equipe da Zep, que observou que, quando implementado adequadamente, seu produto realmente superou os benchmarks LoCoMo selecionados pela Mem0 em aproximadamente 241 TP3 T. Essa diferença significativa levou a uma investigação mais profunda sobre a imparcialidade dos benchmarks, o rigor do projeto experimental e a confiabilidade das conclusões finais.

Na arena altamente competitiva da Inteligência Artificial, receber a designação SOTA (State-of-the-Art) significa muito para qualquer empresa. Isso não significa apenas liderança tecnológica, mas também atrai investimentos, talentos e atenção do mercado. Portanto, qualquer declaração sobre o SOTA, especialmente as conclusões obtidas por meio de benchmarking, deve ser analisada minuciosamente.

Alegação da Zep: os resultados do teste LoCoMo foram revertidos com a implementação correta

Em sua resposta, a equipe da Zep observou que, quando o experimento LoCoMo foi configurado de acordo com as práticas recomendadas de seu produto, os resultados foram muito diferentes do relatório Mem0.

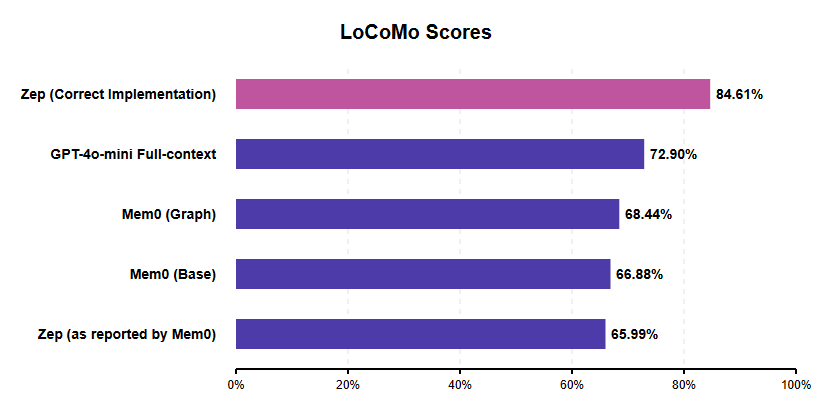

Todas as pontuações são de relatórios Mem0, exceto "Zep (Correct)", discutido aqui.

De acordo com a avaliação publicada pela Zep, a pontuação J de seu produto atinge 84.61%Em comparação com a configuração ideal do Mem0 (Mem0 Graph) de cerca de 68,41 TP3T, ele atinge cerca de 23.6% de ganhos relativos de desempenho. Isso contrasta com a pontuação de 65,99% de Zep relatada no documento Mem0, que Zep sugere ser provavelmente o resultado direto de um erro de implementação, conforme será discutido abaixo.

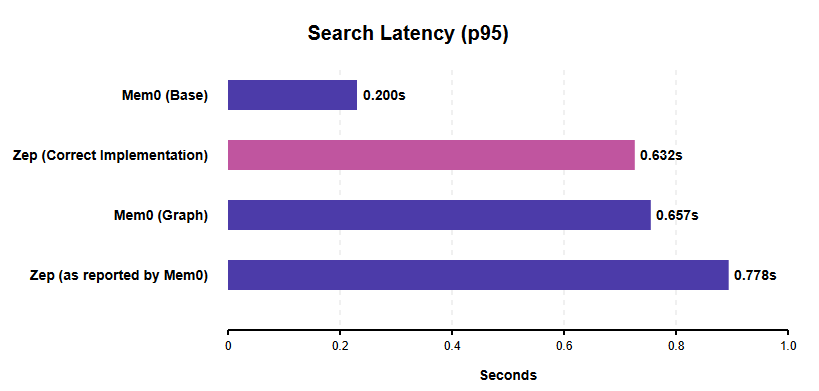

Em termos de **latência de pesquisa (latência de pesquisa p95)**, Zep observa que, quando seu sistema está configurado corretamente para pesquisas simultâneas, a latência de pesquisa p95 é 0,632 segundos. Isso é melhor do que os 0,778 segundos do Zep no relatório do Mem0 (que o Zep especula estar inflado por sua implementação de pesquisa sequencial) e um pouco mais rápido do que a latência de pesquisa de gráficos do Mem0 (0,657 segundos).

Todas as pontuações são de relatórios Mem0, exceto "Zep (Correct)", discutido aqui.

É importante observar que a configuração básica do Mem0 (Mem0 Base) mostra uma latência de pesquisa menor (0,200 segundos). No entanto, essa não é uma comparação totalmente equivalente, pois o Mem0 Base usa um armazenamento/cache de vetor mais simples que não tem os recursos relacionais de um banco de dados de gráficos e também tem a menor pontuação de precisão das variantes do Mem0. As pesquisas simultâneas eficientes da Zep demonstram um desempenho sólido para inteligências de IA de nível de produção que exigem estruturas de memória mais complexas e buscam capacidade de resposta, e a Zep explica que seus dados de latência foram medidos em um ambiente AWS us-west-2 com uma configuração NAT para transmissão.

Limitações de benchmarking do LoCoMo levantam questões

A decisão da Mem0 de escolher o LoCoMo como benchmark para sua pesquisa foi examinada pela Zep, que identificou várias falhas fundamentais no benchmark, tanto em nível de projeto quanto de execução. Projetar e executar um benchmark abrangente e imparcial é uma tarefa difícil por si só, exigindo conhecimento profundo, recursos adequados e uma compreensão completa dos mecanismos internos do sistema em teste.

Os principais problemas com o LoCoMo identificados pela equipe da Zep incluem:

- Extensão e complexidade insuficientes do diálogoA duração média de uma conversa na LoCoMo é de 16.000 a 26.000 tokens. Embora isso possa parecer longo, geralmente está dentro dos recursos de janela de contexto dos LLMs modernos. Essa duração não exerce pressão sobre os recursos de recuperação da memória de longo prazo. Como forte evidência, os próprios resultados do Mem0 mostram que seu sistema não tem um desempenho tão bom quanto uma simples "linha de base de contexto completo" (ou seja, alimentando toda a conversa diretamente no LLM). A pontuação J para a linha de base de contexto completo é de cerca de 731 TP3T, enquanto a melhor pontuação do Mem0 é de cerca de 681 TP3T. Se o simples fornecimento de todo o texto produz resultados melhores do que um sistema de memória profissional, então o benchmark não examina adequadamente os rigores da capacidade de memória em interações de inteligência de IA do mundo real.

- Falha ao testar funções críticas da memóriaO benchmark não apresenta o problema de "atualização de conhecimento" que foi projetado para testar. A atualização da memória à medida que as informações mudam com o tempo (por exemplo, quando um usuário muda de emprego) é um recurso essencial para a memória de IA.

- Problemas de qualidade de dadosO próprio conjunto de dados apresenta várias falhas de qualidade:

- Categoria de indisponibilidadeCategoria 5: A categoria 5 não pôde ser usada devido à falta de uma resposta padronizada, o que forçou Mem0 e Zep a excluírem essa categoria de suas avaliações.

- erro multimodalAlgumas das perguntas eram sobre as imagens, mas as informações necessárias não apareciam nas descrições das imagens geradas pelo modelo BLIP durante o processo de criação do conjunto de dados.

- Atribuição incorreta de alto-falantesAlgumas perguntas atribuem incorretamente o comportamento ou as declarações ao orador errado.

- Falta de clareza na definição do problemaAlgumas perguntas são ambíguas e podem ter mais de uma resposta potencialmente correta (por exemplo, perguntar a uma pessoa quando ela vai acampar quando ela pode ter estado lá tanto em julho quanto em agosto).

Devido a esses erros e inconsistências, a confiabilidade do LoCoMo como uma medida confiável do desempenho da memória das inteligências de IA é questionável. Infelizmente, o LoCoMo não é um caso isolado. Outros benchmarks, como o HotPotQA, foram criticados por usar dados de treinamento LLM (por exemplo, Wikipedia), simplificar demais as perguntas e cometer erros factuais. Isso destaca o desafio contínuo de realizar um benchmarking robusto em IA.

Mem0 Críticas à metodologia de avaliação da Zep

Além da controvérsia em torno do próprio benchmark LoCoMo, a comparação do Zep no artigo Mem0 é, de acordo com o Zep, baseada em uma implementação falha e, portanto, não reflete com precisão os verdadeiros recursos do Zep:

- Modelo de usuário incorretoMem0 usa uma estrutura de gráfico de usuário projetada para uma única interação usuário-ajudante, mas atribui funções de usuário ao diálogoambas as partes envolvidasParticipantes. É provável que isso confunda a lógica interna do Zep, fazendo com que ele veja o diálogo como um único usuário que troca constantemente de identidade entre as mensagens.

- Tratamento inadequado de carimbo de data/horaTimestamps: Os timestamps são passados anexando-os ao final da mensagem, em vez de usar o campo created_at específico do Zep. Essa abordagem não padrão interfere nos recursos de inferência de tempo do Zep.

- Pesquisa sequencial vs. paralelaA operação de pesquisa é executada sequencialmente, e não em paralelo, o que aumenta artificialmente a latência de pesquisa do Zep, conforme relatado por Mem0.

A Zep argumenta que esses erros de implementação interpretaram de forma fundamentalmente equivocada a forma como a Zep foi projetada para operar e inevitavelmente levaram ao desempenho ruim relatado no documento Mem0.

O setor exige uma melhor avaliação comparativa: por que a Zep prefere o LongMemEval

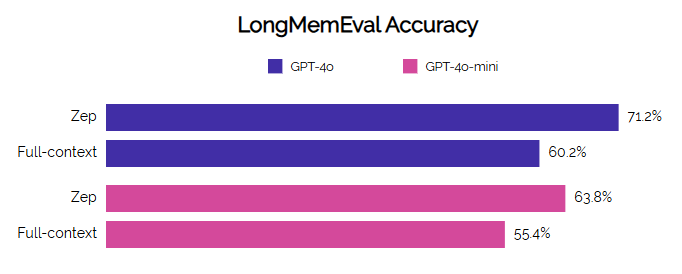

A controvérsia causada pelo LoCoMo reforçou a necessidade do setor de um benchmarking mais robusto e relevante, e a equipe da Zep expressou sua preferência por benchmarks como o LongMemEval Esse é um critério de avaliação, pois compensa as deficiências da LoCoMo de várias maneiras:

- Duração e desafiocontém diálogos significativamente mais longos (115 mil tokens em média) que realmente testam os limites contextuais.

- Raciocínio temporal e mudança de estadoConhecimento: testa explicitamente a compreensão do tempo e a capacidade de lidar com mudanças nas informações (atualização do conhecimento).

- massa (em física)Planejamento e design feitos à mão com o objetivo de garantir alta qualidade.

- Relevância corporativaMais representativo da complexidade e dos requisitos dos aplicativos empresariais do mundo real.

O Zep demonstrou um bom desempenho no LongMemEval, obtendo melhorias significativas na precisão e na latência em comparação com a linha de base, especialmente em tarefas complexas, como síntese de várias sessões e inferência temporal.

O benchmarking é um exercício complexo, e a avaliação dos produtos da concorrência exige ainda mais diligência e conhecimento para garantir que as comparações sejam justas e precisas. A partir da refutação detalhada apresentada pela Zep, parece que o desempenho SOTA alegado pela Mem0 se baseia em um benchmark defeituoso (LoCoMo) e em uma implementação defeituosa do sistema de um concorrente (Zep).

Quando avaliado corretamente sob o mesmo benchmark, o Zep supera significativamente o Mem0 em termos de precisão e mostra alta competitividade em termos de latência de pesquisa, especialmente ao comparar implementações baseadas em gráficos. Essa diferença destaca a importância fundamental de um projeto experimental rigoroso e de um profundo conhecimento do sistema que está sendo avaliado para se chegar a conclusões confiáveis.

No futuro, o campo da IA precisa desesperadamente de um benchmarking melhor e mais representativo. Os observadores do setor também estão incentivando as equipes do Mem0 a avaliar seus produtos em benchmarks mais desafiadores e relevantes, como o LongMemEval, no qual a Zep já publicou seus resultados, a fim de fazer comparações mais significativas entre os recursos de memória de longo prazo das inteligências de IA. Não se trata apenas da reputação de produtos individuais, mas da direção certa do progresso tecnológico para o setor como um todo.

Referência:ZEP: uma arquitetura de gráfico de conhecimento temporal para memória corporal inteligente