Recentemente, a ferramenta de programação assistida por IA Cursor publicou uma lista dos principais modelos de IA preferidos pelos desenvolvedores, e os dados mostram que Claude 3,7 O modelo Sonnet ocupa o primeiro lugar.

Esses dados oficiais certamente refletem a escolha de uma parte significativa dos desenvolvedores. Mas será que isso significa que os desenvolvedores devem simplesmente tornar o Claude 3.7 Sonnet a opção padrão? O caso de uso real pode ser mais complexo.

A análise dos hábitos de uso de alguns desenvolvedores seniores revela diferenças significativas nas taxas de seleção de modelos em relação à lista oficial. Por exemplo, no Cursor, o Gemini 2.5 Pro pode ser usado até 801 TP3T, o Claude 3.7 Sonnet é responsável por 101 TP3T e os GPT-3.5 e GPT-4.1 5% cada. Em outros ambientes de linha de comando ou de edição de código (como o Roo ou o Cline e outras ferramentas), o Grok 3 pode até atingir uma taxa de uso de 901 TP3T, com os 101 TP3T restantes alocados para o Gêmeos 2.5 Flash, outros modelos raramente são chamados.

Por trás dessa diferença está uma combinação de considerações baseadas nos requisitos reais da tarefa, na relação custo-benefício e nas características do modelo. Aqui estão alguns princípios e configurações de preferência que vale a pena considerar ao selecionar e usar esses assistentes de codificação de IA.

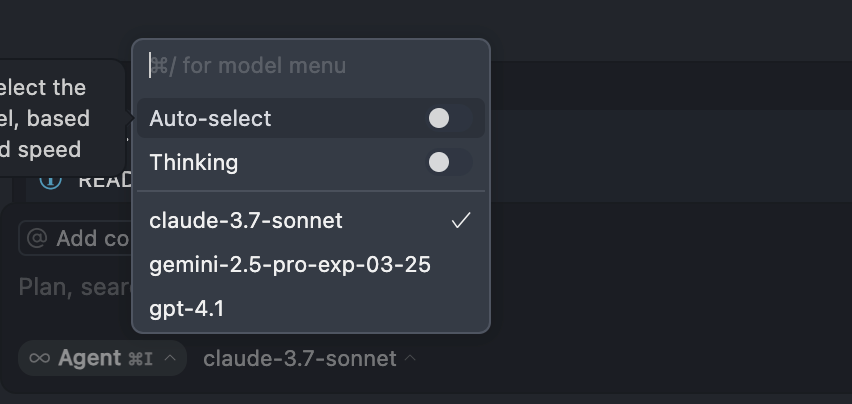

Evite usar o modo "Auto".

O modo "Auto" de seleção de modelos em ferramentas como o Cursor não é recomendado, principalmente porque o desenvolvedor perde o controle direto sobre a seleção de modelos. Embora esse recurso tenha o objetivo de equilibrar o consumo de modelos, a potência e a capacidade de resposta, a realidade é que muitas vezes há um difícil equilíbrio entre os três - normalmente, mais potência significa maior consumo ou velocidade mais lenta.

Em vez de deixar o sistema atribuir automaticamente um modelo que pode não ser adequado à tarefa em questão, desperdiçando recursos (por exemplo, pontos ou número de chamadas), é melhor mudar manualmente para o modelo mais adequado às necessidades específicas. Portanto, recomenda-se que essa opção automática seja desativada a longo prazo.

Ativação do modo "Thinking" (cadeia de pensamento)

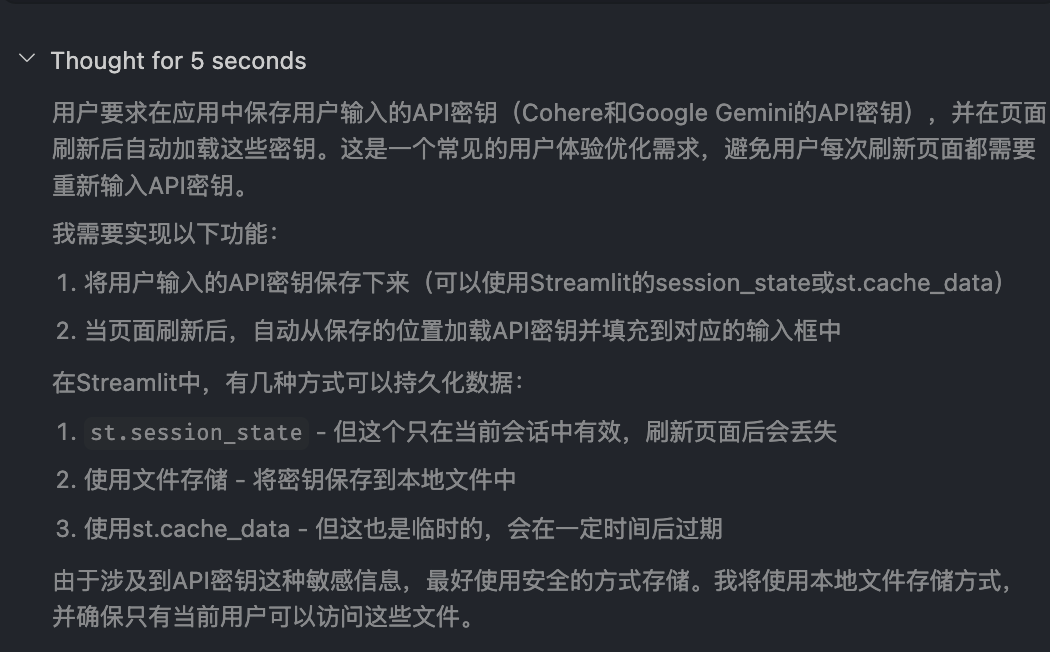

A tecnologia Chain-of-Thought agora é padrão nos principais modelos de IA. É fundamental habilitar a opção de exibir o "processo de pensamento" do modelo (geralmente chamado de "Thinking" ou similar).

A ativação desse modo não só ajuda a melhorar a capacidade do modelo de lidar com problemas complexos, mas as etapas de raciocínio detalhadas que ele exibe também fornecem aos desenvolvedores uma visão do funcionamento do modelo. Isso traz um benefício duplo: em primeiro lugar, a estratégia de solução de problemas do modelo pode ser aprendida por meio da observação e a experiência em lidar com tarefas semelhantes pode ser acumulada; em segundo lugar, a direção do raciocínio e a solução do modelo podem ser rapidamente avaliadas como corretas ou não, de modo a intervir e fazer ajustes em tempo hábil em um estágio inicial.

Troca de modelos de acordo com o tipo de tarefa

Nenhum modelo é perfeito para todas as tarefas, e a troca de modelos de forma dinâmica é a chave para a eficiência.

Planejamento de projetos em grande escala e preparação de código

Para tarefas macro, como planejamento de projetos, classificação de bases de código complexas ou legadas e geração de regras, o Gemini 2.5 Pro ou o Claude 3.7 Sonnet são as principais opções. Desses, o Gemini 2.5 Pro tem uma vantagem significativa devido à sua grande janela de contexto e é especialmente adequado para lidar com projetos mais antigos com várias iterações e grandes quantidades de código.

O principal ponto forte aqui é a capacidade de lidar com o grande volume de informações; o Gemini 2.5 Pro atualmente suporta janelas de contexto de até 1 milhão de tokens (tokens são uma unidade de medida para a quantidade de dados textuais), com planos de expansão para 2 milhões de tokens. Isso significa que ele pode lidar com o equivalente a milhares de páginas de documentos, bases de código inteiras ou grandes entradas de dados multimodais contendo texto, imagens, áudio e vídeo, tudo de uma só vez. Isso significa que ele pode lidar com o equivalente a milhares de páginas de documentos, bases de código inteiras ou grandes entradas de dados multimodais contendo texto, imagens, áudio e vídeo de uma só vez. Em contrapartida, outros modelos convencionais, como o gpt-4o-mini da OpenAI e o Antrópica Claude 3.7 Atualmente, o Sonnet oferece uma janela de contexto de cerca de 200.000 tokens.

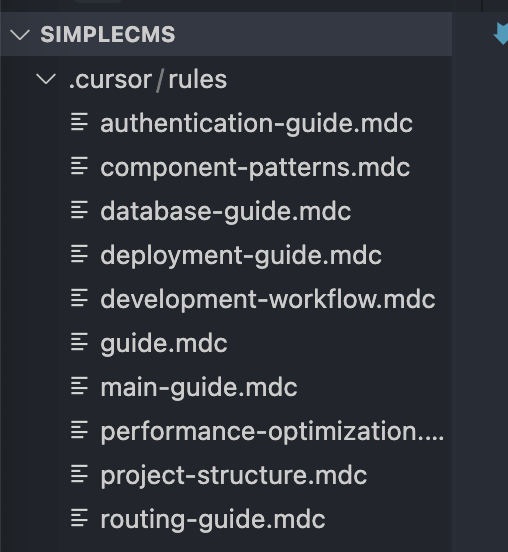

A experiência demonstrou que o Gemini 2.5 Pro é excelente na geração automática de arquivos de documentos (por exemplo, supõe-se que o arquivo mdc mencionado no artigo original possa se referir a um documento Markdown ou a algum outro formato), com menos ocorrências de "alucinações" aparentes (ou seja, a geração de conteúdo impreciso ou sem sentido).

Modificação de arquivo único e desenvolvimento modular

Para tarefas de menor escopo, como a modificação de um único arquivo ou o desenvolvimento modular, a mudança para a família de modelos Sonnet Claude 3.x costuma ser a melhor opção. Os modelos Claude são conhecidos por sua capacidade de resposta, precisão e recursos de geração de código.

Nesse caso, o desenvolvedor pode ter que escolher: usar o Claude 3.7 Sonnet mais recente ou o Claude 3.5 Sonnet um pouco mais antigo?

A experiência de alguns desenvolvedores sugere que o Claude 3.5 Sonnet pode parecer mais estável e confiável do que o 3.7 Sonnet em alguns cenários. Em particular, o modo "pensar" do 3.7 Sonnet pode, às vezes, levar a um ciclo de alterações iterativas que não atingem o resultado desejado depois de lidar com problemas muito complexos ou longas conversas. Portanto, embora o 3.5 Sonnet tenha sido lançado há algum tempo, ele ainda é uma opção muito robusta e confiável para muitos cenários de desenvolvimento cotidiano.

Pense no Gemini 2.5 Pro como um planejador estratégico capaz de lidar com informações em grande escala, enquanto a série Claude 3.x Sonnet é mais um comando que executa tarefas específicas de codificação e resolve problemas rapidamente.

Otimização específica da tarefa

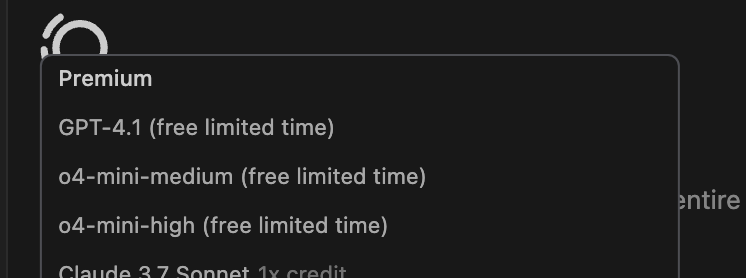

- Depuração simples ou pequenas modificações: Para tarefas simples, como corrigir erros de digitação e fazer pequenos ajustes de código, considere o uso de um modelo mais rápido ou de menor custo, como o GPT-4.1, que pode estar em uma fase de teste gratuita ou de baixo custo no momento e, mesmo que seja cobrado no futuro, espera-se que consuma muito menos pontos do que os modelos topo de linha, tornando-o econômico para essas "pequenas correções". Ele é muito econômico para esse tipo de tarefa de "conserto" e evita o desperdício de recursos na forma de "matar uma galinha com um touro".

- Tarefas multimodais: A família de modelos Claude 3.x Sonnet normalmente tem um desempenho melhor quando a tarefa envolve trabalhar com imagens, como gerar código para uma página da Web com base em um desenho, e os modelos Claude são reconhecidamente fortes na compreensão de elementos visuais e na geração de código para interfaces esteticamente agradáveis.

Seleção de modelos específicos de ferramentas (Roo, Cline, etc.)

Em algumas ferramentas de IA de linha de comando ou plug-ins de IDE diferentes do Cursor (por exemplo, Roo e Cline, conforme mencionado no artigo original), a seleção de modelos pode ser fortemente influenciada pelo custo e pela usabilidade.

Nesses ambientes, o uso de Grok 3 pode se tornar uma opção pragmática, principalmente por causa de sua franquia de uso relativamente generosa. O x AI oferece uma franquia mensal gratuita considerável para a API do Grok 3 (supostamente perto de US$ 150), o que é extremamente atraente para os desenvolvedores que precisam fazer muitas chamadas. Para obter mais informações, consulte Lançamento chocante do Grok 3: o corpo da inteligência de raciocínio explode! API lança "cobrança de US$ 5 por US$ 150" responder cantando OpenAI Codex CLI: um assistente de codificação de IA de linha de comando de terminal lançado pela OpenAI e outras discussões da comunidade. Por outro lado, o uso de outros modelos de primeira linha pode gerar custos elevados rapidamente. Embora a família de modelos Gemini ofereça uma camada gratuita, ela geralmente é acompanhada de limitação de taxa e é propensa a disparar erros quando há muitas solicitações consecutivas ou simultâneas.

Além disso, para determinadas tarefas repetitivas ou de codificação em lote (o acrônimo MCP pode se referir a cenários como "Processamento de código em massa" ou similares), vale a pena considerar uma versão do Gemini Flash que, como o próprio nome sugere, otimiza a capacidade de resposta e, ao mesmo tempo, mantém uma compreensão contextual suficiente. O Gemini Flash atinge um bom equilíbrio entre velocidade e precisão ao lidar com esses tipos de tarefas em lote que exigem uma resposta rápida e precisa.

Em última análise, uma estratégia eficaz de uso de modelos de IA não se resume à escolha de um único modelo, mas sim à alternância manual dinâmica e flexível entre diferentes cenários e ferramentas com base nos requisitos da tarefa, nos orçamentos de custo e nas características do modelo. Por exemplo, seria sensato priorizar modelos de alto desempenho, como o Claude 3.7 Sonnet ou o Gemini 2.5 Pro, para tarefas complexas dentro da cota disponível e, em seguida, alternar para opções mais econômicas, como o GPT-4.1 ou o Grok 3, quando a cota estiver quase esgotada ou para tarefas simples.