A JetBrains, fornecedora de ferramentas de desenvolvimento de software, anunciou recentemente que abriu o código-fonte da versão básica do Mellum, seu modelo de linguagem projetado especificamente para o preenchimento de código, e o disponibilizou na plataforma Hugging Face. A iniciativa foi projetada para promover a transparência e a colaboração no campo da IA no desenvolvimento de software.

Em vez de buscar a onipresença, a filosofia de design da Mellum se concentra em uma tarefa principal: a conclusão do código. A JetBrains chama esse tipo de modelo de Modelos dedicados (modelo especializado), enfatizando que seu objetivo de design é ter recursos profundos em domínios específicos, em vez de buscar cegamente uma ampla generalidade. O modelo suporta o recurso de autocompletar código em várias linguagens de programação, incluindo Java, Kotlin, Python, Go, PHP, C, C++, C#, JavaScript, TypeScript, CSS, HTML, Rust e Ruby.

código aberto Mellum-4b-base é o primeiro modelo da família Mellum. A JetBrains planeja expandir essa família no futuro com modelos mais dedicados a diferentes tarefas de codificação, como a previsão de disparidade.

As considerações por trás do código aberto

A decisão de tornar o Mellum open source não foi tomada de ânimo leve. Em vez de ser uma versão aperfeiçoada de um modelo de código-fonte aberto existente, o Mellum foi treinado desde o início pela JetBrains para fornecer funcionalidade de conclusão de código baseada em nuvem para seus produtos IDE, e foi lançado ao público no ano passado.

A JetBrains diz que o Open Source Mellum se baseia na crença no poder da transparência, da colaboração e do progresso compartilhado. Desde o Linux e o Git até o Node.js e o Docker, o paradigma do código aberto tem sido um dos principais impulsionadores de grandes saltos tecnológicos. Considerando que já existem LLMs de código aberto que superam o desempenho de alguns líderes do setor, não é improvável que o desenvolvimento geral da IA siga uma trajetória semelhante.

A mudança também significa que a JetBrains está abrindo uma de suas principais tecnologias para a comunidade. Ao lançar o Mellum no Hugging Face, a empresa está oferecendo a pesquisadores, educadores e equipes técnicas sênior a oportunidade de obter informações sobre o funcionamento interno de um modelo especializado. Isso é mais do que apenas fornecer uma ferramenta, é um investimento em pesquisa e colaboração abertas.

O que é um modelo especializado?

No campo do aprendizado de máquina, a especialização não é um conceito novo, mas uma abordagem central que orienta o design de modelos há décadas: criar modelos para resolver tarefas específicas de forma eficiente e eficaz. No entanto, nos últimos anos, a discussão em IA mudou gradualmente para a tentativa de cobrir todas as tarefas com grandes modelos generalizados, mas isso geralmente acarreta custos computacionais e ambientais significativos.

Modelos dedicadosEm vez disso, ele retorna ao objetivo original da especialização: criar modelos com bom desempenho em um domínio específico.

Isso pode ser comparado a uma "habilidade em T": um indivíduo tem amplo conhecimento de muitos tópicos (amplitude de conhecimento, a barra horizontal do T), mas uma profunda especialização em um domínio específico (profundidade de conhecimento, a barra vertical do T). Os modelos especializados seguem a mesma filosofia; eles não são feitos para lidar com tudo, mas se especializam e se destacam em uma única tarefa para serem realmente valiosos em um determinado domínio.

O Mellum é a personificação dessa filosofia. É um modelo relativamente pequeno e eficiente projetado para tarefas relacionadas a códigos, começando com o preenchimento de código.

O motivo dessa abordagem é que nem todos os problemas exigem soluções genéricas, e nem todas as equipes têm os recursos ou a necessidade de executar modelos grandes e abrangentes. Os modelos especializados (como o Mellum) oferecem vantagens distintas:

- Fornecer precisão para tarefas específicas do domínio.

- Econômico em termos de operação e implementação.

- As necessidades de cálculo e as pegadas de carbono são baixas.

- Oferece maior acessibilidade para pesquisadores, educadores e equipes pequenas.

Não se trata de um retrocesso tecnológico, mas de uma aplicação de princípios de especialização comprovados a problemas modernos de IA. A JetBrains vê isso como uma maneira mais inteligente de avançar.

Qual é o desempenho do Mellum?

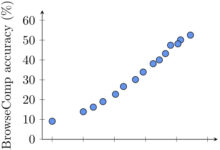

O Mellum é um modelo paramétrico 4B multilíngue (Mellum-4b-base), otimizado especificamente para autocompletar código. A JetBrains avaliou-o em várias linguagens em vários conjuntos de dados e realizou uma extensa avaliação manual em seu IDE.

Abaixo estão os dados que comparam o desempenho do Mellum com vários modelos com maior número de parâmetros (detalhes completos, resultados e comparações podem ser encontrados no cartão de modelo do Hugging Face):

| modelagem | HumanEval Infilling (linha única) | HumanEval Infilling (várias linhas) | RepoBench 1.1 (2K contexto, py) | SAFIM (média) |

|---|---|---|---|---|

| Mellum-4B-base | 66.2 | 38.5 | 28.2 | 38.1 |

| InCoder-6B | 69.0 | 38.6 | - | 33.8 |

| CodeLlama-7B-base | 83.0 | 50.8 | 34.1 | 45.0 |

| CodeLlama-13B-base | 85.6 | 56.1 | 36.2 | 52.8 |

| DeepSeek-Coder-6.7B | 80.7 | - | - | 63.4 |

Observação: o HumanEval Infilling testa os recursos de preenchimento de código, o RepoBench avalia o desempenho no contexto de uma base de código real e o SAFIM é outro teste de referência de preenchimento de código. Os modelos de comparação incluem a família CodeLlama da Meta e o modelo Coder da DeepSeek.

Os dados mostram que a Mellum tem um desempenho competitivo em benchmarks específicos (especialmente quando seu tamanho é levado em conta), apesar de seu pequeno número de participantes. Isso reforça ainda mais a noção de que modelos dedicados podem alcançar um desempenho eficiente em tarefas específicas. A contagem de parâmetros não é a única medida da capacidade de um modelo, mas a otimização específica da tarefa também é fundamental.

Para quem é o Mellum?

É importante deixar claro que a versão atual do Mellum lançada no Hugging Face não se destina principalmente ao desenvolvedor final médio, que pode não estar ajustando ou implantando o modelo diretamente.

O modelo está aberto para os seguintes grupos:

- Pesquisadores de IA/ML: Em particular, os acadêmicos que estão explorando a função da IA no desenvolvimento de software, realizando benchmarking ou investigando a interpretabilidade do modelo.

- Engenheiros e educadores de IA/ML: Ele pode ser usado como base para aprender a criar, ajustar e adaptar modelos de linguagem específicos do domínio ou para apoiar projetos educacionais que se concentram na arquitetura e na especialização do LLM.

Conheça a Mellum agora

O modelo básico do Mellum agora está disponível em Cara de abraço Lançamento. A JetBrains enfatiza que este é apenas o começo e que seu objetivo não é buscar a generalidade, mas criar ferramentas focadas e eficientes. Para aqueles que desejam explorar, experimentar ou construir com base no Mellum, o modelo agora pode ser acessado e testado.