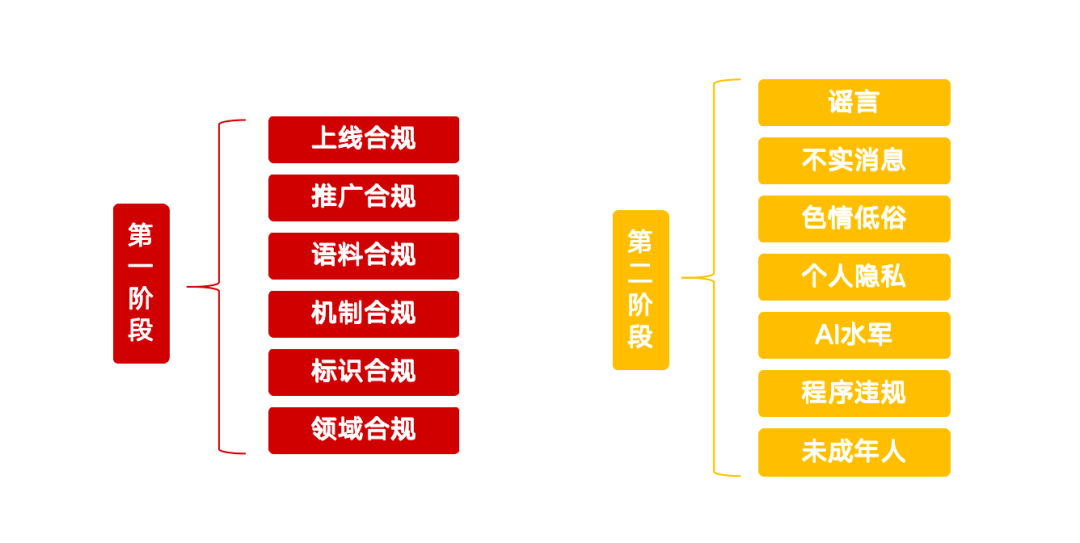

Recentemente, o Escritório Central de Tecnologia da Informação da Internet lançou uma ação especial chamada "Clear - Rectify the Abuse of AI Technology" (Limpar - Retificar o abuso da tecnologia de IA), que traça uma linha vermelha clara para a governança de várias questões que surgiram no desenvolvimento atual da inteligência artificial. Essa iniciativa tem o objetivo de orientar o desenvolvimento saudável da tecnologia de IA e evitar possíveis riscos. A ação especial se concentra em 13 direções principais e é dividida em duas fases, com requisitos detalhados para produtos, serviços, conteúdo e normas comportamentais de IA.

Fase I: Governança e infraestrutura de origem

A primeira fase da ação se concentra no gerenciamento de origem da tecnologia de IA, com o objetivo de limpar os aplicativos de IA ofensivos, fortalecer o gerenciamento de rotulagem de conteúdo e melhorar a capacidade da plataforma de detectar e identificar falsificações.

Os produtos de IA que não estão em conformidade precisam concluir a conformidade on-line

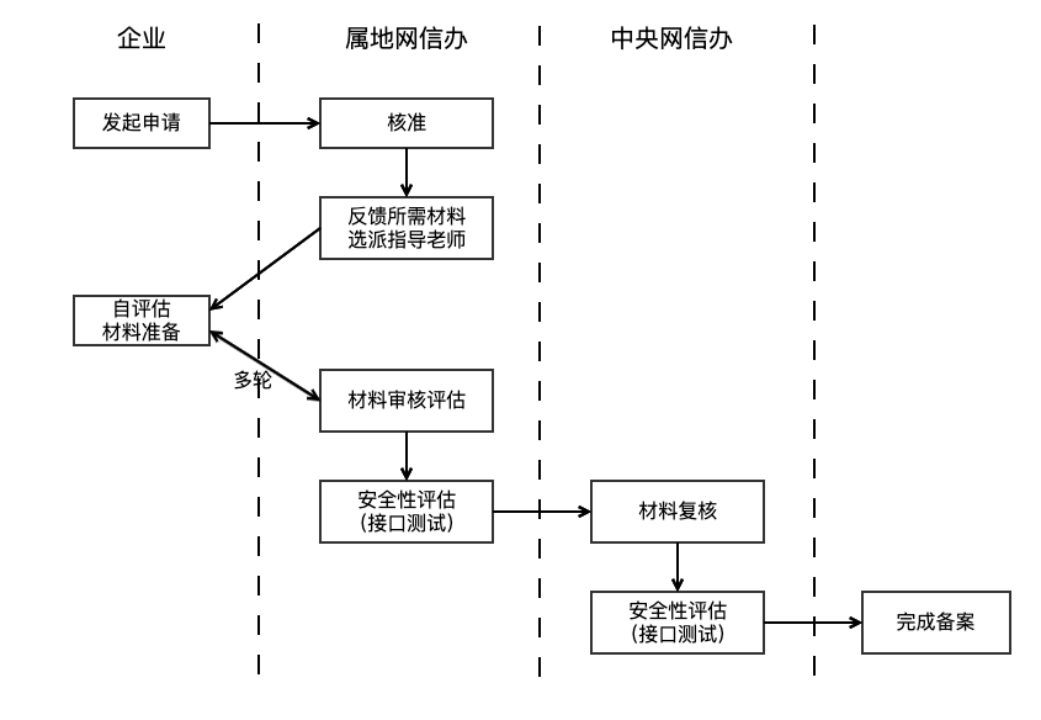

O órgão regulador observou que os aplicativos que usam tecnologia de IA generativa para fornecer serviços ao público devem cumprir o processo de arquivamento ou registro de modelo grande. Essa exigência baseia-se no Artigo 17 das Medidas Provisórias para a Administração de Serviços de Inteligência Artificial Generativa (doravante denominadas Medidas Provisórias), que deixa claro que os produtos de IA devem passar por uma avaliação de segurança antes de serem lançados oficialmente. Em geral, espera-se que o ciclo de registro leve de três a seis meses. Além disso, é contra a lei fornecer funções ilegais e antiéticas, como "despir-se com um clique", ou clonar ou editar os recursos biométricos de outras pessoas (por exemplo, vozes e rostos) sem autorização.

Identificar e regulamentar os serviços de IA não registrados tornou-se um desafio. Os órgãos reguladores podem usar meios técnicos, como rastreadores da Web, para monitorar várias plataformas, identificando se os serviços chamam interfaces de API de grandes modelos (por exemplo, geração de diálogo, síntese de imagens) e seus recursos técnicos. Para a conformidade do design funcional, além da avaliação jurídica interna das empresas e das auditorias de lojas de aplicativos, a regulamentação dos serviços de canais informais atualmente se baseia mais em relatórios de reclamações de usuários. Os provedores de serviços devem verificar se os produtos de IA concluíram o arquivamento duplo (arquivamento de modelo grande e arquivamento de algoritmo) e garantir que o projeto funcional esteja em conformidade com as especificações.

Promovendo a conformidade: reprimindo tutoriais e mercadorias ilegais de produtos de IA

A ação especial também se concentra na promoção de produtos de IA. Tutoriais que ensinam o uso de produtos de IA fora de conformidade para criar vídeos de mudança de rosto e de voz, a venda de produtos fora de conformidade, como "sintetizadores de voz" e "ferramentas de mudança de rosto", e o marketing e a promoção de produtos de IA fora de conformidade estão todos incluídos na remediação. Os promotores têm a responsabilidade de verificar a conformidade dos produtos de IA antes de optar por promovê-los. As plataformas precisam fortalecer a auditoria de conteúdo, não apenas para garantir que o conteúdo em si seja legal, mas também para ter a capacidade de identificar e auditar a conformidade dos produtos de IA promovidos no conteúdo, por exemplo, por meio da triagem inicial de modelos semânticos, complementada por intervenção manual.

Conformidade do corpus: fontes de dados de treinamento e gerenciamento em foco

A conformidade dos dados de treinamento é a base da segurança do modelo de IA. O artigo 7 das Medidas Provisórias enfatiza que os provedores de serviços devem usar dados e modelos subjacentes de fontes legítimas. Os Requisitos Básicos para a Segurança de Serviços de IA Generativa (doravante denominados Requisitos Básicos) são ainda mais refinados, estipulando que, se o corpus contiver mais de 51 TP3T de informações ilegais e indesejáveis, a fonte não deverá ser coletada. Ao mesmo tempo, a diversidade de fontes de dados, os protocolos de código aberto a serem seguidos, os registros de dados coletados automaticamente e os procedimentos legais para a aquisição de dados comerciais estão claramente definidos.

Devido à privacidade dos dados e à confidencialidade técnica, a regulamentação do corpus de treinamento é bastante difícil e geralmente assume a forma de questionamento e prova material. As empresas também enfrentam grandes desafios no gerenciamento de grandes quantidades de dados de treinamento com fontes complexas e qualidade variável. Os Requisitos Básicos recomendam que as empresas combinem filtragem de palavras-chave, triagem de modelos de classificação e amostragem manual para limpar informações ilegais e indesejáveis no corpus.

Conformidade do mecanismo: medidas aprimoradas de gerenciamento de segurança

As empresas precisam estabelecer mecanismos de segurança, como auditoria de conteúdo e reconhecimento de intenção, que sejam adequados à escala de seus negócios, bem como um processo de gerenciamento eficaz para contas violadoras e um sistema regular de autoavaliação de segurança. Para serviços como respostas automáticas de IA acessadas por meio de interfaces de API, as plataformas sociais precisam estar atentas e ser rigorosas. O Capítulo 7 dos Requisitos Básicos exige que os provedores de serviços monitorem as entradas dos usuários e tomem medidas como a restrição de serviços para usuários que repetidamente inserem informações ilegais. Além disso, as empresas devem ter uma equipe de supervisão compatível com a escala de seus serviços, responsável por acompanhar as políticas e analisar as reclamações para melhorar a qualidade e a segurança do conteúdo. Um sólido mecanismo de controle de riscos é um pré-requisito para o lançamento de produtos de IA.

Conformidade com a rotulagem: implementação de requisitos de rotulagem para conteúdo gerado por IA

Para aumentar a transparência, as Medidas para Marcação de Conteúdo Sintético Gerado por Inteligência Artificial (doravante denominadas Medidas de Marcação) estipulam que os provedores de serviços devem adicionar marcações explícitas ou implícitas ao conteúdo profundamente sintetizado e garantir que as marcações explícitas sejam incluídas no arquivo e que as marcações implícitas sejam adicionadas aos metadados quando o usuário baixar ou copiar o arquivo. A abordagem é acompanhada pelo padrão nacional "Network Security Technology Artificial Intelligence Generated Synthetic Content Identification Method" (Método de identificação de conteúdo sintético gerado por inteligência artificial de tecnologia de segurança de rede), que entrará em vigor a partir de 1º de setembro de 2025. As empresas devem realizar autoverificações com base nisso e implementar meios técnicos para detectar conteúdo gerado por IA em suas plataformas e fornecer alertas para conteúdo suspeito. Os órgãos reguladores também podem aprimorar a educação do usuário para melhorar o reconhecimento público do conteúdo gerado por IA.

Domain Compliance: foco nos riscos de segurança dos principais setores

Os produtos de IA que foram registrados para fornecer serviços de perguntas e respostas em áreas importantes, como saúde, finanças e menores de idade, devem estabelecer auditorias de segurança e medidas de controle específicas do setor. Impedir o fenômeno da "prescrição de IA", induzindo o investimento ou usando a "ilusão de IA" para enganar os usuários. A governança de conformidade nessas áreas específicas é complexa e segmentada, exigindo conhecimento de especialistas no domínio e um corpo de conformidade especializado. Os órgãos reguladores do setor e as empresas de fachada desempenharão um papel fundamental na definição de padrões e na garantia de que as medidas de segurança estejam em vigor. As soluções genéricas incluem detecção de alucinações, aprovação manual de operações importantes etc. para proteger contra o risco de perda de controle da IA.

Fase II: reprimir o uso de IA para atividades ilegais e ilícitas

A segunda fase da ação especial se concentrará no uso da tecnologia de IA para produzir e disseminar rumores, informações imprecisas, conteúdo pornográfico e vulgar, além de se passar por outras pessoas e participar de atividades de esquadrão cibernético.

Combater o uso de IA para criar e publicar rumores

O escopo da remediação inclui a fabricação de boatos relacionados a assuntos atuais e à subsistência das pessoas do nada, a interpretação maliciosa de políticas, a fabricação de detalhes com base em emergências, a apresentação de informações oficiais, bem como a orientação maliciosa por meio da exploração do viés cognitivo da IA. A Plataforma Conjunta de Dissipação de Boatos da Internet da China está em operação há muito tempo, mas na era da IA, o custo reduzido da produção de boatos e o aumento da fidelidade representam novos desafios de governança. A regulamentação se baseia principalmente no monitoramento da opinião pública e nos relatórios dos usuários, e as penalidades para boatos sobre IA em áreas importantes podem ser aumentadas. Os provedores de serviços precisam melhorar sua capacidade de detectar rumores gerados por IA, como o uso de ferramentas de IA para calibrar a precisão do conteúdo, monitorar o comportamento anormal da conta e verificar manualmente o conteúdo do ponto de acesso.

Limpar o uso de IA para produzir e publicar informações imprecisas

Esses comportamentos incluem juntar e editar gráficos e vídeos não relacionados para gerar informações mistas, borrar e alterar elementos factuais, repassar notícias antigas, publicar conteúdo exagerado ou pseudocientífico relacionado a campos profissionais e disseminar superstições com a ajuda de adivinhação e adivinhação por IA, e assim por diante. Em comparação com os rumores, as informações imprecisas podem ser menos subjetivas e maliciosas, mas sua natureza oculta e seu possível impacto não podem ser ignorados. A governança depende principalmente das plataformas de conteúdo para fortalecer a construção ecológica, identificar conteúdo de baixa qualidade por meios técnicos e tomar medidas para restringir a disseminação de conteúdo e criadores relevantes ou impor penalidades.

Retificação do uso de IA para produzir e distribuir conteúdo pornográfico e vulgar

O uso de IA para gerar imagens e vídeos pornográficos ou indecentes, como "despir-se com um clique" e desenhar com IA, bem como a produção de pornografia leve, imagens pornográficas de segunda geração, violência sangrenta, imagens grotescas e grotescas e "pequeno texto amarelo", estão todos sujeitos a repressão. Embora a tecnologia de IA melhore a eficiência da produção de conteúdo, ela também pode ser usada indevidamente para criar esse tipo de conteúdo indesejável. Os métodos tradicionais de verificação, como bibliotecas de palavras-chave, modelos semânticos e classificação de imagens ("modelos de identificação de pornografia"), são relativamente maduros para identificar conteúdo gerado pelo usuário (UGC). No entanto, a distribuição de recursos do conteúdo gerado por IA pode ser diferente da do UGC, e os provedores de serviços precisam prestar atenção à atualização dos dados de treinamento do modelo para manter a precisão da identificação.

Investigar e lidar com o uso de IA para se passar por outras pessoas para cometer infrações

Atos como a personificação de figuras públicas por meio de troca de rosto de IA, clonagem de voz e outras técnicas de falsificação aprofundadas para fins de engano ou lucro, falsificação e descrédito de figuras públicas ou históricas, uso de IA para se passar por amigos e parentes para cometer fraudes, bem como o uso indevido de IA para "ressuscitar os mortos" e o uso indevido de informações sobre os mortos, são todos o foco da remediação. Esses riscos decorrem do vazamento e do uso indevido de dados de privacidade pessoal. É importante aumentar a conscientização pública sobre a proteção da privacidade e, a longo prazo, estabelecer um mecanismo de rastreabilidade de dados para garantir a conformidade dos dados ao longo de toda a cadeia.

Combate ao uso de IA para atividades de mercenários cibernéticos

O "exército de água de IA" é uma nova variante do exército de água da rede. O uso da tecnologia de IA para "aumentar" o registro em massa e a operação de contas sociais, o uso de fazendas de conteúdo de IA ou lavagem de manuscritos de IA para gerar conteúdo homogeneizado de baixa qualidade em massa para diminuir o fluxo, bem como o uso de software de controle de grupo de IA, robôs sociais para diminuir a quantidade de controle e avaliação e outros comportamentos serão severamente reprimidos. A governança precisa começar pelas duas dimensões de conteúdo e conta, detectando conteúdo de baixa qualidade e AIGC dentro da plataforma, monitorando as características comportamentais das contas que publicam conteúdo AIGC e automatizando a intervenção rápida para aumentar o custo do mal dos exércitos de água.

Regulamentação do comportamento de serviços e aplicativos de produtos de IA

A produção e a disseminação de sites e aplicativos de IA falsificados e falsos, o fornecimento de funções não conformes por aplicativos de IA (por exemplo, o fornecimento de "pesquisa e expansão de lista quente" por ferramentas de criação), o fornecimento de serviços de diálogo pornográfico vulgar e suave por software de bate-papo social de IA, bem como a venda e a promoção de aplicativos, serviços ou cursos de IA não conformes que desviam as pessoas do uso de produtos de IA, estão todos cobertos pelo escopo da correção. Isso enfatiza novamente a conformidade do lançamento e da disseminação de produtos de IA e acrescenta a definição de "shell" e funções ilegais. Os provedores de serviços devem aderir à intenção original da tecnologia de atender às pessoas.

Proteção dos direitos e interesses de menores contra a IA

Os modelos de IA são baseados em estatísticas probabilísticas e há imprevisibilidade no conteúdo que eles geram, o que pode gerar valores errados e representar um risco potencial para o crescimento de menores. Portanto, a aplicação de IA em cenários de educação de menores requer cautela extra e controle rigoroso do uso dos cenários; em outros produtos com alta frequência de contato por menores, o modo de menores deve ser reforçado e os direitos de aplicação de IA devem ser restritos.