Introdução geral

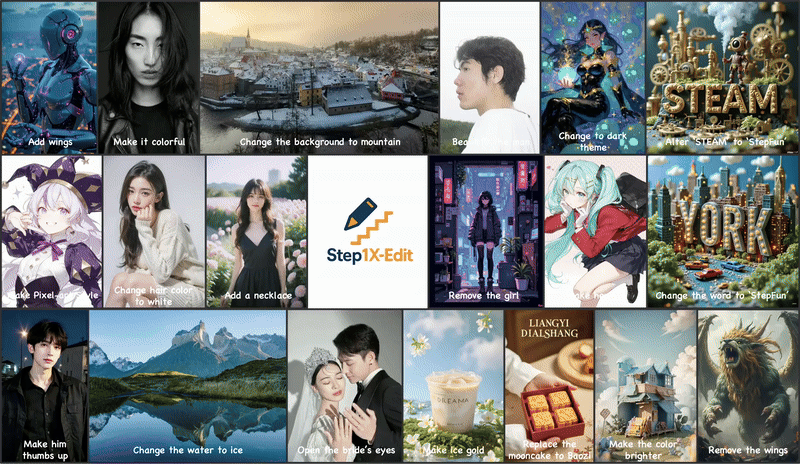

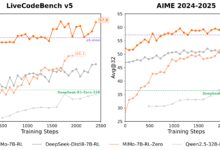

O Step1X-Edit é uma estrutura de edição de imagens de código aberto, desenvolvida pela equipe de IA da Stepfun e hospedada no GitHub, que combina um modelo multimodal de linguagem grande (Qwen-VL) e um transformador de difusão (DiT) para permitir que os usuários editem uma imagem com comandos simples de linguagem natural, como alterar o plano de fundo, remover um objeto ou alternar estilos. Lançado em 25 de abril de 2025, o desempenho do projeto é próximo ao dos modelos de código fechado, como GPT-4o e Gêmeos 2 Flash. O step1X-Edit fornece pesos de modelo, código de inferência e benchmarking GEdit-Bench para dar suporte a uma ampla variedade de cenários de edição. A licença Apache 2.0 permite o uso gratuito e o desenvolvimento comercial, atraindo desenvolvedores, designers e pesquisadores. O suporte da comunidade é ativo e lançou ComfyUI Plug-ins e versões quantificadas do FP8 para otimizar os requisitos de hardware.

Atualmente disponível em Etapa AI Experiência gratuita. Entretanto, os resultados reais da edição de imagens são ligeiramente diferentes do GPT-4o e do Gemini 2 Flash.

Lista de funções

- Suporta comandos de linguagem natural para edição de imagens, como "Change background to beach" ou "Remove people from photo".

- Análise de comandos de imagem e texto usando um modelo multimodal de linguagem grande (Qwen-VL) para gerar edições precisas.

- Gera imagens de alta qualidade com base no Diffusion Transformer (DiT) que mantém os detalhes da imagem original.

- Fornece benchmarking GEdit-Bench para avaliar o desempenho da edição sob comandos reais do usuário.

- Oferece suporte a modelos quantitativos FP8, reduz os requisitos de hardware e se adapta a GPUs com pouca memória.

- A integração com o plug-in ComfyUI simplifica o fluxo de trabalho e aprimora a experiência do usuário.

- Uma demonstração on-line está disponível, permitindo que os usuários experimentem os recursos de edição sem instalação.

- Pesos de modelo de código aberto e código de inferência para apoiar o desenvolvimento e a pesquisa secundários.

Usando a Ajuda

Processo de instalação

Para usar o Step1X-Edit, você precisa instalar o ambiente e fazer o download dos pesos do modelo. Abaixo estão as etapas detalhadas, adequadas para sistemas Linux (recomenda-se o Ubuntu 20.04 ou superior):

- Preparação do ambiente

Certifique-se de que o Python 3.10 ou superior esteja instalado em seu sistema, bem como o kit de ferramentas CUDA (recomenda-se o 12.1). Recomenda-se uma GPU (80 GB de RAM é o ideal, como a NVIDIA H800), mas as versões quantisadas do FP8 suportam menos RAM (16 GB ou 24 GB).conda create -n step1x python=3.10 conda activate step1x

- armazém de clones

Faça o download do código do projeto Step1X-Edit no GitHub:git clone https://github.com/stepfun-ai/Step1X-Edit.git cd Step1X-Edit - Instalação de dependências

Instale o PyTorch (recomenda-se a versão 2.3.1 ou 2.5.1) e as bibliotecas relacionadas:pip install torch==2.3.1 torchvision --index-url https://download.pytorch.org/whl/cu121 pip install -r requirements.txtInstale o Flash Attention (opcional, para raciocínio acelerado):

pip install flash-attn --no-build-isolationSe você tiver problemas com a instalação do Flash Attention, poderá consultar o script oficial para gerar um arquivo wheel pré-compilado adequado ao seu sistema:

python scripts/find_flash_attn_wheel.py - Download dos pesos do modelo

Faça o download dos pesos do modelo e do autocodificador variável (VAE) do Hugging Face ou do ModelScope:- Etapa 1X-Editar modelo:

step1x-edit-i1258.safetensors(aproximadamente 24,9 GB) - VAE:

vae.safetensors(aproximadamente 335 MB) - Modelo Qwen-VL:

Qwen/Qwen2.5-VL-7B-Instruct

Downloads automatizados usando scripts Python:

from huggingface_hub import snapshot_download import os target_dir = "models/step1x" os.makedirs(target_dir, exist_ok=True) # 下载 Step1X-Edit 模型 snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["step1x-edit-i1258.safetensors"]) # 下载 VAE snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["vae.safetensors"]) # 下载 Qwen-VL qwen_dir = os.path.join(target_dir, "Qwen2.5-VL-7B-Instruct") snapshot_download(repo_id="Qwen/Qwen2.5-VL-7B-Instruct", local_dir=qwen_dir) - Etapa 1X-Editar modelo:

- raciocínio de execução

Edite uma imagem usando o script de raciocínio fornecido. Por exemplo, edite uma imagem e altere o plano de fundo:python scripts/run_inference.py --image_path assets/demo.png --prompt "将背景改为夜空" --output_path output.pngDescrição do parâmetro:

--image_pathDigite o caminho da imagem.--promptComandos de edição (por exemplo, "change sky to sunset").--output_pathCaminho da imagem de saída.--size_levelResolução: Resolução (padrão 512x512, 1024x1024 requer mais memória).--seedSementes aleatórias para controlar a consistência da geração.

Usando o plug-in ComfyUI

O Step1X-Edit oferece um plug-in ComfyUI para usuários que desejam integrá-lo aos fluxos de trabalho.

- Clone o repositório de plug-ins do ComfyUI:

cd path/to/ComfyUI/custom_nodes git clone https://github.com/quank123wip/ComfyUI-Step1X-Edit.git - Coloque os pesos do modelo no

ComfyUI/models/Step1x-EditCatálogo:step1x-edit-i1258.safetensorsvae.safetensors- Pasta do modelo Qwen-VL:

Qwen2.5-VL-7B-Instruct

- Inicie o ComfyUI e carregue o nó Step1X-Edit.

- Na interface ComfyUI, carregue uma imagem, insira um comando de edição (por exemplo, "Adicionar asas") e execute o fluxo de trabalho para gerar o resultado.

Funções principais

- editor de linguagem natural

O usuário faz upload de uma imagem e insere um comando de texto. Por exemplo, para alterar o plano de fundo de uma foto para uma vista da montanha, digite "change background to mountain view". O modelo analisa o comando por meio do Qwen-VL, extrai a semântica e gera uma nova imagem em conjunto com o DiT. Recomenda-se que os comandos sejam claros e específicos, por exemplo, "Change sky to blue starry sky" é mais eficaz do que "Beautify sky". - Remoção ou adição de objetos

Comandos como "Remover uma pessoa de uma foto" ou "Adicionar uma árvore". O modelo mantém o restante da imagem e edita a área especificada com precisão. Em cenas complexas, vários ajustes dos comandos podem otimizar os resultados. - mudança de estilo

Há suporte para edição estilizada, por exemplo, "converter imagem para o estilo pixel art" ou "alterar para o estilo Miyazaki". O modelo é difundido para produzir uma imagem estilizada. - Demonstração on-line

Visite o espaço Hugging Face (https://huggingface.co/spaces/stepfun-ai/Step1X-Edit), carregue uma imagem, insira as instruções e experimente diretamente. Cada geração é limitada pelo tempo de GPU e os usuários gratuitos têm duas tentativas.

advertência

- Requisitos de hardwareA versão quantificada FP8 pode ser reduzida para 16 GB de memória para GPUs como a 3090 Ti.

- Otimização de comandosA edição complexa requer instruções detalhadas, como "mude o plano de fundo para montanhas nevadas e mantenha os personagens do primeiro plano inalterados".

- Suporte à comunidadeO repositório do GitHub tem uma comunidade ativa, portanto, verifique os Problemas ou as Discussões se tiver problemas.

cenário do aplicativo

- criação de conteúdo

Os designers usam o Step1X-Edit para alterar rapidamente o plano de fundo ou ajustar o estilo dos materiais publicitários. Por exemplo, altere o plano de fundo de uma foto de produto para um tema de férias para aumentar o apelo visual. - Edição de fotos pessoais

Os usuários comuns podem embelezar suas fotos, como remover a desordem do plano de fundo ou alterar uma foto diurna para uma noturna, por meio de demonstrações on-line que são fáceis de usar e não exigem habilidades profissionais. - Otimização de produtos de comércio eletrônico

As plataformas de comércio eletrônico usam o Step1X-Edit para gerar imagens de exibição de produtos em diferentes cenários, como colocar roupas em um fundo de praia ou cidade para economizar nos custos de filmagem. - pesquisa acadêmica

Os pesquisadores usam o conjunto de dados do GEdit-Bench e os pesos do modelo para desenvolver novos algoritmos de edição de imagens ou comparar o desempenho do modelo.

QA

- Quais resoluções são compatíveis com o Step1X-Edit?

Suporta resoluções de 512x512 e 1024x1024. 512x512 é mais rápido e requer menos memória; 1024x1024 é mais detalhado e requer mais memória. - Como posso otimizar meus resultados de edição?

Use instruções específicas e evite descrições vagas. Tentar redações diferentes várias vezes pode melhorar os resultados. Por exemplo, "mudar o céu para um pôr do sol vermelho" é mais claro do que "mudar o céu". - Ele é compatível com comandos em chinês?

Sim, o modelo suporta comandos em chinês com resultados comparáveis aos do inglês. Recomenda-se descrever os requisitos em uma linguagem concisa. - FP8 Qual é a diferença entre as versões quantificadas?

A versão FP8 exige menos memória (16 GB para ser executada), mas pode sacrificar um pouco os detalhes. Ideal para usuários com recursos de hardware limitados. - Ele precisa estar conectado em rede para funcionar?

Não é necessário ter conexão com a Internet para executar localmente. As demonstrações on-line exigem acesso ao espaço do Hugging Face.