综合介绍

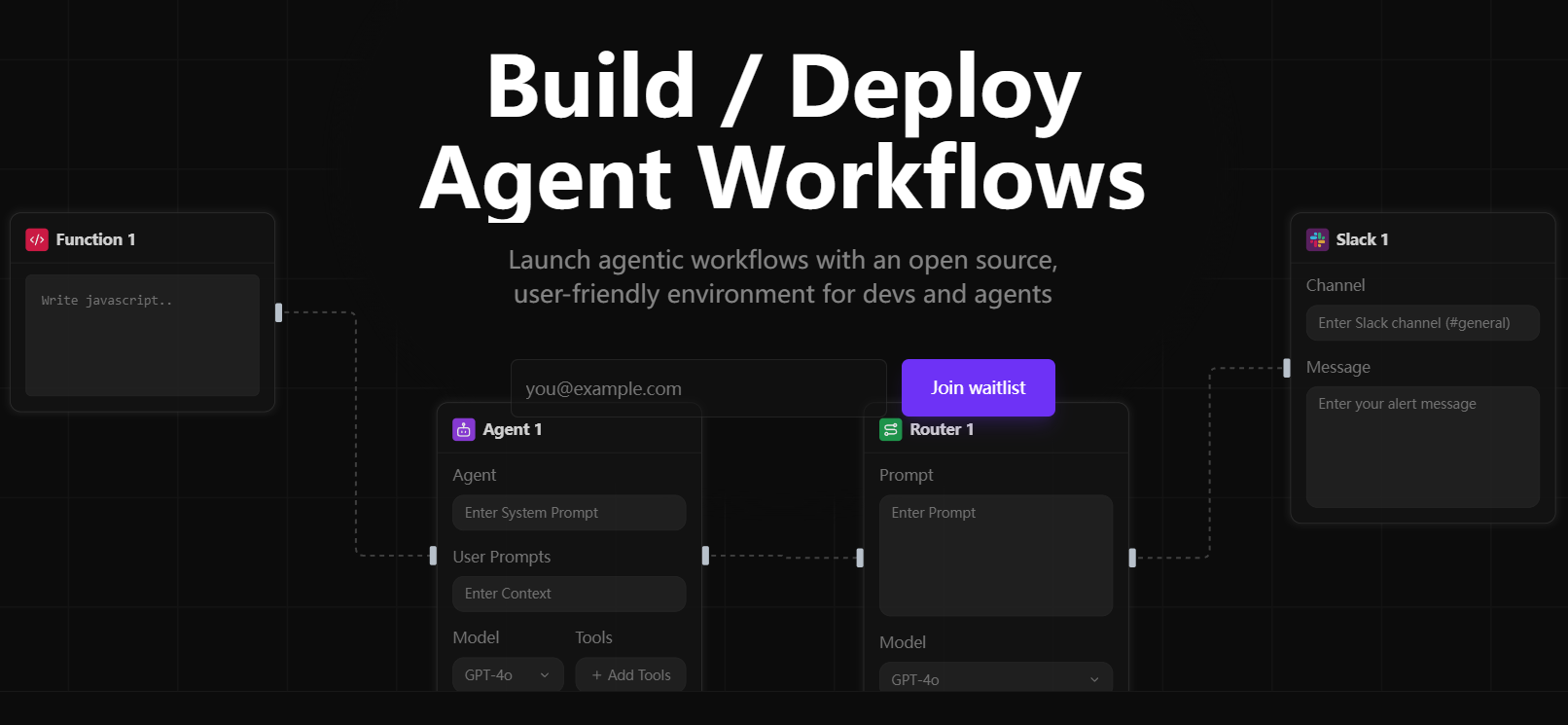

Sim Studio 是一个开源的 AI 代理工作流构建平台,专注于通过轻量、直观的可视化界面帮助用户快速设计、测试和部署大型语言模型(LLM)工作流。用户无需深入编程即可通过拖拽方式创建复杂的多代理应用。它支持本地和云端模型,兼容多种工具集成,如 Slack 和数据库。Sim Studio 采用模块化设计,适合开发者、研究人员和企业用户。官方提供云托管版本(https://simstudio.ai)和自托管选项,满足不同需求。

当下AI代理框架百花齐放,为什么我会特别推荐 Sim Studio 呢?我整理了一下目前主流的几款开源AI代理框架的特点:

| 框架名称 | 核心范式 | 主要优势 | 适用场景 |

|---|---|---|---|

| LangGraph | 基于图的提示工作流 | 显式DAG控制、分支和调试 | 复杂多步骤任务,高级错误处理 |

| OpenAI Agents SDK | OpenAI高级工具链 | 集成网络和文件搜索等工具 | 依赖OpenAI生态系统的团队 |

| Smolagents | 以代码为中心的最小代理循环 | 简单设置,直接代码执行 | 不需要复杂编排的快速自动化任务 |

| CrewAI | 多代理协作(crews) | 基于角色的并行工作流,共享记忆 | 需要多个专家协同的复杂任务 |

| AutoGen | 异步多代理聊天 | 实时对话,事件驱动 | 需要实时并发和多LLM"声音"交互的场景 |

| Sim Studio | 可视化工作流构建器 | 直观界面,快速部署,开源灵活 | 快速原型设计和生产环境部署 |

目前市场上有不少低代码/无代码的AI代理构建平台,我整理了一下它们与 Sim Studio 的对比:

| 平台 | 特点 | 适用场景 | 价格 |

|---|---|---|---|

| Vertex AI Builder | 企业级无代码平台,复杂API | 大型企业工作流自动化 | 付费 |

| Beam AI | 水平平台,支持多种预制代理 | 多领域自动化(合规、客服等) | 付费 |

| Microsoft Copilot Studio | 低代码,1200+数据连接器 | 内部聊天机器人,订单管理 | 付费 |

| Lyzr Agent Studio | 模块化,适合原型设计 | 财务、人力资源自动化 | 付费 |

| Sim Studio | 开源,可视化界面,灵活部署 | 从原型到生产的全流程 | 免费开源 |

可以看出,作为开源项目, Sim Studio 在功能与灵活性上毫不逊色,而且没有使用门槛的资金压力。

功能列表

- 可视化工作流编辑器 :通过拖拽界面设计 AI 代理工作流,支持条件逻辑和多步骤任务。

- 多模型支持 :兼容云端和本地 LLM,如通过 Ollama 运行的本地模型。

- 工具集成 :支持连接外部工具,如 Slack、数据库,扩展代理功能。

- API 部署 :一键生成工作流 API,方便集成到其他系统。

- 本地部署 :通过 Docker 或手动方式支持自托管,适合隐私敏感场景。

- 模块化扩展 :允许用户自定义功能块和工具,增强灵活性。

- 日志与调试 :提供详细日志,便于工作流优化和错误排查。

- 开发容器支持 :通过 VS Code 开发容器简化本地开发环境搭建。

使用帮助

Sim Studio 的核心是其轻量、直观的工作流构建功能。以下详细介绍安装流程、主要功能操作及特色功能使用方法,确保用户能快速上手。

安装流程

Sim Studio 提供三种自托管方式:Docker(推荐)、开发容器和手动安装。以下以 Docker 和手动安装为主,开发容器适合熟悉 VS Code 的开发者。

方式 1:Docker 安装(推荐)

Docker 提供一致的运行环境,适合大多数用户。需先安装 Docker 和 Docker Compose。

- 克隆代码库

在终端运行:git clone https://github.com/simstudioai/sim.git cd sim

- 配置环境变量

复制并编辑环境文件:cp sim/.env.example sim/.env

在 .env 文件中配置:

- BETTER_AUTH_SECRET:生成随机密钥,用于认证。

- RESEND_API_KEY:用于邮箱验证,若不设置,验证码会输出到控制台。

- 数据库设置:默认使用 PostgreSQL,需确保数据库服务运行。

- OLLAMA_HOST:若使用本地模型,设为 http://host.docker.internal:11434。

- 启动服务

运行以下命令:docker compose up -d --build

或使用脚本:

./start_simstudio_docker.sh

服务启动后,访问 http://localhost:3000/w/ 进入工作流界面。

- 管理服务

- 查看日志:

docker compose logs -f simstudio

- 停止服务:

docker compose down

- 重启服务(代码更新后):

docker compose up -d --build

- 查看日志:

- 使用本地模型

若需本地 LLM(如 LLaMA),拉取模型:./sim/scripts/ollama_docker.sh pull <model_name>

启动支持本地模型的服务:

./start_simstudio_docker.sh --local

或根据硬件选择:

# 有 NVIDIA GPU docker compose up --profile local-gpu -d --build # 无 GPU docker compose up --profile local-cpu -d --build

若已有 Ollama 实例,修改 docker-compose.yml 添加:

extra_hosts: - "host.docker.internal:host-gateway" environment: - OLLAMA_HOST=http://host.docker.internal:11434

方式 2:手动安装

适合需要自定义环境的开发者,需安装 Node.js、npm 和 PostgreSQL。

- 克隆并安装依赖

git clone https://github.com/simstudioai/sim.git cd sim/sim npm install

- 配置环境

复制并编辑环境文件:cp .env.example .env

配置 BETTER_AUTH_SECRET、数据库连接等。

- 初始化数据库

推送数据库架构:npx drizzle-kit push

- 启动开发服务器

npm run dev

访问 http://localhost:3000。

方式 3:开发容器

- 在 VS Code 中安装 Remote - Containers 扩展。

- 打开项目目录,点击“Reopen in Container”。

- 运行 npm run dev 或 sim-start 启动服务。

主要功能操作

Sim Studio 的核心是可视化工作流编辑器,以下是操作步骤:

创建工作流

- 登录 Sim Studio(http://localhost:3000/w/)。

- 点击“新建工作流”,进入编辑器。

- 拖拽“代理”节点,选择 LLM(云端或本地模型)。

- 添加“工具”节点(如 Slack 或数据库),配置参数。

- 使用“条件逻辑”节点设置分支逻辑。

- 连接节点,保存工作流。

测试工作流

- 点击“测试”,输入示例数据。

- 查看输出和日志,检查节点执行情况。

- 根据需要调整节点或逻辑,重新测试。

部署工作流

- 点击“部署”,选择“生成 API”。

- 获取 API 端点(如 http://localhost:3000/api/workflow/<id>)。

- 测试 API:

curl -X POST http://localhost:3000/api/workflow/<id> -d '{"input": "示例数据"}'

调试工作流

- 在编辑器中查看“日志”,检查节点输入输出。

- 使用版本控制保存工作流快照,便于回滚。

特色功能操作

- 本地模型支持 :通过 Ollama 运行本地模型,适合隐私敏感场景。配置后,在代理节点选择模型,测试性能。

- 工具集成 :以 Slack 为例,在工具节点输入 API Token,设置消息目标,测试消息发送功能。

- 开发容器 :通过 VS Code 容器化开发,自动配置环境,适合快速迭代。

注意事项

- Docker 安装需确保端口 3000 未被占用。

- 本地模型需要较高硬件配置(建议 16GB 内存,GPU 可选)。

- 生产环境需配置 RESEND_API_KEY 和 HTTPS。

- 定期更新代码:

git pull origin main docker compose up -d --build

技术栈

Sim Studio 使用现代技术栈,确保性能和开发效率:

- 框架 :Next.js(App Router)

- 数据库 :PostgreSQL + Drizzle ORM

- 认证 :Better Auth

- 界面 :Shadcn、Tailwind CSS

- 状态管理 :Zustand

- 流程编辑器 :ReactFlow

- 文档 :Fumadocs

应用场景

- 自动化客服

设计多代理工作流,集成数据库和 Slack,自动回复客户问题并通知人工客服,适合电商平台。 - 数据分析

构建工作流从数据库提取数据,调用 LLM 生成报告,部署为 API,适合金融分析。 - 教育工具

创建交互式学习代理,结合本地模型回答问题,集成测试题生成工具,适合在线教育。

QA

- Sim Studio 是否支持 Windows?

支持 Windows,但需安装 Docker Desktop 或 Node.js。推荐 Docker 方式以确保环境一致。 - 如何连接现有 Ollama 实例?

修改 docker-compose.yml,添加 host.docker.internal 映射,设置 OLLAMA_HOST。 - 本地模型需要什么硬件?

建议 16GB 内存,GPU 可提升性能,低配设备可能运行缓慢。 - 如何贡献代码?

参考 https://github.com/simstudioai/sim/blob/main/.github/CONTRIBUTING.md。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...