综合介绍

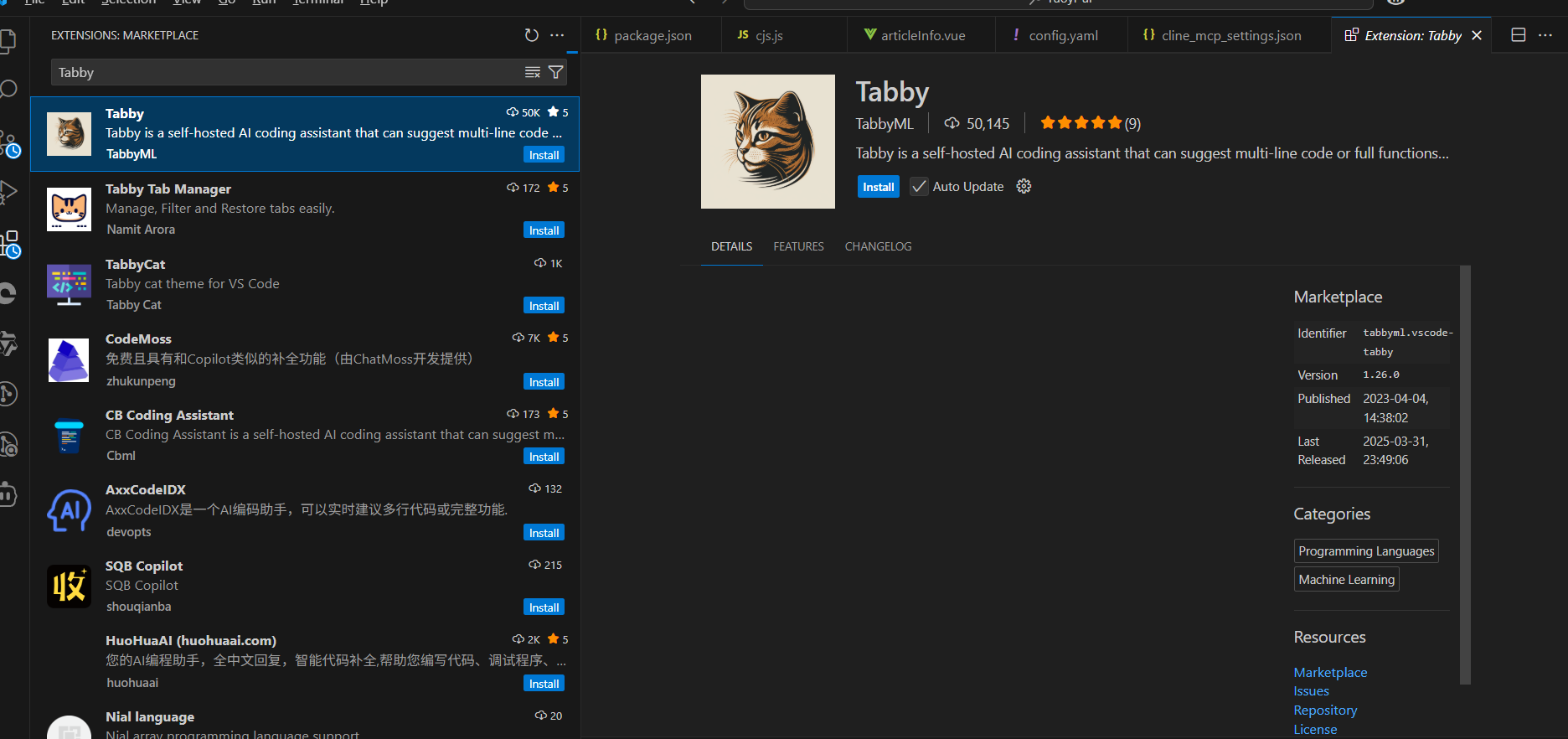

Tabby 是一个开源的 AI 编程助手,由 TabbyML 团队开发,用户可以自己部署在本地或服务器上。它提供类似 GitHub Copilot 的功能,比如代码自动补全和智能问答,但最大的特点是自托管,不依赖云服务或数据库,数据完全由用户控制。Tabby 支持多种编程语言,能集成到 VSCode、Vim 等开发工具中。官方数据显示,截至 2025 年 4 月,最新版本 v0.24.0 已支持 LDAP 认证和后台任务通知,功能持续优化。它适合注重隐私的开发者或团队使用。

功能列表

- 代码自动补全: 输入代码时,实时建议单行或多行代码,提升效率。

- 智能聊天助手: 通过对话解答编程问题,或生成代码片段。

- 自托管部署: 在本地或云端运行,保护数据隐私,支持自定义。

- 多模型支持: 可使用 StarCoder-1B、Qwen2-1.5B 等开源模型。

- 上下文感知: 理解代码上下文,提供精准建议。

- IDE 集成: 支持 VSCode、Vim、IntelliJ 等主流编辑器。

- 代码浏览器: 浏览项目代码,支持搜索和导航功能。

- 使用统计: 查看代码补全和聊天的使用数据。

- LDAP 认证: 企业用户可通过 LDAP 管理权限(v0.24.0 新增)。

使用帮助

安装流程

Tabby 需要用户自己搭建,以下是基于 Docker 的详细步骤。

- 准备环境

- 确保已安装 Docker(版本 20.10 或以上)。

- 如果使用 GPU,需安装 NVIDIA 驱动和 CUDA Toolkit(推荐 11.8 或 12.x)。

- 预留至少 10GB 存储空间,用于模型和数据。

- 拉取镜像

在终端运行以下命令获取最新 Tabby:

docker pull tabbyml/tabby

- 启动服务器

使用以下命令启动,默认监听 8080 端口:

docker run -it --gpus all -p 8080:8080 -v $HOME/.tabby:/data tabbyml/tabby serve --model TabbyML/StarCoder-1B --device cuda --chat-model Qwen2-1.5B-Instruct

--gpus all: 启用 GPU 加速(无 GPU 可删除)。-p 8080:8080: 将容器端口映射到本地。-v $HOME/.tabby:/data: 数据存储在本地.tabby文件夹。--model: 指定代码补全模型,默认 StarCoder-1B。--chat-model: 指定聊天模型,默认 Qwen2-1.5B-Instruct。--device cuda: 使用 GPU,若无 GPU 改为cpu。

- 验证运行

启动后,访问http://localhost:8080。若显示欢迎页面或日志提示 “Listening at 0.0.0.0:8080”,则成功。 - 安装 IDE 扩展

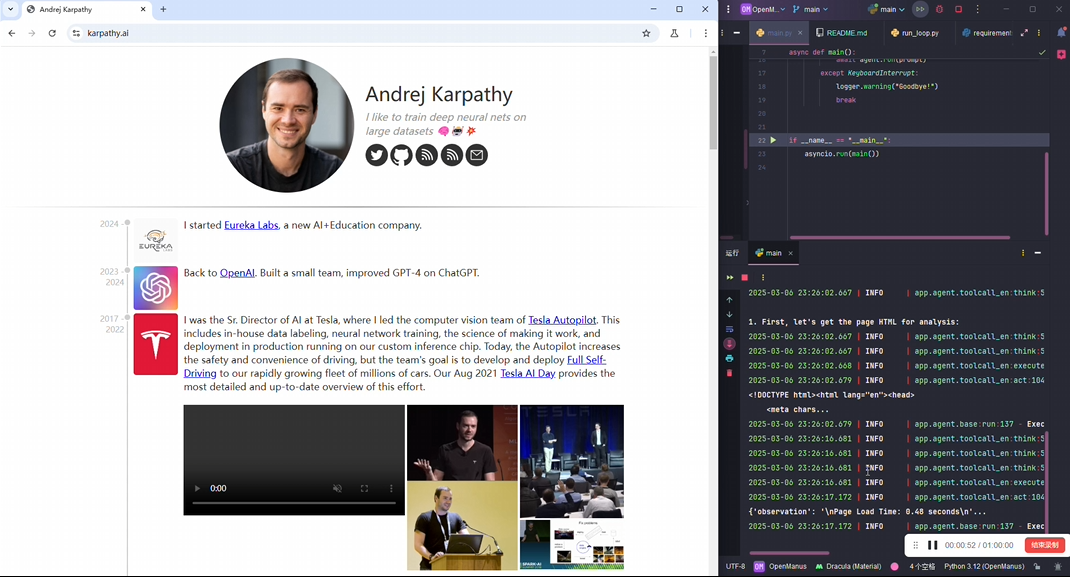

- VSCode: 在扩展市场搜索 “Tabby”,安装后设置服务器地址为

http://localhost:8080。 - Vim: 通过插件管理器安装

TabbyML/vim-tabby,运行npx tabby-agent --stdio连接。 - IntelliJ: 在 JetBrains Marketplace 搜索 “Tabby”,安装并配置地址。

主要功能操作

代码自动补全

- 操作步骤: 在 IDE 中输入代码,Tabby 会弹出建议框。按

Tab接受,Esc拒绝。 - 特色功能: 支持上下文感知。比如输入

def sort_list,可能建议:

def sort_list(lst):

return sorted(lst)

- 调整参数: 在

config.toml中修改max_input_length(默认 1024)和max_output_tokens(默认 512)。

智能聊天助手

- 打开方式: 在 VSCode 中,点击侧边栏的 Tabby 图标打开聊天面板。

- 使用方法: 输入问题,如“用 JavaScript 写一个数组去重函数”。Tabby 会返回:

function uniqueArray(arr) {

return [...new Set(arr)];

}

还能通过 @ 提及文件,添加上下文。

- 运行命令: 输入类似

dir的命令,查看模拟结果(v0.23.0 增强)。

代码浏览器

- 访问路径: 在 Web 界面点击 “Code Browser”。

- 操作流程: 输入关键词(如

class),搜索代码。支持按文件类型筛选,点击结果跳转到具体位置。 - 更新特性: v0.23.0 优化了浏览体验,支持更多导航选项。

补充说明

- 首次启动: 下载模型可能需要 5-10 分钟,视网络情况而定。

- 性能优化: 使用

--parallelism 4提高并发处理能力(需高配硬件)。 - 社区支持: 可通过 Slack(

links.tabbyml.com/join-slack)获取帮助。

应用场景

- 个人开发

一个前端开发者在本地部署 Tabby,用它补全 React 组件代码,节省重复输入时间。 - 企业协作

公司将 Tabby 部署在内部服务器,结合 LDAP 认证,团队成员通过聊天功能快速解决 bug。 - 教育培训

学生用 Tabby 学习 C++,通过聊天提问“指针是什么”,获得代码示例和解释。

QA

- Tabby 支持哪些模型?

默认支持 StarCoder-1B(代码补全)和 Qwen2-1.5B-Instruct(聊天),用户可更换其他开源模型。 - 自托管有什么优势?

数据不上传云端,完全本地化,适合隐私敏感场景,且可自由调整配置。 - 最低硬件要求是什么?

CPU 运行需 8GB 内存,GPU 运行需 16GB 内存和 4GB 显存。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...